개요

데이터 센터 네트워킹의 진화

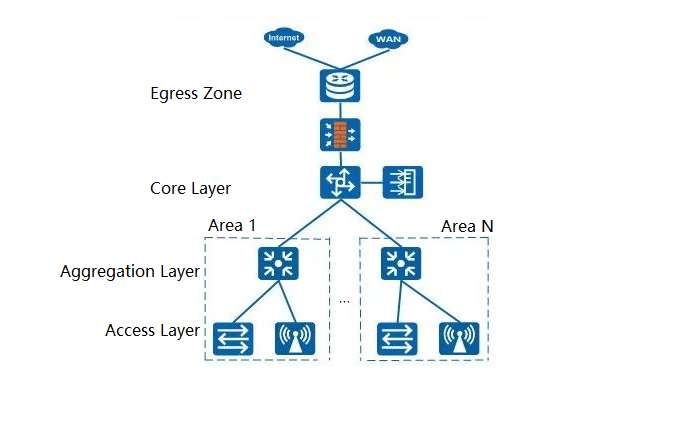

지난 수십 년 동안 데이터 센터 네트워킹은 단순한 LAN(Local Area Network)에서 복잡한 분산 시스템으로 대대적인 변화를 겪었습니다. 1990년대에는 데이터 센터가 주로 허브나 저사양 스위치를 통해 서버를 상호 연결하는 기본적인 2계층 스위칭 네트워크에 의존했습니다. 인터넷이 대중화되면서 기업들은 고성능 네트워크를 요구하기 시작했고, 이는 코어, 애그리게이션, 액세스라는 전통적인 XNUMX계층 아키텍처의 등장으로 이어졌습니다.

이 아키텍처는 당시 중소기업 데이터 센터의 요구 사항을 충족하는 동시에 기능을 명확하게 정의했습니다.

그러나 21세기에 접어들면서 클라우드 컴퓨팅, 빅데이터, 가상화의 부상은 네트워크에 새로운 과제를 안겨주었습니다. 기존의 XNUMX계층 아키텍처는 대역폭 병목 현상, 높은 지연 시간, 제한된 확장성과 같은 문제를 점차 노출시켰습니다. 예를 들어, 가상화 환경에서는 가상 머신 간의 동서 트래픽이 급증하는 반면, 기존 아키텍처는 남북 트래픽에 더 적합하여 새로운 트래픽 패턴에 비효율적이었습니다.

그리하여 2010년경부터 스파인-리프 아키텍처가 주목을 받기 시작하면서 평평한 디자인과 높은 성능 덕분에 현대 데이터 센터의 표준이 되었습니다.

스파인-리프 및 전통적인 3계층 아키텍처의 부상

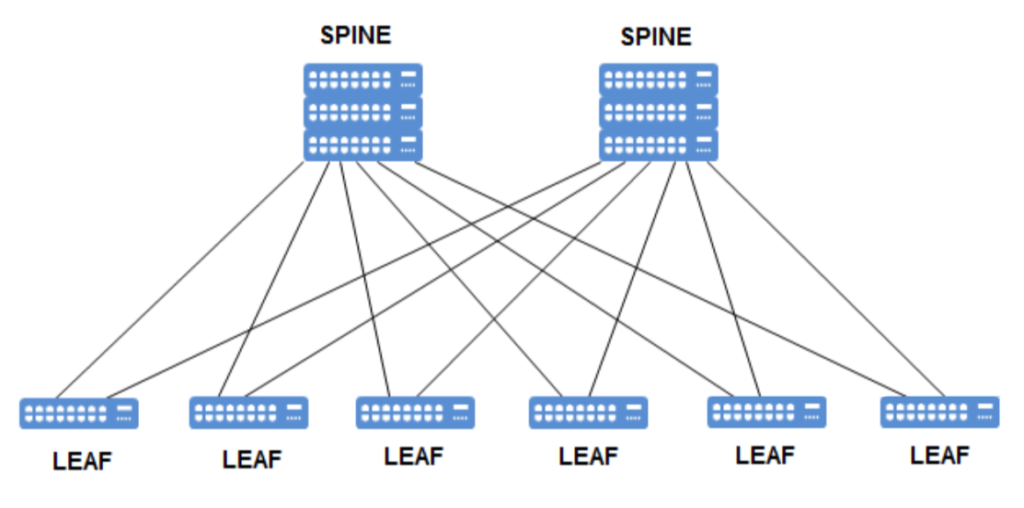

스파인-리프 아키텍처는 트래픽이 많은 환경에서 기존 3계층 아키텍처의 한계를 극복하기 위해 네트워크 계층을 줄이고 데이터 경로를 최적화합니다. 풀 메시 네트워크의 높은 연결성에서 영감을 받아 설계되었지만, 복잡성과 비용을 줄이기 위해 계층을 최적화했습니다.

또한, SDN(소프트웨어 정의 네트워킹)을 도입함으로써 Spine-Leaf는 동적 관리 및 자동화 기능을 강화하여 현대 데이터 센터에서의 지배력을 강화했습니다.

예를 들어, 구글과 아마존 같은 클라우드 컴퓨팅 대기업들은 대규모 분산 컴퓨팅 및 스토리지를 지원하기 위해 데이터 센터에 스파인-리프(Spine-Leaf) 아키텍처를 널리 도입했습니다. 이와 대조적으로, 기존의 3계층 아키텍처는 중소기업에는 여전히 적합하지만, 고부하 시나리오에서는 그 한계가 점점 더 뚜렷해지고 있습니다.

스파인-리프 구조에 대한 자세한 설명

척추-잎의 정의와 구조

스파인-리프 아키텍처는 단순하면서도 강력한 설계를 갖춘 2계층 네트워크 토폴로지입니다. 다음 두 계층으로 구성됩니다.

- 리프 계층: 서버, 저장 장치 또는 기타 엔드포인트를 직접 연결하여 데이터 액세스 및 전달을 처리합니다. 각 리프 스위치는 일반적으로 고밀도 포트(예: 48 x 10Gbps 포트)와 여러 개의 업링크 포트(예: 4 x 40Gbps 포트)를 갖추고 있습니다.

- 스파인 계층: 모든 리프 스위치를 연결하여 고대역폭, 저지연 통신 경로를 제공합니다. 스파인 스위치는 일반적으로 고속 포워딩에 중점을 둔 고성능 장치입니다.

스파인-리프 아키텍처에서는 모든 리프 스위치가 모든 스파인 스위치에 연결되지만, 리프 스위치는 서로 직접 연결되지 않습니다. 이러한 부분 메시 설계는 성능과 확장성 간의 균형을 유지합니다. 간단한 비유를 들어보면, 스파인 계층은 고속도로 허브 역할을 하고 리프 계층은 도시 출구 역할을 하여 모든 도시 간의 빠른 상호 연결을 가능하게 합니다.

2층 및 3층 스파인-리프 디자인

2층 척추-잎:

- 특징: Leaf 계층과 Spine 계층 간에 2계층 프로토콜(예: 이더넷)을 사용하여 MAC 주소를 통해 데이터를 전달합니다. 일반적으로 루프 방지를 위해 STP(Spanning Tree Protocol) 또는 MLAG 기술을 사용합니다.

- 적용 가능한 시나리오: 저지연 거래 시스템과 같이 지연 시간이 매우 낮아야 하는 소규모 데이터 센터나 환경.

- 예: 소규모 데이터 센터에 Leaf 스위치 4개와 Spine 스위치 2개가 구축되어 있습니다. 각 Leaf는 10Gbps 링크를 통해 모든 Spine 스위치에 연결되어 약 2대의 서버를 지원하는 Layer 100 네트워크를 형성합니다. MLAG(Multi-Link Aggregation)는 중복성을 위해 사용됩니다.

- 장점: 간단한 구성, 낮은 지연 시간(일반적으로 1ms 미만).

- 제한 사항: 브로드캐스트 스톰의 위험이 높고 확장성이 제한적입니다(2계층 도메인 크기에 의해 제약됨).

3층 척추-잎:

- 특징: Leaf 계층과 Spine 계층 간에 3계층 라우팅 프로토콜(예: OSPF, BGP)을 사용하여 IP 주소를 통해 데이터를 전달합니다. 부하 분산을 위해 ECMP(Equal-Cost Multi-Path Routing)를 자주 사용합니다.

- 적용 가능한 시나리오: 클라우드 컴퓨팅 환경 등 높은 확장성과 네트워크 격리가 필요한 대규모 데이터 센터.

- 예: 대규모 데이터 센터에 Leaf 스위치 16개와 Spine 스위치 4개가 구축되어 있습니다. 각 Leaf는 BGP 라우팅을 사용하여 40Gbps 링크를 통해 모든 Spine 스위치에 연결되며, 약 1000대의 서버를 지원합니다. ECMP는 모든 Spine 링크에 걸쳐 트래픽이 고르게 분산되도록 보장합니다.

- 장점: 확장성이 높고 네트워크 분할(예: VXLAN 분할)을 지원합니다.

- 제한 사항: 구성 복잡성이 높고 라우팅 프로토콜에 익숙해야 함.

핵심 장점 및 특징

- 높은 확장성: Leaf 또는 Spine 스위치를 추가하면 재설계 없이 네트워크를 쉽게 확장할 수 있습니다. 예를 들어 Leaf 스위치를 추가하려면 모든 Spine 스위치에 연결하기만 하면 됩니다.

- 낮은 지연 시간: 플랫 디자인 덕분에 전달 홉이 줄어들어, 일반적으로 기존 2계층 아키텍처보다 지연 시간이 짧습니다. 예를 들어, 서버 간 통신에는 리프(Leaf) → 스파인(Spine) → 리프(Leaf)의 XNUMX홉만 필요합니다.

- 높은 대역폭: 다중 경로는 트래픽이 많은 상황에서도 충분한 대역폭을 제공합니다. 예를 들어, 스파인 스위치 4개는 각 리프에 총 160Gbps의 업링크 대역폭을 제공할 수 있습니다.

- 높은 중복성: 다중 스파인 설계는 일부 링크나 장치에 장애가 발생하더라도 네트워크 연속성을 보장합니다. 예를 들어, 스파인 스위치 하나가 다운되더라도 다른 스위치들이 트래픽을 계속 처리할 수 있습니다.

예: 소규모 및 대규모 데이터 센터 스파인-리프 배포

- 소규모 데이터 센터: 한 스타트업이 리프 스위치 4대와 스파인 스위치 2대를 사용하는 스파인-리프(Spine-Leaf) 네트워크를 구축했습니다. 각 리프는 10Gbps 링크를 통해 스파인 스위치에 연결되어 100대의 서버를 지원합니다. 2계층 설계는 MLAG(MLag-based Aggregation) 기술을 사용하여 지연 시간을 0.8ms 미만으로 유지합니다. 이 회사는 주로 트래픽 수요가 낮은 웹 애플리케이션을 운영하며, 이 아키텍처는 초기 확장 요구를 충족합니다.

- 대규모 데이터 센터: 한 클라우드 제공업체가 3개의 Leaf 스위치와 32개의 Spine 스위치로 구성된 Layer 8 Spine-Leaf 네트워크를 구축했습니다. 각 Leaf는 BGP 라우팅을 사용하여 100Gbps 링크를 통해 Spine 스위치에 연결되며, 5000대의 서버를 지원합니다. 이 아키텍처는 VXLAN 분할을 활용한 대규모 가상화를 지원하여 네트워크 성능을 30% 향상시키고 지연 시간을 0.5ms로 단축합니다.

스파인-리프 아키텍처와 기존 3계층 아키텍처 비교

토폴로지 구조 비교

다음 표는 두 아키텍처의 토폴로지 구조를 비교한 것입니다.

| 아래 | 전통적인 3층 구조 | 스파인-리프 아키텍처 |

| Structure | 나무형: 접근(잎) → 집합(가지) → 핵심(줄기) | 그리드형: 데이터는 최단 경로를 통해 잎 사이를 이동합니다. |

| 레이어 | 3개의 계층(Core, Aggregation, Access) | 2개의 층(척추, 잎) |

| 입/출력 라인 | 잠재적 병목 현상이 있는 계층적 | 균형 잡힌 성능을 위한 부분 메시 |

기존의 3계층 아키텍처는 데이터가 잎(액세스)에서 가지(집계)를 거쳐 줄기(코어)로 흐르는 트리 구조를 지닙니다. 반면, 스파인-리프는 그리드 구조와 유사하여 잎들 간의 최단 경로 이동을 가능하게 합니다.

성능 및 지연 시간 분석

- 기존 3계층 아키텍처: 액세스에서 코어로 데이터를 전송하는 데 일반적으로 4~2번의 홉이 필요하여 지연 시간이 길어집니다(약 5~90ms). 특히 동서 트래픽이 급증하는 경우 집계 계층에 병목 현상이 발생할 수 있습니다. 예를 들어, 가상 머신 마이그레이션으로 인해 집계 포트 사용률이 XNUMX%를 초과할 수 있습니다.

- 스파인-리프: 리프에서 스파인으로의 데이터 전송은 1~2번의 홉만 필요하며, 지연 시간은 약 0.5~1ms로 매우 짧습니다. 다중 스파인 설계는 충분한 대역폭을 제공하여 병목 현상을 방지합니다. 예를 들어, ECMP는 모든 스파인 링크에 트래픽을 균등하게 분배합니다.

예: 데이터 센터 테스트에서 기존 3.2계층 아키텍처는 평균 지연 시간이 8ms였고, 피크 시간대 대역폭 사용량은 0.8Gbps로 제한되었습니다. Spine-Leaf는 지연 시간을 40ms로 줄이고 대역폭을 75Gbps로 높여 XNUMX%의 성능 향상을 달성했습니다.

확장성 및 관리 복잡성

- 기존 3계층 아키텍처: 확장 시 집계 및 코어 구성을 조정해야 하며, 복잡한 링크 계획 및 프로토콜 조정이 필요합니다. 예를 들어, 새로운 액세스 스위치를 추가하면 업링크 LACP(링크 집계 제어 프로토콜)를 재구성해야 할 수 있습니다. 규모가 커질수록 관리 복잡성도 크게 증가합니다.

- 스파인-리프: 리프 또는 스파인 스위치를 추가하면 간편하게 확장할 수 있습니다. 예를 들어, 리프 스위치를 추가하려면 모든 스파인 스위치에 연결하고 BGP 네이버를 업데이트하기만 하면 됩니다. BGP와 같은 프로토콜을 통해 대규모 네트워크 관리가 간소화되므로 관리 복잡성이 낮습니다.

데이터 센터 사례 연구

사례: 한 전자상거래 회사는 원래 액세스 스위치 8개, 애그리게이션 스위치 4개, 코어 스위치 2개로 구성된 1000계층 아키텍처를 사용하여 10대의 서버를 지원했습니다. 액세스 계층은 기가비트 포트를 사용했고, 애그리게이션 스위치는 2000Gbps 링크를 통해 코어 스위치에 연결되었습니다. 사업이 성장함에 따라 서버 수는 두 배인 5개로 늘어났고, 트래픽은 20Gbps에서 4Gbps로 급증했습니다. 애그리게이션 대역폭 부족으로 지연 시간이 16ms로 증가하여 데이터베이스 쿼리 및 페이지 로드 속도에 영향을 미쳐 사용자 경험이 저하되었습니다. 이 회사는 레이어 4 BGP 라우팅을 사용하는 리프 스위치 3개와 스파인 스위치 40개를 사용하는 스파인-리프(Spine-Leaf) 아키텍처로 전환했습니다. 각 리프는 160Gbps 링크를 통해 스파인에 연결되어 총 대역폭이 0.9Gbps로 증가했습니다. 전환 후 지연 시간은 40ms로 감소했고, 대역폭 사용률은 XNUMX% 증가하여 더 많은 동시 트래픽을 지원하고 고객 만족도를 크게 향상시켰습니다.

풀 메시 네트워크와 스파인-리프 네트워크의 관계

풀 메시 네트워크의 정의 및 특징

풀 메시 네트워크는 모든 장치가 다른 모든 장치에 직접 연결되는 고도로 연결된 토폴로지입니다. 예를 들어, 5노드 풀 메시 네트워크에서 각 노드는 4개의 링크를 가지므로 총 10개의 링크가 됩니다.

특징: 가장 낮은 지연 시간(1홉)과 가장 높은 중복성을 제공하지만, 배선 및 유지 관리 비용은 장치 수(N*(N-1)/2 링크)에 따라 XNUMX차적으로 증가합니다.

적용 가능한 시나리오: 금융 거래 시스템이나 소규모 클러스터와 같은 소규모 고성능 네트워크.

예: 한 무역 회사가 노드당 5Gbps 링크가 있는 10노드 풀 메시 네트워크를 구축했습니다. 지연 시간은 0.2ms로 매우 짧았지만, 배선 비용이 높았고, 노드를 6개로 확장하려면 5개의 추가 링크가 필요하여 복잡성이 급격히 증가했습니다.

스파인-리프의 부분 메시 디자인

연결성: 각 Leaf 스위치는 모든 Spine 스위치에 연결되어 부분 메시 토폴로지를 형성합니다. Leaf 스위치는 직접 연결되지 않으므로 배선 복잡성이 줄어듭니다. 예를 들어, Leaf 스위치 4개와 Spine 스위치 2개는 8개의 링크만 필요하지만, 전체 메시 토폴로지에서는 12개의 링크가 필요합니다.

장점: 성능과 비용의 균형을 이루므로 중대형 데이터 센터에 적합합니다.

풀메시와 스파인-리프의 비교 및 연결

| 아래 | 풀 메시 네트워크 | 스파인-리프 아키텍처 |

| 입/출력 라인 | 완전한 상호 연결(모든 장치가 다른 모든 장치와 연결됨) | 부분 메시(모든 척추에 잎이 있음) |

| 숨어 있음 | 가장 낮음(1홉) | 낮음(1-2홉) |

| 확장성 | 불량(링크의 2차 성장) | 높음(선형 확장) |

| 비용 | 높은 배선 및 유지 관리 | 균형 비용 |

연결: 스파인-리프(Spine-Leaf)는 풀 메시(full-mesh)의 고연결성 개념을 차용했지만, 복잡성을 줄이기 위해 계층화를 사용합니다. 예를 들어, 스파인 계층은 중앙 허브 역할을 하여 풀 메시 오버헤드를 방지하면서 효율적인 리프(Leaf) 통신을 보장합니다. 예: 한 금융 회사의 소규모 데이터센터는 스위치 10개로 풀 메시를 시도했는데, 스위치당 9개의 링크와 총 45개의 링크가 필요했습니다. 이는 높은 배선 비용과 유지 관리의 어려움을 야기했습니다. 스파인-리프(리브 5개, 스파인 2개)로 전환한 결과, 링크 수는 10개로 줄어들고 지연 시간은 0.2ms에서 0.6ms로 증가했지만, 비용은 50% 절감되고 확장성은 향상되었습니다.

척추-잎 구조에서 SDN의 시너지 효과

SDN의 기본 원칙

소프트웨어 정의 네트워킹(SDN)은 네트워크의 제어 평면과 데이터 평면을 분리하여 중앙 집중식 관리와 동적 구성을 가능하게 합니다.

- 제어 평면: SDN 컨트롤러(예: OpenFlow 컨트롤러)가 담당하며, 네트워크 정책 및 트래픽 경로를 관리합니다. 중앙 집중식 의사 결정을 위한 네트워크의 "두뇌" 역할을 합니다.

- 데이터 플레인: 스위치와 라우터에서 데이터 전달을 위해 실행됩니다. 컨트롤러의 명령을 수행하는 네트워크의 "무기" 역할을 합니다.

예를 들어, 기존 네트워크에서는 각 스위치가 독립적으로 OSPF를 실행하여 경로를 계산합니다. SDN에서는 컨트롤러가 라우팅 테이블을 중앙에서 계산하고 배포하여 장치 논리를 단순화합니다.

SDN이 스파인-리프 아키텍처를 어떻게 향상시키는가

SDN을 Spine-Leaf와 결합하면 네트워크 유연성과 효율성이 크게 향상됩니다.

- 동적 트래픽 최적화: SDN 컨트롤러는 스파인-리프 트래픽을 실시간으로 모니터링하고, 로드 밸런싱을 위해 경로를 동적으로 조정합니다. 예를 들어, 스파인 링크가 혼잡할 경우 컨트롤러는 다른 링크로 트래픽을 재라우팅할 수 있습니다.

- 자동 구성: SDN을 사용하면 VLAN, QoS 정책 등을 빠르게 구축하여 수동 설정 시간을 줄일 수 있습니다. 예를 들어, 100개의 Leaf 스위치에 VXLAN을 구성하는 데 단 몇 분밖에 걸리지 않습니다.

- 신속한 장애 복구: 스파인 또는 리프 장애 감지 시 SDN은 자동으로 백업 경로로 전환합니다. 예를 들어, 스파인에 장애가 발생하면 컨트롤러는 몇 초 만에 트래픽을 재할당합니다.

데이터 센터에서 SDN의 실용적 적용

사례: 한 클라우드 서비스 제공업체는 자동화된 트래픽 관리를 위해 자사의 스파인-리프 데이터 센터에 SDN 컨트롤러를 통합했습니다. 32개의 리프와 8개의 스파인을 통해 5000대의 서버를 지원했습니다. 트래픽이 최고조에 달했을 때, 스파인 링크 하나의 사용률이 90%에 도달했습니다. SDN은 트래픽을 동적으로 재분배하여 혼잡을 방지하고 성능을 25% 향상시켰습니다. 네트워크 구성 시간 또한 몇 시간에서 몇 분으로 단축되어 신규 서비스 구축을 가속화했습니다.

Spine-Leaf의 미래와 권장 사항

데이터 센터 네트워킹의 미래 동향

클라우드 컴퓨팅, AI, 5G의 급속한 발전으로 데이터 센터 네트워크는 더 높은 성능과 유연성을 요구하게 될 것입니다.

- 인텔리전스: AI 기반 네트워크 관리는 트래픽 패턴을 예측하고 성능을 최적화합니다. 예를 들어, AI는 과거 데이터를 기반으로 Spine-Leaf 부하 분산을 조정할 수 있습니다.

- 고대역폭: 400Gbps 또는 800Gbps 링크가 Spine-Leaf의 표준이 될 것입니다. 예를 들어, 공급업체들은 800Gbps 2023년에 스파인 스위치가 도입됩니다.

- 심층적인 통합: Spine-Leaf는 SDN 및 NFV(네트워크 기능 가상화)와 더욱 긴밀하게 융합될 것입니다. 예를 들어, NFV는 Leaf 계층에서 방화벽 기능을 가상화할 수 있습니다.

신기술과 Spine-Leaf의 통합

향후 Spine-Leaf 아키텍처에는 더욱 최첨단 기술이 통합될 예정입니다.

- AI 최적화: 머신러닝을 통해 네트워크 장애를 예측하고 경로를 선제적으로 조정합니다. 예를 들어, AI는 스파인 스위치 과부하 위험을 예측하고 트래픽을 사전에 우회시킬 수 있습니다.

- 제로 트러스트 보안: SDN과 결합하여 데이터 센터를 보호하는 동적 보안 정책을 구현합니다. 예를 들어, 각 Leaf 스위치는 SDN 지침에 따라 실시간으로 트래픽 소스를 확인할 수 있습니다.

제품 개요

스파인-리프 아키텍처는 평탄화, 고성능, 고확장성을 특징으로 하며, 기존의 코어-어그리게이션-액세스 아키텍처를 대체하여 현대 데이터센터의 초석으로 자리 잡았습니다. 풀 메시 네트워크의 고연결성 아이디어를 최적화하고 SDN의 동적 관리 기능을 활용함으로써 성능, 유연성, 관리 효율성 측면에서 엄청난 이점을 제공합니다.

관련 상품:

-

QSFP-DD-400G-SR8 400G QSFP-DD SR8 PAM4 850nm 100m MTP / MPO OM3 FEC 광 트랜시버 모듈

$149.00

QSFP-DD-400G-SR8 400G QSFP-DD SR8 PAM4 850nm 100m MTP / MPO OM3 FEC 광 트랜시버 모듈

$149.00

-

QSFP-DD-400G-DR4 400G QSFP-DD DR4 PAM4 1310nm 500m MTP / MPO SMF FEC 광 트랜시버 모듈

$400.00

QSFP-DD-400G-DR4 400G QSFP-DD DR4 PAM4 1310nm 500m MTP / MPO SMF FEC 광 트랜시버 모듈

$400.00

-

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC 광 트랜시버 모듈

$450.00

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC 광 트랜시버 모듈

$450.00

-

QSFP-DD-400G-FR4 400G QSFP-DD FR4 PAM4 CWDM4 2km LC SMF FEC 광 트랜시버 모듈

$500.00

QSFP-DD-400G-FR4 400G QSFP-DD FR4 PAM4 CWDM4 2km LC SMF FEC 광 트랜시버 모듈

$500.00

-

QSFP-DD-400G-XDR4 400G QSFP-DD XDR4 PAM4 1310nm 2km MTP/MPO-12 SMF FEC 광 트랜시버 모듈

$580.00

QSFP-DD-400G-XDR4 400G QSFP-DD XDR4 PAM4 1310nm 2km MTP/MPO-12 SMF FEC 광 트랜시버 모듈

$580.00

-

QSFP-DD-400G-LR4 400G QSFP-DD LR4 PAM4 CWDM4 10km LC SMF FEC 광 트랜시버 모듈

$600.00

QSFP-DD-400G-LR4 400G QSFP-DD LR4 PAM4 CWDM4 10km LC SMF FEC 광 트랜시버 모듈

$600.00

-

QDD-4X100G-FR-Si QSFP-DD 4 x100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS3.0 실리콘 포토닉스 광 트랜시버 모듈

$650.00

QDD-4X100G-FR-Si QSFP-DD 4 x100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS3.0 실리콘 포토닉스 광 트랜시버 모듈

$650.00

-

QDD-4X100G-FR-4Si QSFP-DD 4 x 100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS4.0 실리콘 포토닉스 광 트랜시버 모듈

$750.00

QDD-4X100G-FR-4Si QSFP-DD 4 x 100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS4.0 실리콘 포토닉스 광 트랜시버 모듈

$750.00

-

QSFP-DD-400G-SR4.2 400Gb/s QSFP-DD SR4 BiDi PAM4 850nm/910nm 100m/150m OM4/OM5 MMF MPO-12 FEC 광 트랜시버 모듈

$900.00

QSFP-DD-400G-SR4.2 400Gb/s QSFP-DD SR4 BiDi PAM4 850nm/910nm 100m/150m OM4/OM5 MMF MPO-12 FEC 광 트랜시버 모듈

$900.00

-

Arista Q112-400G-SR4 호환 400G QSFP112 SR4 PAM4 850nm 100m MTP/MPO-12 OM3 FEC 광 트랜시버 모듈

$450.00

Arista Q112-400G-SR4 호환 400G QSFP112 SR4 PAM4 850nm 100m MTP/MPO-12 OM3 FEC 광 트랜시버 모듈

$450.00

-

FEC 광학적인 송수신기 모듈을 갖춘 Cisco Q112-400G-DR4 호환 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12

$650.00

FEC 광학적인 송수신기 모듈을 갖춘 Cisco Q112-400G-DR4 호환 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12

$650.00

-

OSFP-800G-DR8D-FLT 800G-DR8 OSFP 플랫 탑 PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$1199.00

OSFP-800G-DR8D-FLT 800G-DR8 OSFP 플랫 탑 PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$1199.00

-

OSFP-800G-SR8D-FLT OSFP 8x100G SR8 플랫 탑 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

OSFP-800G-SR8D-FLT OSFP 8x100G SR8 플랫 탑 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

-

OSFP-800G-SR8D OSFP 8x100G SR8 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

OSFP-800G-SR8D OSFP 8x100G SR8 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

-

OSFP-800G-DR8D 800G-DR8 OSFP PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$850.00

OSFP-800G-DR8D 800G-DR8 OSFP PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$850.00

-

OSFP-800G-2FR4L OSFP 2x400G FR4 PAM4 1310nm 2km DOM 이중 이중 LC SMF 광 트랜시버 모듈

$1200.00

OSFP-800G-2FR4L OSFP 2x400G FR4 PAM4 1310nm 2km DOM 이중 이중 LC SMF 광 트랜시버 모듈

$1200.00