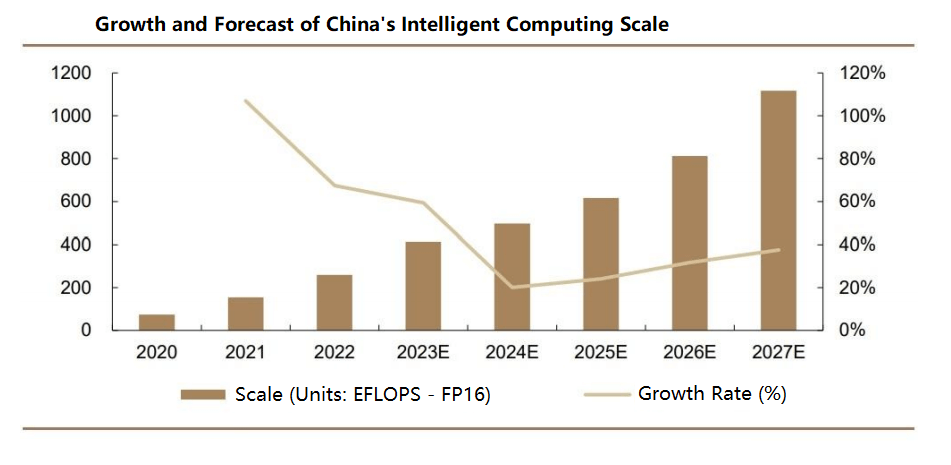

인공지능(AI)이 데이터 양과 모델 복잡성을 기하급수적으로 증가시키는 가운데, 분산 컴퓨팅은 상호 연결된 노드를 활용하여 학습 프로세스를 가속화합니다. 데이터센터 스위치는 노드 간 적시 메시지 전달을 보장하는 데 중추적인 역할을 하며, 특히 경쟁적인 워크로드를 처리하는 데 있어 테일 레이턴시(tail latency)가 중요한 대규모 데이터센터에서 더욱 중요합니다. 또한, 대규모 AI 모델을 학습하고 방대한 데이터 세트를 처리하는 데는 확장성과 여러 노드를 관리할 수 있는 능력이 필수적이므로 효율적인 네트워크 연결 및 데이터 전송을 위해 데이터센터 스위치는 필수적입니다. IDC에 따르면, 글로벌 스위치 시장은 308년에 2022억 달러에 도달하여 전년 대비 17%의 성장률을 기록했으며, 4.6년부터 2022년까지 연평균 성장률(CAGR)은 2027%에 이를 것으로 예상됩니다. 중국의 스위치 시장 규모는 59.1억 달러로, 9.5% 성장했으며, 향후 7년간 연평균 성장률은 9~XNUMX%로 전 세계 성장률을 앞지르고 있습니다.

데이터 센터 스위치의 주요 분류

데이터 센터 스위치는 애플리케이션 시나리오, 네트워크 계층, 관리 유형, OSI 네트워크 모델, 포트 속도, 물리적 구조 등 다양한 기준에 따라 분류할 수 있습니다. 분류 기준은 다음과 같습니다.

- 애플리케이션 시나리오별: 캠퍼스 스위치, 데이터 센터 스위치

- 네트워크 계층별: 액세스 스위치, 집계 스위치, 코어 스위치

- 관리 유형별: 비관리형 스위치, 웹 관리형 스위치, 완전 관리형 스위치

- OSI 네트워크 모델에 따라: 계층 2 스위치, 계층 3 스위치

- 포트 속도별: 고속 이더넷 스위치, 기가비트 이더넷 스위치, 10기가비트 스위치, 다중 속도 스위치

- 물리적 구조별: 고정형(박스형) 스위치, 모듈형(섀시형) 스위치

스위치 칩 및 주요 성능 지표

이더넷 데이터 센터 스위치는 칩, PCB, 광 모듈, 커넥터, 수동 부품, 인클로저, 전원 공급 장치, 팬과 같은 핵심 구성 요소로 구성됩니다. 핵심 구성 요소에는 이더넷 스위치 칩과 CPU가 포함되며, PHY 및 CPLD/FPGA와 같은 추가 구성 요소도 포함됩니다. 네트워크 최적화를 위해 특별히 설계된 이더넷 스위치 칩은 데이터 처리 및 패킷 전달을 담당하며, 견고한 데이터 처리를 위해 복잡한 논리 경로를 갖추고 있습니다. CPU는 로그인 및 프로토콜 상호 작용을 관리하고, PHY는 물리 계층 데이터를 처리합니다.

데이터 센터 스위치의 성능은 백플레인 대역폭, 패킷 전달 속도, 스위칭 용량, 포트 속도, 포트 밀도와 같은 주요 지표에 따라 달라집니다. 백플레인 대역폭은 스위치의 데이터 처리량을 나타내며, 값이 높을수록 부하가 높은 환경에서 더 나은 성능을 나타냅니다. 논블로킹 전달의 경우, 백플레인 대역폭은 최소한 스위칭 용량(전이중 모드에서 포트 수 × 포트 속도 × 2로 계산)과 같아야 합니다. 백플레인 없는 설계의 고급 스위치는 패킷 전달 속도에 의존합니다. 포트 속도가 높을수록 트래픽이 많은 환경에서 뛰어난 처리 능력을 나타내며, 포트 밀도가 높을수록 더 많은 장치를 연결하여 더 큰 네트워크 규모를 지원합니다.

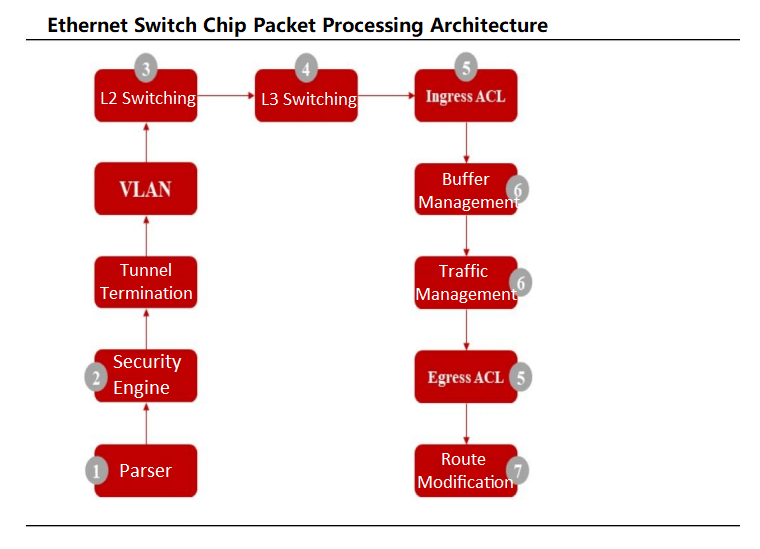

이더넷 스위치 칩은 데이터 센터 스위치용 특수 ASIC으로 작동하며, MAC 컨트롤러와 PHY 칩을 통합하는 경우가 많습니다. 데이터 패킷은 물리적 포트를 통해 입력되며, 칩의 파서는 필드를 분석하여 흐름 분류를 수행합니다. 보안 검사 후 패킷은 레이어 2 스위칭 또는 레이어 3 라우팅을 거치며, 흐름 분류기는 802.1P 또는 DSCP 표준에 따라 우선순위가 지정된 큐로 패킷을 전송합니다. 스케줄러는 패킷을 전송하기 전에 가중 라운드 로빈(WRR)과 같은 알고리즘을 사용하여 큐의 우선순위를 관리합니다.

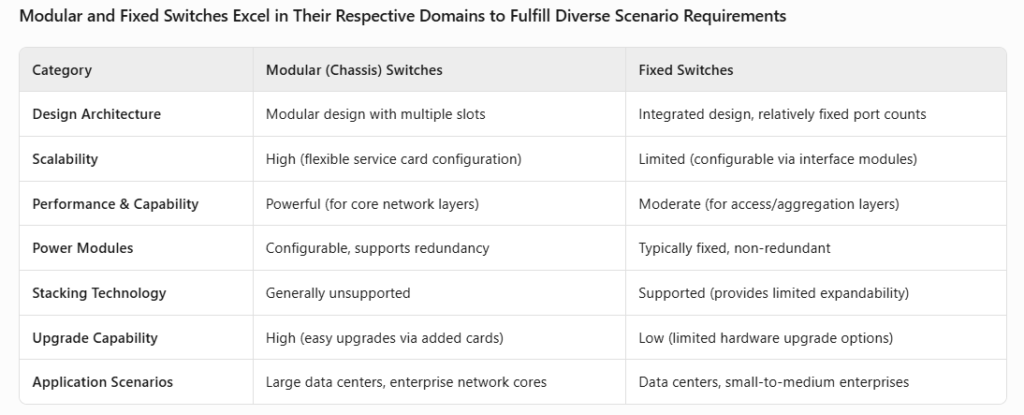

데이터 센터 스위치는 물리적으로 섀시 기반이거나 고정형입니다. 섀시 스위치는 인터페이스, 제어 및 스위칭 모듈용 슬롯을 갖춘 모듈형 설계로 높은 유연성과 확장성을 제공합니다. 고정형 스위치는 고정 포트 구성을 갖춘 통합 설계를 사용하지만, 일부는 모듈형 인터페이스를 지원합니다. 주요 차이점은 내부 아키텍처와 애플리케이션 시나리오(OSI 계층 사용)에 있습니다.

데이터 센터 스위치의 진화와 기술 발전

OEO에서 OOO로: AI 워크로드를 위한 모든 광 스위치

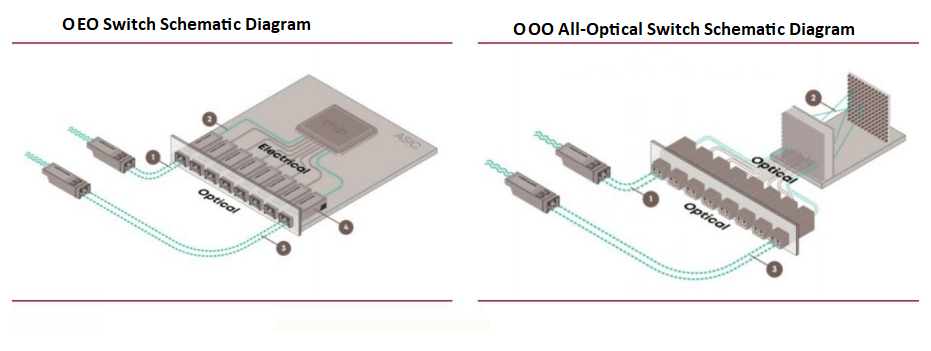

ASIC 칩 기반의 현재 데이터센터 스위치는 광-전기-광(OEO) 패킷 회선 스위치로 작동하며, 코어 패킷 전달을 위해 ASIC 칩에 의존합니다. 이러한 스위치는 신호 전송을 위해 광-전기 변환을 필요로 합니다. 그러나 AI 기반 컴퓨팅 요구를 충족하고 변환 오버헤드를 줄이며 효율성을 향상시키기 위해 전광(OOO) 스위치가 등장하고 있습니다.

NVIDIA 임원, Lightmatter에 합류해 모든 광 스위칭 기술 발전 도모

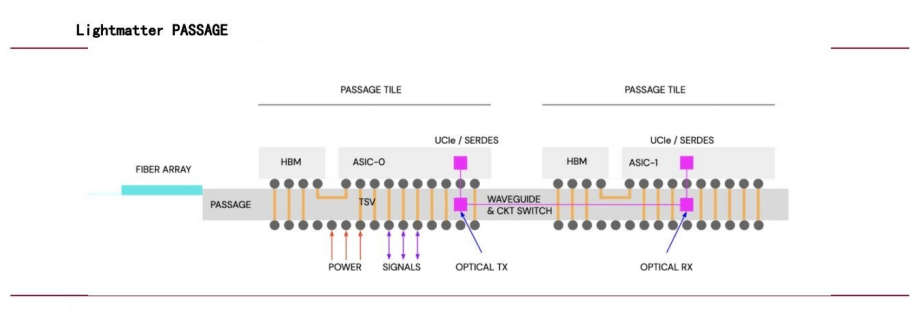

2024년 4.4월, NVIDIA 부사장 시모나 얀코프스키가 Lightmatter의 CFO로 합류하면서 회사의 광 상호 연결에 대한 집중을 시사했습니다. XNUMX억 달러의 가치를 지닌 Lightmatter의 Passage 기술은 광섬유 대신 도파관을 사용하여 칩 상호 연결에 광자학을 활용하고, 다양한 컴퓨팅 코어에 고대역폭 병렬 데이터 전송을 제공하여 AI 네트워크 성능을 크게 향상시킵니다.

Google의 OCS 스위치 대규모 배포

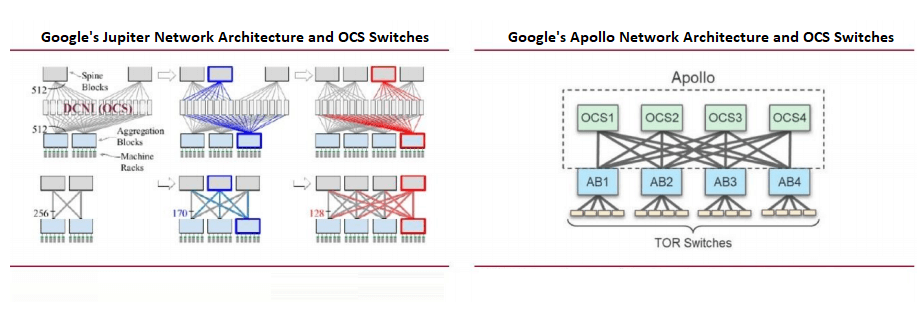

Google의 데이터 센터 네트워크는 소프트웨어 정의 네트워킹(SDN), Clos 토폴로지, 그리고 범용 스위치 칩을 강조합니다. 더 작은 라딕스 칩으로 구축된 논블로킹 다단계 아키텍처인 Clos 토폴로지는 AI 워크로드에 필수적인 확장 가능한 네트워크를 지원합니다.

구글은 주피터 아키텍처에 광 회로 스위치(OCS)를 대규모로 적용하여 MEMS 기반 OCS를 통합하여 광-전기 변환을 줄였습니다. 2023년 OFC에서 구글은 아폴로 프로젝트를 발표하며 스파인 계층의 이더넷 패킷 스위치(EPS)를 OCS로 대체하여 효율성을 향상시켰습니다.

데이터 센터 스위치를 위한 핵심 기술 및 표준

- RDMA: 저지연, 고처리량 통신 지원

원격 직접 메모리 액세스(RDMA)는 운영 체제 개입을 우회하여 높은 처리량과 낮은 지연 시간의 네트워크 통신을 가능하게 합니다. CPU 사용량이 많은 여러 데이터 복사본을 필요로 하는 기존 TCP/IP와 달리, RDMA는 컴퓨터 메모리 간에 데이터를 직접 전송합니다. 데이터 센터 스위치에서 RDMA는 InfiniBand와 RoCE(RDMA over Converged Ethernet)를 통해 구현됩니다. 인피니밴드 RoCEv2는 AI 데이터 센터(AIDC)를 위한 주요 솔루션입니다.

- InfiniBand: 고성능 컴퓨팅(HPC) 및 데이터 센터용으로 설계된 InfiniBand는 높은 대역폭, 낮은 지연 시간, 서비스 품질(QoS) 및 확장성을 제공합니다. 채널화 아키텍처, RDMA 지원, 그리고 스위치드 네트워크 설계는 데이터 집약적인 애플리케이션에 이상적입니다. 하지만 높은 비용으로 인해 특수 HPC 환경에서만 적용이 가능합니다.

InfiniBand와 RoCE 비교

| 범주â € < | â € <인피니밴드â € < | â € <RoCEâ € < |

| 디자인 철학â € < | RDMA를 염두에 두고 설계되어 물리적 링크 및 네트워크 계층을 재정의합니다. | 이더넷을 통한 RDMA 구현(RoCEv1: 링크 계층, RoCEv2: 전송 계층) |

| 핵심 기술â € < | – InfiniBand 네트워크 프로토콜 및 아키텍처 – 동사 프로그래밍 인터페이스 | – UDP/IP 기반 구현 – CPU 사용률을 줄이기 위한 하드웨어 오프로드(RoCEv2) – 확장성을 위한 IP 라우팅 |

| 장점â € < | – 더 높은 대역폭과 더 낮은 지연 시간 – 데이터 안정성을 보장하는 신용 기반 흐름 제어 | – 비용 효율적 – 표준 이더넷과 호환 – 대규모 배포 지원 |

| 단점â € < | – 제한된 확장성 – 특수 NIC 및 스위치가 필요합니다. | – 구현 과제는 여전히 남아 있습니다. – RoCE 지원 NIC가 필요합니다. |

| 비용â € < | 더 높음(전용 IB NIC/스위치, 케이블 비용이 이더넷을 초과함) | 낮음(표준 이더넷 스위치 활용, 예산에 맞춰 제공) |

| 사용 사례â € < | HPC, 대규모 병렬 처리, AI 학습 | 데이터 센터 내부 커뮤니케이션, 클라우드 서비스 제공업체 |

| 주요 공급업체â € < | NVIDIA(주요 공급업체) | 다중 공급업체 지원(예: 중국의 Huawei, H3C, Inspur, Ruijie) |

- RoCE: 이더넷의 UDP 계층을 기반으로 구축된 RoCEv2는 확장성을 위해 IP 프로토콜을 도입하고 하드웨어 오프로드를 통해 CPU 사용량을 줄입니다. InfiniBand보다 성능은 다소 떨어지지만, RoCEv2는 비용 효율적이어서 데이터 센터 통신 및 클라우드 서비스에 적합합니다.

RDMA는 카드 간 통신 지연 시간을 줄입니다.

분산 AI 학습에서 가속률 향상을 위해서는 카드 간 통신 지연 시간을 줄이는 것이 매우 중요합니다. 총 계산 시간에는 단일 카드 계산과 카드 간 통신이 포함되며, RDMA(InfiniBand 또는 RoCEv2 기반)는 커널 프로토콜 스택을 우회하여 지연 시간을 최소화합니다. 랩 테스트 결과, RDMA는 단일 홉 시나리오에서 종단 간 지연 시간을 50µs(TCP/IP)에서 5µs(RoCEv2) 또는 2µs(InfiniBand)로 단축하는 것으로 나타났습니다.

이더넷 대 InfiniBand: 강점과 추세

- InfiniBand 대 RoCEv2: InfiniBand는 RoCEv10,000보다 성능 저하를 최소화하고 지연 시간을 단축하면서 대규모 GPU 클러스터(최대 2개 카드)를 지원하지만, NVIDIA가 시장의 70% 이상을 점유하고 있어 비용이 더 많이 듭니다. RoCEv2는 더 광범위한 호환성과 더 낮은 비용을 제공하며, RDMA와 기존 이더넷 네트워크를 모두 지원하며, H3C와 Huawei와 같은 공급업체가 시장을 선도하고 있습니다.

- 이더넷의 성장 모멘텀: Dell'Oro Group에 따르면, AI 백엔드 네트워크 스위치 지출은 100년부터 2025년까지 2029억 달러를 초과할 것으로 예상됩니다. 이더넷은 xAI의 콜로서스(Colossus)와 같은 대규모 AI 클러스터에서 이더넷을 도입하면서 주목을 받고 있습니다. 2027년까지 이더넷은 시장 점유율에서 InfiniBand를 앞지를 것으로 예상됩니다.

- 엔비디아의 이더넷 추진: 2023년 2024월, AMD, Arista, Broadcom, Cisco, Meta, Microsoft 등이 참여하는 울트라 이더넷 컨소시엄(UEC)이 이더넷 기반 AI 네트워킹 솔루션을 개발하기 위해 결성되었습니다. 엔비디아는 1.6년 XNUMX월 Spectrum-X 플랫폼을 통해 AI 네트워크 성능을 기존 이더넷 대비 XNUMX배 향상시키며 참여했습니다. 엔비디아는 AI 이더넷 성능을 더욱 향상시키기 위해 매년 Spectrum-X 업데이트를 계획하고 있습니다.

관련 상품:

-

QSFP-DD-400G-SR8 400G QSFP-DD SR8 PAM4 850nm 100m MTP / MPO OM3 FEC 광 트랜시버 모듈

$149.00

QSFP-DD-400G-SR8 400G QSFP-DD SR8 PAM4 850nm 100m MTP / MPO OM3 FEC 광 트랜시버 모듈

$149.00

-

QSFP-DD-400G-DR4 400G QSFP-DD DR4 PAM4 1310nm 500m MTP / MPO SMF FEC 광 트랜시버 모듈

$400.00

QSFP-DD-400G-DR4 400G QSFP-DD DR4 PAM4 1310nm 500m MTP / MPO SMF FEC 광 트랜시버 모듈

$400.00

-

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC 광 트랜시버 모듈

$450.00

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC 광 트랜시버 모듈

$450.00

-

QSFP-DD-400G-FR4 400G QSFP-DD FR4 PAM4 CWDM4 2km LC SMF FEC 광 트랜시버 모듈

$500.00

QSFP-DD-400G-FR4 400G QSFP-DD FR4 PAM4 CWDM4 2km LC SMF FEC 광 트랜시버 모듈

$500.00

-

QSFP-DD-400G-XDR4 400G QSFP-DD XDR4 PAM4 1310nm 2km MTP/MPO-12 SMF FEC 광 트랜시버 모듈

$580.00

QSFP-DD-400G-XDR4 400G QSFP-DD XDR4 PAM4 1310nm 2km MTP/MPO-12 SMF FEC 광 트랜시버 모듈

$580.00

-

QSFP-DD-400G-LR4 400G QSFP-DD LR4 PAM4 CWDM4 10km LC SMF FEC 광 트랜시버 모듈

$600.00

QSFP-DD-400G-LR4 400G QSFP-DD LR4 PAM4 CWDM4 10km LC SMF FEC 광 트랜시버 모듈

$600.00

-

QDD-4X100G-FR-Si QSFP-DD 4 x100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS3.0 실리콘 포토닉스 광 트랜시버 모듈

$650.00

QDD-4X100G-FR-Si QSFP-DD 4 x100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS3.0 실리콘 포토닉스 광 트랜시버 모듈

$650.00

-

QDD-4X100G-FR-4Si QSFP-DD 4 x 100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS4.0 실리콘 포토닉스 광 트랜시버 모듈

$750.00

QDD-4X100G-FR-4Si QSFP-DD 4 x 100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS4.0 실리콘 포토닉스 광 트랜시버 모듈

$750.00

-

QSFP-DD-400G-SR4.2 400Gb/s QSFP-DD SR4 BiDi PAM4 850nm/910nm 100m/150m OM4/OM5 MMF MPO-12 FEC 광 트랜시버 모듈

$900.00

QSFP-DD-400G-SR4.2 400Gb/s QSFP-DD SR4 BiDi PAM4 850nm/910nm 100m/150m OM4/OM5 MMF MPO-12 FEC 광 트랜시버 모듈

$900.00

-

Arista Q112-400G-SR4 호환 400G QSFP112 SR4 PAM4 850nm 100m MTP/MPO-12 OM3 FEC 광 트랜시버 모듈

$450.00

Arista Q112-400G-SR4 호환 400G QSFP112 SR4 PAM4 850nm 100m MTP/MPO-12 OM3 FEC 광 트랜시버 모듈

$450.00

-

FEC 광학적인 송수신기 모듈을 갖춘 Cisco Q112-400G-DR4 호환 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12

$650.00

FEC 광학적인 송수신기 모듈을 갖춘 Cisco Q112-400G-DR4 호환 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12

$650.00

-

OSFP-800G-DR8D-FLT 800G-DR8 OSFP 플랫 탑 PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$1199.00

OSFP-800G-DR8D-FLT 800G-DR8 OSFP 플랫 탑 PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$1199.00

-

OSFP-800G-SR8D-FLT OSFP 8x100G SR8 플랫 탑 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

OSFP-800G-SR8D-FLT OSFP 8x100G SR8 플랫 탑 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

-

OSFP-800G-SR8D OSFP 8x100G SR8 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

OSFP-800G-SR8D OSFP 8x100G SR8 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

-

OSFP-800G-DR8D 800G-DR8 OSFP PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$850.00

OSFP-800G-DR8D 800G-DR8 OSFP PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$850.00

-

OSFP-800G-2FR4L OSFP 2x400G FR4 PAM4 1310nm 2km DOM 이중 이중 LC SMF 광 트랜시버 모듈

$1200.00

OSFP-800G-2FR4L OSFP 2x400G FR4 PAM4 1310nm 2km DOM 이중 이중 LC SMF 광 트랜시버 모듈

$1200.00