최근 몇 년 동안 인공지능(AI)의 세계적인 부상은 사회 전반에 걸쳐 폭넓은 관심을 불러일으켰습니다. AI를 둘러싼 공통적인 논의 주제 중 하나는 알고리즘과 데이터와 함께 AI의 세 가지 기본 축 중 하나인 컴퓨팅 클러스터 개념입니다. 이러한 컴퓨팅 클러스터는 AI 혁명에 지속적으로 동력을 공급하는 거대한 발전소와 마찬가지로 컴퓨팅 파워의 주요 원천 역할을 합니다.

하지만 AI 컴퓨팅 클러스터는 정확히 무엇을 의미할까요? 이러한 클러스터가 어떻게 이처럼 엄청난 연산 성능을 제공할 수 있을까요? 내부 아키텍처는 어떻게 구성되며, 핵심 기술은 무엇일까요?

AI 컴퓨팅 클러스터란 무엇인가요?

이름에서 알 수 있듯이 AI 컴퓨팅 클러스터는 AI 작업 수행에 필요한 컴퓨팅 리소스를 제공하는 시스템입니다. "클러스터"는 고속 네트워크를 통해 연결되어 통합된 시스템으로 작동하는 독립 장치 그룹을 의미합니다.

정의에 따르면, AI 컴퓨팅 클러스터는 고속 네트워크를 통해 수많은 고성능 컴퓨팅 노드(예: GPU 또는 TPU 서버)를 상호 연결하여 형성된 분산 컴퓨팅 시스템입니다.

AI 워크로드는 일반적으로 학습과 추론이라는 두 가지 주요 범주로 나눌 수 있습니다. 학습 작업은 일반적으로 연산 집약적이고 복잡하여 상당한 연산 리소스를 필요로 합니다. 반면, 추론 작업은 상대적으로 가볍고 덜 까다롭습니다.

두 프로세스 모두 합성곱과 텐서 곱셈을 포함한 행렬 연산에 크게 의존하며, 이는 자연스럽게 병렬화에 적합합니다. 따라서 GPU, NPU, TPU와 같은 병렬 컴퓨팅 칩은 AI 처리에 필수적이 되었습니다. 이러한 칩들을 통칭하여 AI 칩이라고 합니다.

AI 칩은 AI 연산의 기본 단위이지만, 단일 칩은 독립적으로 작동할 수 없으며 회로 기판에 통합되어야 합니다. 적용 분야에 따라 다음과 같습니다.

모바일 폰 마더보드에 내장되거나 SoC에 통합되어 모바일 AI 기능을 구현합니다.

IoT 기기용 모듈로 설치하면 자율주행차, 로봇팔, 감시 카메라 등의 장비에 대한 엣지 인텔리전스를 구현할 수 있습니다.

기지국, 라우터, 게이트웨이에 통합되어 에지 측 AI 컴퓨팅을 제공합니다. 일반적으로 크기와 전력 제약으로 인해 추론에만 국한됩니다.

더욱 까다로운 훈련 작업을 위해서는 시스템이 여러 개의 AI 칩을 지원해야 합니다. 이는 AI 컴퓨팅 보드를 제작하고 여러 개를 단일 서버에 설치하여 일반 서버를 AI 서버로 효과적으로 변환하는 방식으로 구현됩니다.

일반적으로 AI 서버는 8개의 컴퓨팅 카드를 장착하지만, 일부 모델은 최대 20개의 카드를 지원합니다. 그러나 발열과 전력 제한으로 인해 추가 확장은 불가능합니다.

이 구성을 사용하면 연산 능력이 크게 향상되어 서버가 추론을 쉽게 처리하고 소규모 학습 작업도 수행할 수 있습니다. DeepSeek 모델이 그 예인데, 이 모델은 아키텍처와 알고리즘을 최적화하여 연산 부담을 크게 줄였습니다. 결과적으로 많은 공급업체가 이제 AI 서버, 스토리지, 전원 공급 장치로 구성된 통합 "올인원" 랙을 제공하여 기업 고객을 위한 DeepSeek 모델의 프라이빗 배포를 지원합니다.

그럼에도 불구하고 이러한 설정의 연산 능력은 여전히 제한적입니다. 수십억 또는 수천억 개의 매개변수를 갖는 매우 대규모 모델을 학습하려면 훨씬 더 많은 리소스가 필요합니다. 이는 훨씬 더 많은 수의 AI 칩을 통합하는 대규모 AI 컴퓨팅 클러스터의 개발로 이어집니다.

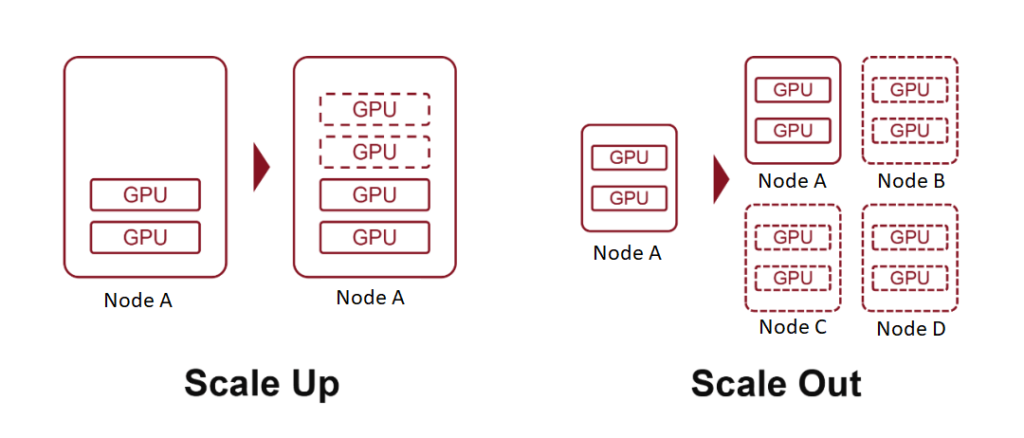

"10K 스케일" 또는 "100K 스케일"과 같은 용어는 10,000개 또는 100,000개의 AI 컴퓨팅 보드로 구성된 클러스터를 의미합니다. 이를 위해 두 가지 기본 전략이 사용됩니다. 스케일 업(더 강력한 하드웨어 추가)과 스케일 아웃(상호 연결된 시스템 수 확장)입니다.

스케일업이란 무엇인가?

컴퓨팅 용어에서 "규모"는 시스템 리소스의 확장을 의미합니다. 이 개념은 특히 클라우드 컴퓨팅 경험이 있는 사람들에게 친숙합니다.

스케일 업(Scale Up)은 수직적 확장이라고도 하며, 단일 노드의 리소스를 늘리는 것을 말합니다. 예를 들어 서버에 컴퓨팅 파워, 메모리 또는 AI 가속 카드를 추가하는 것입니다.

스케일 아웃 또는 수평적 확장은 더 많은 노드를 추가하여 시스템을 확장하는 것을 의미합니다. 즉, 네트워크를 통해 여러 서버나 장치를 연결하는 것입니다.

클라우드 컴퓨팅에서 이 개념은 스케일 다운(노드의 리소스 감소)과 스케일 인(노드 수 감소)으로 확장됩니다.

앞서 서버에 AI 가속 카드를 더 많이 삽입하는 것이 스케일 업(Scale Up)의 한 형태이며, 각 서버가 단일 노드처럼 동작하는 방식에 대해 설명했습니다. 고속 네트워크를 통해 여러 서버를 상호 연결함으로써 스케일 아웃(Scale Out)을 실현합니다.

이 두 가지의 주요 차이점은 AI 칩 간의 통신 대역폭에 있습니다.

스케일 업은 내부 노드 연결을 포함하며, 더 빠른 속도, 더 낮은 지연 시간, 더 강력한 성능을 제공합니다.

역사적으로 컴퓨터 내부 통신은 20세기 후반 개인용 컴퓨팅이 부상하면서 개발된 프로토콜인 PCIe에 의존했습니다. PCIe는 여러 차례 업그레이드되었지만, 그 발전 속도는 느리고 현대 AI 워크로드에는 충분하지 않았습니다.

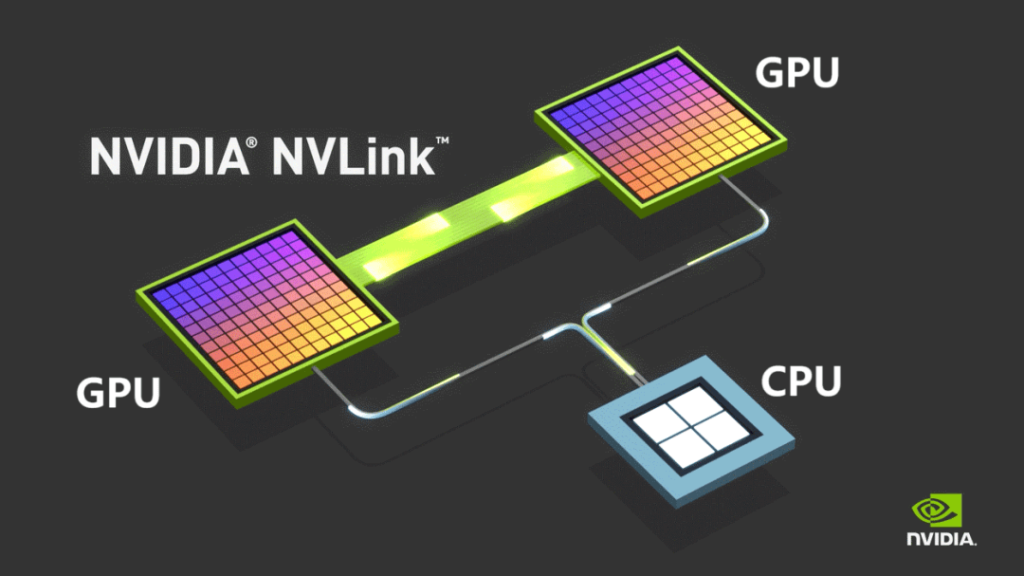

이러한 한계를 극복하기 위해 NVIDIA는 2014년 자사만의 NVLINK 버스 프로토콜을 도입하여 GPU 간 지점 간 통신을 가능하게 했습니다. NVLINK는 PCIe보다 훨씬 빠른 속도와 훨씬 낮은 지연 시간을 제공합니다.

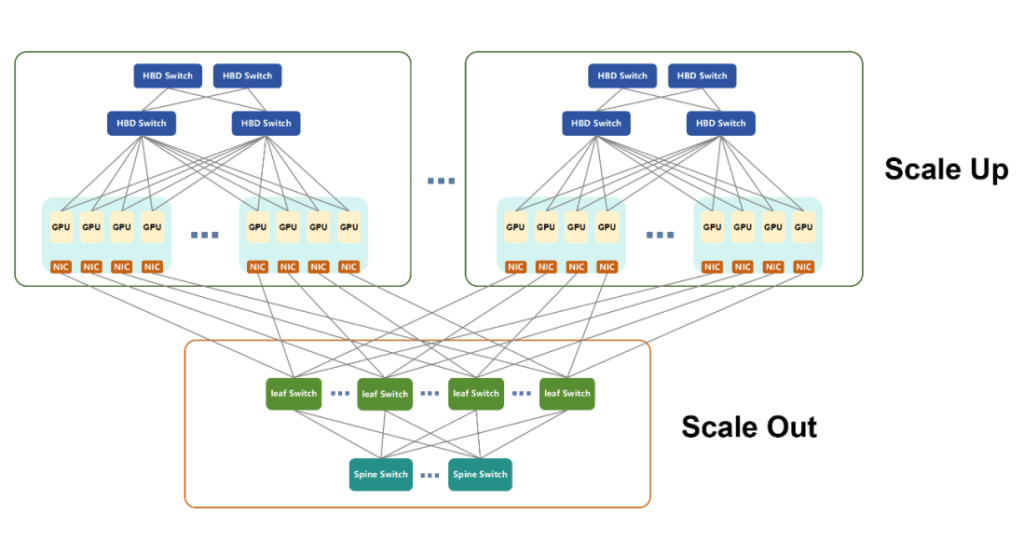

처음에는 머신 간 통신에만 사용되던 NVIDIA는 2022년에 서버 간 고속 GPU 연결을 지원하도록 설계된 독립형 스위칭 칩인 NVSwitch를 출시했습니다. 이 혁신은 노드의 개념을 재정의하여 여러 서버와 네트워킹 장치가 고대역폭 도메인(HBD) 내에서 함께 작동할 수 있도록 했습니다.

엔비디아는 16개 이상의 GPU가 초고대역폭으로 상호 연결된 이러한 시스템을 슈퍼노드라고 부릅니다.

시간이 지남에 따라 NVLINK는 18세대로 발전했습니다. 각 GPU는 이제 최대 1800개의 NVLINK 연결을 지원하며, Blackwell GPU의 총 대역폭은 6GB/s에 도달하여 PCIe GenXNUMX를 크게 능가했습니다.

2024년 72월, 엔비디아는 그레이스(Grace) CPU 36개와 블랙웰(Blackwell) GPU 72개를 통합한 수냉식 캐비닛인 NVL720를 공개했습니다. 최대 1440 PFLOPS의 학습 성능 또는 XNUMX PFLOPS의 추론 성능을 제공하며, 널리 사용되는 GPU 하드웨어와 CUDA 소프트웨어 스택을 기반으로 AI 컴퓨팅 생태계에서 엔비디아의 리더십을 더욱 공고히 합니다.

AI 도입이 확대됨에 따라 수많은 기업들이 자체 AI 칩을 개발했습니다. NVLINK의 독점적인 특성으로 인해 이러한 기업들은 대체 컴퓨팅 클러스터 아키텍처를 고안해야 했습니다.

주요 경쟁사인 AMD는 UA LINK를 출시했습니다.

텐센트, 알리바바, 차이나 모바일 등 중국 국내 기업은 ETH-X, ALS, OISA와 같은 개방형 이니셔티브를 주도했습니다.

또 다른 주목할 만한 발전은 화웨이의 UB(Unified Bus) 프로토콜입니다. 이는 Ascend AI 칩 생태계를 지원하기 위해 개발된 독점 기술입니다. Ascend 910C와 같은 화웨이 칩은 최근 몇 년 동안 상당한 발전을 이루었습니다.

2025년 384월, Huawei는 384개의 Ascend 910C AI 가속 카드를 통합하고 최대 300 PFLOPS의 고밀도 BF16 컴퓨팅 성능을 달성한 CloudMatrix200 슈퍼노드를 출시했습니다. 이는 NVIDIA의 GB72 NVLXNUMX 시스템의 거의 두 배에 달하는 수치입니다.

CloudMatrix384는 UB 기술을 활용하며 세 가지 고유한 네트워킹 플레인으로 구성됩니다.

- UB 비행기

- RDMA(원격 직접 메모리 액세스) 플레인

- VPC(가상 사설 클라우드) 플레인

이러한 보완적 평면은 뛰어난 카드 간 통신을 가능하게 하고 슈퍼노드 내의 전반적인 컴퓨팅 능력을 크게 향상시킵니다.

공간 제약으로 인해, 이 비행기의 기술적 세부 사항은 향후 논의에서 별도로 살펴보겠습니다.

마지막으로 한 가지 더 말씀드리겠습니다. 개방형 표준에 대한 압력이 커지면서 엔비디아는 최근 NVLink Fusion 이니셔티브를 발표하여 8개 글로벌 파트너사에 NVLink 기술에 대한 접근 권한을 제공했습니다. 이는 멀티칩 상호연결을 통해 파트너사들이 맞춤형 AI 시스템을 구축할 수 있도록 지원하는 것을 목표로 합니다. 그러나 일부 언론 보도에 따르면 NVLink의 핵심 구성 요소는 여전히 독점적인 것으로 남아 있어 엔비디아가 여전히 개방성에 대해 다소 소극적인 태도를 보이고 있음을 시사합니다.

스케일 아웃이란?

스케일 아웃(Scale Out)은 컴퓨팅 시스템의 수평적 확장을 의미하며, 기존 데이터 통신 네트워크와 매우 유사합니다. 팻 트리 아키텍처, 스파인-리프 네트워크 토폴로지, TCP/IP 프로토콜, 이더넷 등 기존 서버를 연결하는 데 일반적으로 사용되는 기술은 스케일 아웃 인프라의 기반을 형성합니다.

AI 수요에 맞춰 진화하다

AI 워크로드에 대한 요구가 증가함에 따라 기존 네트워킹 기술은 성능 기준을 충족하기 위해 상당한 개선이 필요했습니다. 현재 스케일 아웃(Scale Out)에 사용되는 두 가지 주요 네트워크 기술은 다음과 같습니다.

- 인피니밴드(IB)

- RoCEv2(RDMA over Converged Ethernet 버전 2)

두 기술 모두 RDMA(Remote Direct Memory Access) 프로토콜을 기반으로 하여 기존 이더넷에 비해 더 빠른 데이터 전송 속도, 더 낮은 지연 시간, 뛰어난 부하 분산 기능을 제공합니다.

InfiniBand 대 RoCEv2

- InfiniBand는 원래 상호 연결 목적으로 PCIe를 대체하기 위해 설계되었습니다. 시간이 지남에 따라 채택률이 변동되었지만, 결국 NVIDIA가 Mellanox를 인수하면서 InfiniBand를 인수했습니다. 현재 InfiniBand는 NVIDIA의 독점 기술로 NVIDIA의 컴퓨팅 인프라에서 핵심적인 역할을 수행하고 있습니다. 뛰어난 성능을 제공하지만 가격이 높습니다.

- 반면 RoCEv2는 IB의 시장 지배력을 상쇄하기 위해 개발된 개방형 표준입니다. RDMA와 기존 이더넷을 통합하여 비용 효율성을 제공하고 InfiniBand와의 성능 격차를 꾸준히 줄여나가고 있습니다.

Scale Up 구현에서 볼 수 있는 단편화된 표준과 달리 Scale Out은 칩 수준 제품과의 긴밀한 결합보다는 노드 간 호환성에 중점을 두기 때문에 RoCEv2에서 대체로 통합되었습니다.

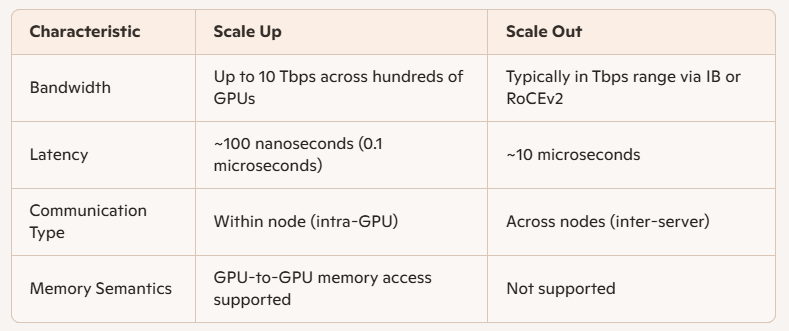

성능 차이: 확장 대 확장

Scale Up과 Scale Out의 주요 기술적 차이점은 대역폭과 대기 시간에 있습니다.

AI 교육에 적용

AI 훈련에는 여러 형태의 병렬 계산이 포함됩니다.

- TP(텐서 병렬 처리)

- EP(전문가 병렬 처리)

- PP(파이프라인 병렬 처리)

- DP(데이터 병렬 처리)

일반적으로:

- PP와 DP는 통신 부하가 적고 Scale Out을 통해 처리됩니다.

- 더 많은 데이터 교환이 필요한 TP와 EP는 슈퍼노드 내에서 Scale Up을 통해 가장 잘 지원됩니다.

네트워크 설계에서 스케일업의 장점

스케일업 아키텍처 기반의 슈퍼노드는 고속 내부 버스를 통해 연결되며, 병렬 컴퓨팅, GPU 매개변수 교환 및 데이터 동기화를 효율적으로 지원합니다. 또한, 스케일아웃 아키텍처에는 없는 GPU 간 직접 메모리 액세스를 지원합니다.

배포 및 유지 관리 관점에서:

- 더 큰 고대역폭 도메인(HBD)은 스케일 아웃 네트워크를 단순화합니다.

- 사전 통합된 Scale Up 시스템은 복잡성을 줄이고, 배포 시간을 단축하며, 장기 운영을 용이하게 해줍니다.

하지만 Scale Up은 비용 제약으로 인해 무한대로 확장할 수 없습니다. 최적의 확장 규모는 특정 사용 시나리오에 따라 달라집니다.

통일된 미래?

궁극적으로 스케일 업(Scale Up)과 스케일 아웃(Scale Out)은 성능과 비용 간의 상충 관계를 나타냅니다. 기술이 발전함에 따라 둘 사이의 경계는 모호해질 것으로 예상됩니다. 이더넷 기반 ETH-X와 같은 새로운 개방형 스케일 업 표준은 유망한 성능 지표를 제공합니다.

- 스위치 칩 용량: 최대 51.2Tbps

- SerDes 속도: 최대 112Gbps

- 지연 시간: 최소 200나노초

Scale Out도 이더넷을 활용하므로 이러한 융합은 단일 표준이 미래 컴퓨팅 생태계에서 두 가지 확장 모델을 모두 뒷받침할 수 있는 통합 아키텍처를 암시합니다.

AI 컴퓨팅 클러스터 개발 동향

인공 지능(AI) 분야가 계속 확장됨에 따라 AI 컴퓨팅 클러스터는 몇 가지 주요 궤적을 따라 발전하고 있습니다.

물리적 인프라의 지리적 분포

AI 클러스터는 수만 개 또는 수십만 개의 AI 카드를 포함하는 구성으로 확장되고 있습니다. 예를 들면 다음과 같습니다.

- NVIDIA의 NVL72 랙은 72개의 칩을 통합합니다.

- Huawei의 CM384는 384개 랙에 16개의 칩을 배치합니다.

Huawei의 CM100,000 아키텍처를 사용하여 384만 카드 클러스터를 구축하려면 432개의 CM384 유닛이 필요합니다. 이는 165,888개의 칩과 6,912개의 랙에 해당합니다. 이러한 규모는 단일 데이터 센터의 물리적 및 전기적 용량을 훨씬 초과합니다.

결과적으로 업계는 통합 AI 컴퓨팅 클러스터로 운영될 수 있는 분산형 데이터 센터 구축을 적극적으로 모색하고 있습니다. 이러한 아키텍처는 장거리, 고대역폭, 저지연 전송을 지원해야 하는 고급 데이터 센터 상호연결(DCI) 광통신 기술에 크게 의존합니다. 중공 광섬유와 같은 혁신 기술의 도입이 가속화될 것으로 예상됩니다.

노드 아키텍처 사용자 정의

AI 클러스터를 구축하는 기존 방식은 AI 칩의 개수를 극대화하는 데 중점을 두는 경우가 많았습니다. 그러나 이제는 단순한 규모를 넘어 심층적인 아키텍처 설계에 대한 중요성이 점점 커지고 있습니다.

새로운 트렌드로는 GPU, NPU, CPU, 메모리, 스토리지 등의 컴퓨팅 리소스를 풀링하여 전문가 혼합(MoE)과 같은 아키텍처를 포함하여 대규모 AI 모델의 요구 사항에 맞춰 조정 가능한 클러스터를 만드는 것이 있습니다.

간단히 말해, 베어칩을 제공하는 것만으로는 더 이상 충분하지 않습니다. 최적의 성능과 효율성을 보장하기 위해서는 상황에 맞는 맞춤형 설계가 점점 더 중요해지고 있습니다.

지능형 운영 및 유지 관리

대규모 AI 모델을 훈련하는 것은 오류 발생 가능성이 매우 높으며, 단 몇 시간 만에 오류가 발생할 수 있습니다. 오류가 발생할 때마다 재훈련이 필요하고, 개발 기간이 길어지며 운영 비용이 증가합니다.

이러한 위험을 완화하기 위해 기업들은 지능형 운영 및 유지보수 도구를 도입하여 시스템 안정성과 신뢰성을 최우선으로 고려하고 있습니다. 이러한 시스템은 다음과 같은 이점을 제공합니다.

- 잠재적인 결함 예측

- 최적이 아니거나 성능이 저하된 하드웨어 식별

- 사전 예방적 구성 요소 교체 활성화

이러한 접근 방식은 실패율과 가동 중지 시간을 크게 줄여 클러스터 안정성을 강화하고 전반적인 계산 출력을 효과적으로 향상시킵니다.

에너지 효율성 및 지속 가능성

AI 컴퓨팅은 엄청난 에너지 소비를 요구하기 때문에 주요 공급업체들은 전력 사용량을 줄이고 재생 에너지원에 대한 의존도를 높이기 위한 전략을 모색하고 있습니다.

녹색 컴퓨팅 클러스터 구축을 위한 이러한 노력은 중국의 "동부 데이터, 서부 컴퓨팅" 전략과 같은 보다 광범위한 지속 가능성 이니셔티브와 일치합니다. 이 전략은 에너지 할당을 최적화하고 AI 인프라의 장기적인 생태적 개발을 촉진하는 것을 목표로 합니다.

관련 상품:

-

QSFP-DD-400G-SR8 400G QSFP-DD SR8 PAM4 850nm 100m MTP / MPO OM3 FEC 광 트랜시버 모듈

$149.00

QSFP-DD-400G-SR8 400G QSFP-DD SR8 PAM4 850nm 100m MTP / MPO OM3 FEC 광 트랜시버 모듈

$149.00

-

QSFP-DD-400G-DR4 400G QSFP-DD DR4 PAM4 1310nm 500m MTP / MPO SMF FEC 광 트랜시버 모듈

$400.00

QSFP-DD-400G-DR4 400G QSFP-DD DR4 PAM4 1310nm 500m MTP / MPO SMF FEC 광 트랜시버 모듈

$400.00

-

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC 광 트랜시버 모듈

$450.00

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC 광 트랜시버 모듈

$450.00

-

QSFP-DD-400G-FR4 400G QSFP-DD FR4 PAM4 CWDM4 2km LC SMF FEC 광 트랜시버 모듈

$500.00

QSFP-DD-400G-FR4 400G QSFP-DD FR4 PAM4 CWDM4 2km LC SMF FEC 광 트랜시버 모듈

$500.00

-

QSFP-DD-400G-XDR4 400G QSFP-DD XDR4 PAM4 1310nm 2km MTP/MPO-12 SMF FEC 광 트랜시버 모듈

$580.00

QSFP-DD-400G-XDR4 400G QSFP-DD XDR4 PAM4 1310nm 2km MTP/MPO-12 SMF FEC 광 트랜시버 모듈

$580.00

-

QSFP-DD-400G-LR4 400G QSFP-DD LR4 PAM4 CWDM4 10km LC SMF FEC 광 트랜시버 모듈

$600.00

QSFP-DD-400G-LR4 400G QSFP-DD LR4 PAM4 CWDM4 10km LC SMF FEC 광 트랜시버 모듈

$600.00

-

QDD-4X100G-FR-Si QSFP-DD 4 x100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS3.0 실리콘 포토닉스 광 트랜시버 모듈

$650.00

QDD-4X100G-FR-Si QSFP-DD 4 x100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS3.0 실리콘 포토닉스 광 트랜시버 모듈

$650.00

-

QDD-4X100G-FR-4Si QSFP-DD 4 x 100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS4.0 실리콘 포토닉스 광 트랜시버 모듈

$750.00

QDD-4X100G-FR-4Si QSFP-DD 4 x 100G FR PAM4 1310nm 2km MTP/MPO-12 SMF FEC CMIS4.0 실리콘 포토닉스 광 트랜시버 모듈

$750.00

-

QSFP-DD-400G-SR4.2 400Gb/s QSFP-DD SR4 BiDi PAM4 850nm/910nm 100m/150m OM4/OM5 MMF MPO-12 FEC 광 트랜시버 모듈

$900.00

QSFP-DD-400G-SR4.2 400Gb/s QSFP-DD SR4 BiDi PAM4 850nm/910nm 100m/150m OM4/OM5 MMF MPO-12 FEC 광 트랜시버 모듈

$900.00

-

Arista Q112-400G-SR4 호환 400G QSFP112 SR4 PAM4 850nm 100m MTP/MPO-12 OM3 FEC 광 트랜시버 모듈

$450.00

Arista Q112-400G-SR4 호환 400G QSFP112 SR4 PAM4 850nm 100m MTP/MPO-12 OM3 FEC 광 트랜시버 모듈

$450.00

-

FEC 광학적인 송수신기 모듈을 갖춘 Cisco Q112-400G-DR4 호환 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12

$650.00

FEC 광학적인 송수신기 모듈을 갖춘 Cisco Q112-400G-DR4 호환 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12

$650.00

-

OSFP-800G-DR8D-FLT 800G-DR8 OSFP 플랫 탑 PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$1199.00

OSFP-800G-DR8D-FLT 800G-DR8 OSFP 플랫 탑 PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$1199.00

-

OSFP-800G-SR8D-FLT OSFP 8x100G SR8 플랫 탑 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

OSFP-800G-SR8D-FLT OSFP 8x100G SR8 플랫 탑 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

-

OSFP-800G-SR8D OSFP 8x100G SR8 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

OSFP-800G-SR8D OSFP 8x100G SR8 PAM4 850nm 100m DOM 듀얼 MPO-12 MMF 광 트랜시버 모듈

$650.00

-

OSFP-800G-DR8D 800G-DR8 OSFP PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$850.00

OSFP-800G-DR8D 800G-DR8 OSFP PAM4 1310nm 500m DOM 듀얼 MTP/MPO-12 SMF 광 트랜시버 모듈

$850.00

-

OSFP-800G-2FR4L OSFP 2x400G FR4 PAM4 1310nm 2km DOM 이중 이중 LC SMF 광 트랜시버 모듈

$1200.00

OSFP-800G-2FR4L OSFP 2x400G FR4 PAM4 1310nm 2km DOM 이중 이중 LC SMF 광 트랜시버 모듈

$1200.00