Selon le journal Economic Daily News de Taïwan, NVIDIA prévoit de lancer la gamme de serveurs d'IA GB300 de nouvelle génération lors de la conférence GTC en mars prochain.

Récemment, Foxconn et Quanta ont commencé de manière proactive la recherche et le développement du GB300 pour saisir l'opportunité au plus tôt. Il semblerait que NVIDIA ait déterminé de manière préliminaire la configuration de la commande du GB300, Foxconn restant son plus grand fournisseur. Le GB300 devrait arriver sur le marché au premier semestre de l'année prochaine, avant ses concurrents mondiaux. Des sources du secteur révèlent que Quanta et Inventec sont également des partenaires clés pour les serveurs IA GB300 de NVIDIA. Quanta se classe au deuxième rang après Foxconn en termes de part de commande, tandis qu'Inventec a considérablement augmenté sa part de commande par rapport au GB200, ce qui les positionne pour capitaliser sur les opportunités du GB300 de nouvelle génération.

Processeur graphique : B200 → B300

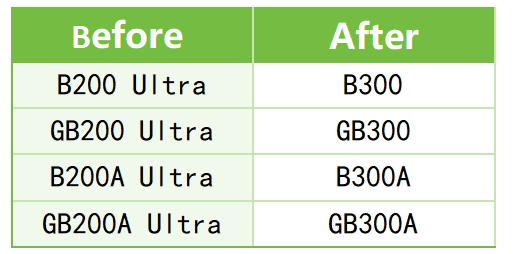

En octobre de cette année, NVIDIA a renommé tous les produits Blackwell Ultra en série B300, qui utilise la technologie CoWoS-L, stimulant ainsi la demande de solutions de packaging avancées.

Augmentation des performances

Le nouveau GPU B300 offre une augmentation de 1.5 fois des performances de calcul en virgule flottante (FP4) par rapport au précédent B200.

Puissance thermique TDP

La consommation électrique du GPU B300 peut atteindre jusqu'à 1400 W, contre environ 1000 W pour le B200, ce qui représente un bond significatif. Pour maintenir cette puissance substantielle, les systèmes d'alimentation et de refroidissement doivent suivre le rythme.

Système de refroidissement liquide amélioré

Plaque de refroidissement liquide + connecteur à changement rapide UQD amélioré : la consommation électrique de 1400 W rend le refroidissement par air insuffisant. Par conséquent, le GB300 utilise des plaques de refroidissement liquide et met à niveau les connecteurs à changement rapide UQD pour une efficacité et une fiabilité améliorées.

Nouvelle conception de l'armoire : la disposition de l'armoire, la conception des canalisations et les canaux de refroidissement ont été repensés pour accueillir un nombre accru de plaques de refroidissement par eau, de systèmes de refroidissement liquide et de composants à connexion rapide UQD.

Mise à niveau importante de la mémoire HBM3e

192 Go → 288 Go : Vous vous souvenez de la mémoire HBM192 de 3 Go à l'époque du GB200 ? Désormais, chaque GPU B300 dispose d'une capacité impressionnante de 288 Go de HBM3e ! Cette augmentation substantielle est essentiellement un feu vert pour un entraînement intensif des modèles, ce qui la rend très attrayante pour les grands modèles avec des centaines de milliards de paramètres.

Empilement de 8 couches → 12 couches : par rapport à la pile à 8 couches précédente, la nouvelle configuration utilise une pile à 12 couches, ce qui augmente non seulement la capacité, mais améliore également considérablement la bande passante. Ce parallélisme élevé permet aux données de circuler sans problème, sans goulots d'étranglement.

Réseau et transmission

Carte réseau : ConnectX 7 → ConnectX 8 : Le GB300 est passé de la carte réseau ConnectX 7 à la ConnectX 8. Cette mise à niveau apporte des améliorations complètes en termes de bande passante, de latence et de fiabilité, garantissant un transfert de données transparent dans les clusters à grande échelle.

Modules optiques : 800G → 1.6T : la mise à niveau de 800G à 1.6T est comparable au passage de la deuxième à la quatrième vitesse. Pour les scénarios impliquant des interactions de données massives, comme l'entraînement HPC et IA, cette augmentation de la bande passante est une bouée de sauvetage.

Gestion de l'alimentation et fiabilité

Nouveaux ajouts : plateau de condensateur standardisé et BBU : l'armoire GB300 NVL72 est désormais dotée d'un plateau de condensateur standardisé avec un système de batterie de secours (BBU) en option. Chaque module BBU coûte environ 300 $ et l'ensemble du système GB300 nécessite environ 5 modules BBU, pour un total d'environ 1500 XNUMX $. Bien que cela puisse sembler coûteux, il s'agit d'un investissement crucial pour éviter les pannes de courant soudaines dans les environnements d'IA à forte charge et à forte puissance.

Forte demande en supercondensateurs : chaque rack NVL72 nécessite plus de 300 supercondensateurs pour gérer les surtensions instantanées et protéger le système. Vendus entre 20 et 25 $ chacun, ces supercondensateurs représentent une dépense importante mais sont nécessaires pour le GB300, très gourmand en énergie.

Révolution majeure de la mémoire

LPCAMM fait son entrée sur le marché des serveurs : NVIDIA a introduit pour la première fois la norme LPCAMM (Low Power CAMM) sur les cartes mères de serveurs. Jusqu'alors utilisée sur les ordinateurs portables légers, cette « petite puce » répond désormais aux exigences élevées des serveurs, prouvant ainsi ses capacités exceptionnelles. L'introduction de la norme LPCAMM dans les serveurs suggère une tendance à les rendre plus « fins et élégants », laissant entrevoir une possible évolution vers une approche plus tendance dans la conception des serveurs.

Remplacer les DIMM traditionnels ? : Les LPCAMM offrent une solution plus compacte, plus économe en énergie et plus facile à entretenir. Elles pourraient remplacer complètement les RDIMM et LRDIMM traditionnels à l'avenir, ce qui pourrait provoquer un bouleversement important sur le marché de la mémoire pour serveurs. Si les LPCAMM remplacent effectivement les DIMM traditionnels, cela pourrait annoncer une transformation majeure dans le paysage de la mémoire pour serveurs.

Le NVIDIA GB300 « Blackwell Ultra » devrait considérablement élever le plafond de la puissance de calcul de l'IA. Les améliorations apportées aux cœurs GPU, la prise en charge massive de la mémoire HBM3e et les mises à niveau complètes en matière de refroidissement et de gestion de l'alimentation indiquent que les grands modèles et le calcul à grande échelle sont les tendances imparables du futur. De plus, avec l'inclusion de LPCAMM et d'une bande passante réseau de 1.6 T, l'efficacité des centres de données cloud et des centres de supercalcul sera encore améliorée.

Il est clair que la « course aux armements » pour la puissance de calcul de l’IA ne fait que commencer. Ceux qui prendront la tête des écosystèmes matériels et logiciels pourraient bien dominer la prochaine vague de la révolution de l’IA.