Origine du nom

G – Grace CPU

B – GPU Blackwell

200 – Génération

NVL – Technologie d'interconnexion NVlink

72 – 72 GPU

Configuration de la puissance de calcul

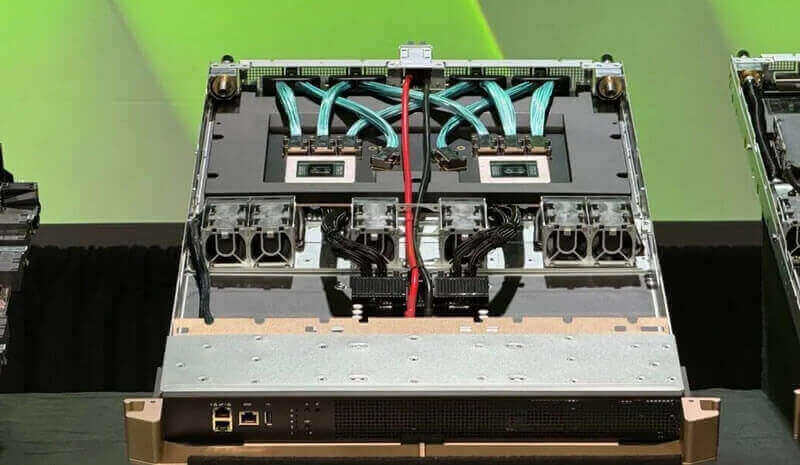

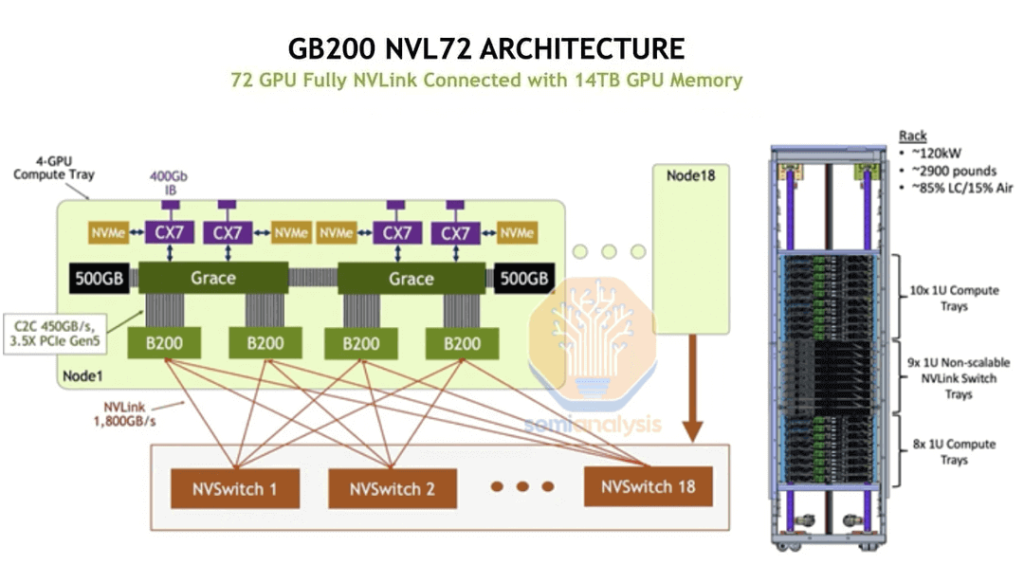

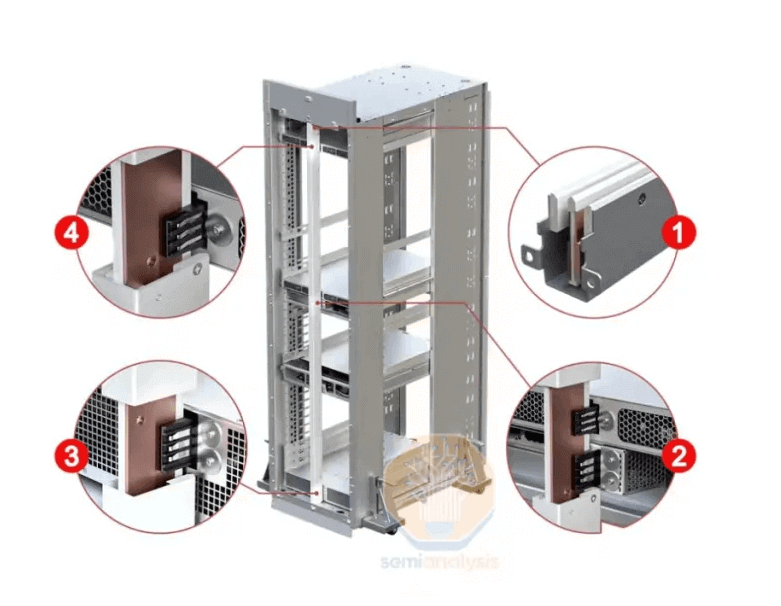

Chaque NVL72 dispose de 18 plateaux de calcul, qui sont les unités de base de la configuration de puissance de calcul du NVL72. Chaque plateau sert de nœud de calcul. Le NVL200 GB72 définit le super chipset de la carte Bianca, où chaque chipset comprend un processeur Grace (développé par NV sur la base de l'architecture ARM) et deux puces GPU Blackwell. Chaque plateau de calcul se compose de deux super chipsets, c'est-à-dire 2 processeurs + 4 GPU. Les 72 plateaux de calcul du NVL18 totalisent 18 * 4 = 72 GPU.

Chaque plateau de calcul, au format 1U, se branche directement sur le châssis. Il s'agit de l'unité minimale pour le déploiement et la maintenance quotidiens, chaque plateau de calcul consommant jusqu'à 5400 XNUMX W d'énergie.

L'ensemble du système NVL72 dispose de 13.8 To de mémoire vidéo, chaque puce B200 contenant 192 Go de mémoire vidéo, soit une augmentation de 112 Go par rapport aux 100 Go du H80. De plus, la bande passante mémoire du GPU unique a été mise à niveau de 3.35 To/s dans le H100 à 8 To/s. Le système comprend également 17 To de mémoire DDR5X, chaque puce Bianca étant équipée de 480 Go de mémoire.

Configuration de refroidissement

Pendant la phase H100, chaque GPU consommait 700 W. Pour répondre aux exigences de refroidissement par air et créer un meilleur environnement aérodynamique, l'ensemble du système s'intègre dans un espace 6-8U avec 8 H100. Dans la phase B200, chaque puce consomme 1200 W, ce qui nécessite plus d'espace de refroidissement, ce qui permet d'étendre le système à une taille de 10 U (8 * B200).

Dans le scénario de la carte GB200 Bianca, avec une consommation électrique de 2700 W, la vitesse de l'air est insuffisante pour assurer un refroidissement efficace dans un rack de 19 pouces, ce qui nécessite une solution de refroidissement liquide. Cela permet de contrôler le volume du système dans la plage 1-2U, améliorant considérablement l'utilisation de l'espace et l'efficacité du refroidissement.

- Au niveau du serveur : le refroidissement liquide peut répondre aux besoins de refroidissement des processeurs et des GPU de la carte Bianca grâce à des plaques froides. Cependant, la partie avant de chaque plateau de calcul et plateau de commutateur NV contient encore de nombreux composants personnalisés, tels que des cartes réseau, des PDU, des cartes de gestion et des disques durs, qui nécessitent toujours un refroidissement par air. En règle générale, le rapport liquide/air pour un plateau de calcul est d'environ 8.5:1.5. À l'avenir, en cas d'évolution basée sur des cartes réseau CX, des plaques froides pourraient être conçues pour les cartes réseau.

- Au niveau du rack : Différentes solutions de refroidissement liquide sont actuellement disponibles :

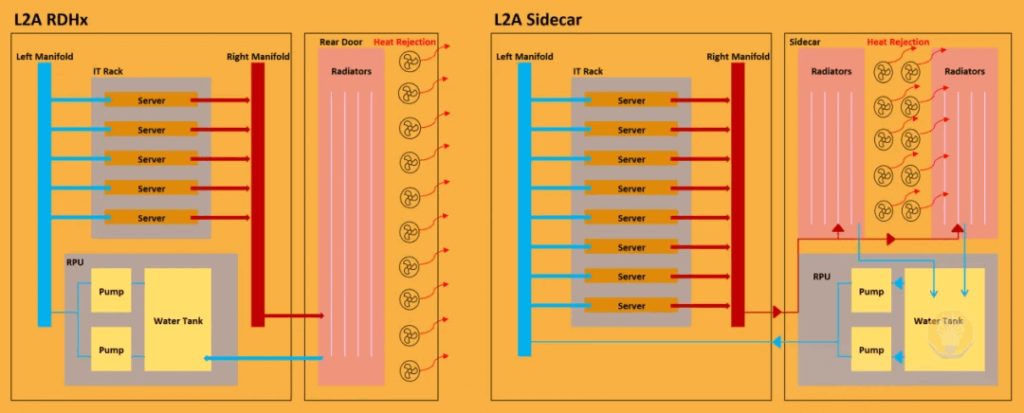

- Solutions de modernisation pour les anciennes salles climatisées par air : il existe deux options, RDHx et Sidecar, la première fournissant un refroidissement de 30 à 40 kW et la seconde de 70 à 140 kW. Ces solutions permettent d'ajouter un système de refroidissement liquide à chaque rack sans modifier les unités CVC refroidies par air existantes, en utilisant un réfrigérant pour transférer la chaleur vers un radiateur pour l'échange d'air (en conservant l'environnement de refroidissement de l'air intérieur). Des modifications minimes sont nécessaires, évitant ainsi des rénovations importantes des canalisations.

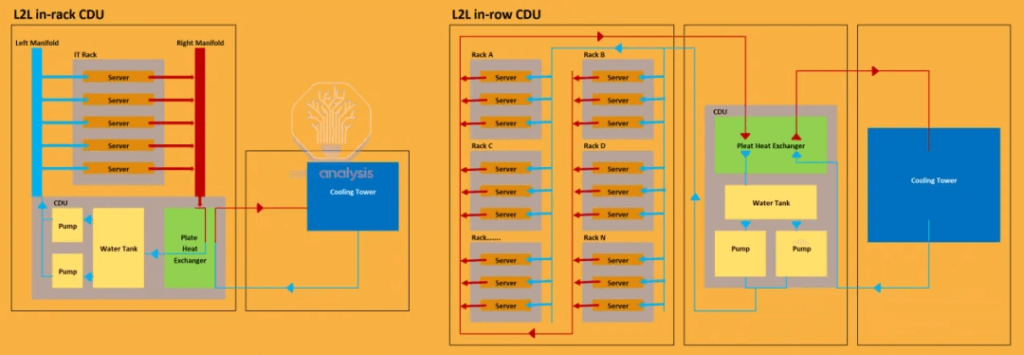

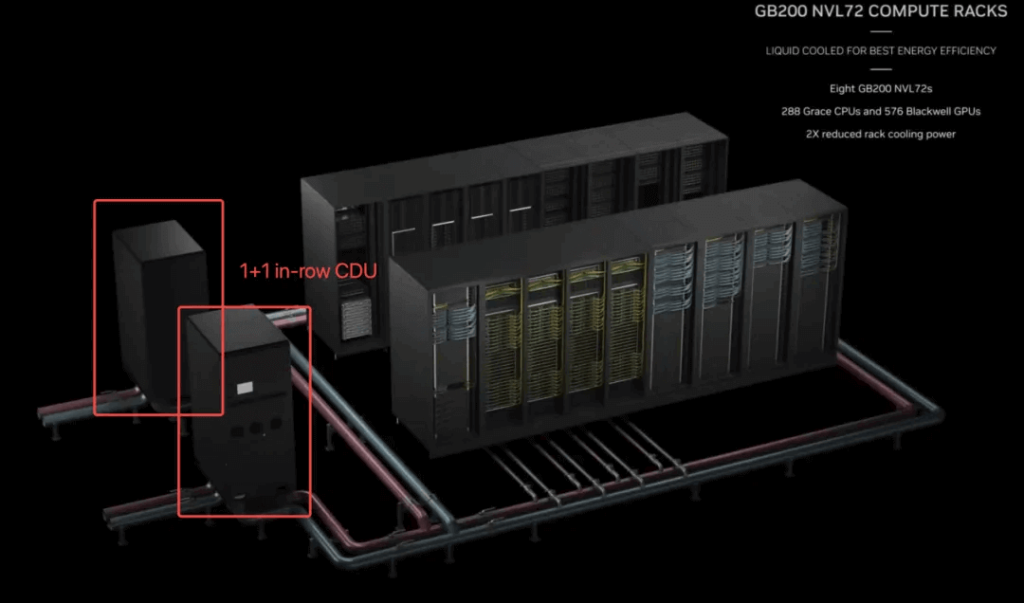

- Nouveaux centres de données haute densité : pour les nouveaux centres de données haute densité comme le NV72, les CDU en rack et les CDU en rangée sont les principales options. Les CDU en rack nécessitent plus de 4U d'espace dans le rack et offrent généralement une efficacité de refroidissement d'environ 80 kW sans capacités de redondance. En revanche, les CDU en rangée sont installés à l'extérieur des racks individuels et assurent le refroidissement de plusieurs racks ou rangées, configurés avec deux systèmes CDU, offrant un refroidissement et une redondance de 800 à 2000 576 kW. Le marketing officiel du cluster NVLXNUMX utilise la solution en rangée.

Configuration de réseau

Réseau NVLink

Le NVL72 dispose d'une architecture NVLink entièrement interconnectée, éliminant le besoin de réseaux RDMA (IB&RoCE) en mode NVL72.

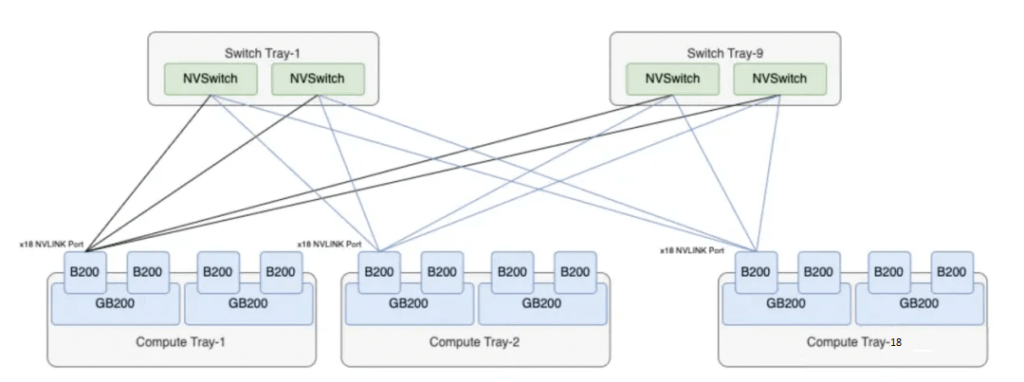

Le système NVL72 est équipé de 9 plateaux NVSwitch, chacun contenant 2 puces de commutation NVLink. Chaque puce prend en charge un débit de 4 * 1.8 To/s, pour une capacité totale de 7.2 To/s, soit 57.6 Tbit/s. Cette capacité est légèrement supérieure aux 5 Tbit/s de la puce TH51.2 populaire. Chaque plateau NVSwitch offre une capacité NVLink de 2 * 4 * 1.8 To/s = 14.4 To/s.

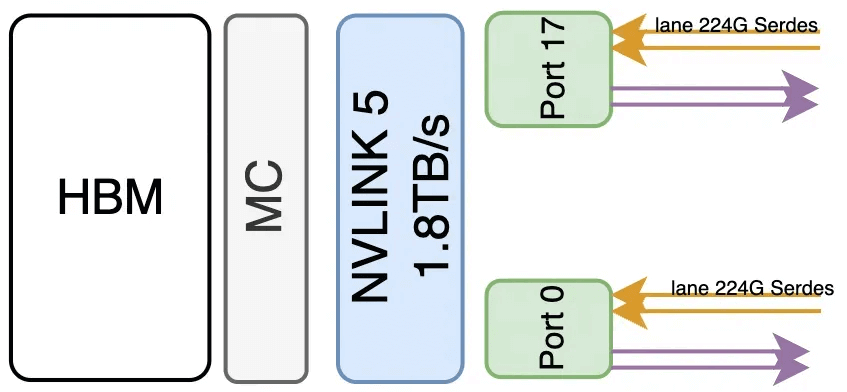

Le GB200 utilise NVLink 5.0, chaque puce B200 étant interconnectée aux puces de commutation NVLink via 18 connexions NVLink 5.0. Par conséquent, une unité NVL72 possède 72 * 18 = 1296 ports NVLink 5.0, chaque port offrant un débit bidirectionnel de 100 Go/s, composé de 4 paires de lignes de signal différentielles. Chaque paire est connectée par un câble en cuivre, ce qui donne 1296 * 4 = 5184 connexions physiques.

Comme illustré, les 9 plateaux NVSwitch d'une armoire GB200 NVL72 sont utilisés pour connecter 72 puces B200. Chaque puce B200 est reliée à 18 puces NVSwitch via une seule connexion bidirectionnelle NVLink 5.0 de 100 Go. Chaque puce NVSwitch prend en charge une bande passante de 7.2 Go, correspondant à 72 connexions NVLink 5.0, ce qui permet le déploiement de 72 GPU B200. Il n'existe aucune interface NVLink supplémentaire pour l'extension vers des clusters plus grands.

Le réseau NVLink au sein du NVL200 GB72 forme un état entièrement interconnecté, permettant une interconnectivité complète pour 72 puces B200 via un seul saut NVSwitch. Chaque puce de commutation dispose de 4 ports NVLink, chaque port étant associé à 72 câbles en cuivre, ce qui réduit considérablement la consommation d'énergie et le coût des communications optiques, et permet d'économiser jusqu'à 20 kW par système. La structure de communication interne du NVL72 est illustrée dans le diagramme suivant :

Réseau non NVLink (RDMA + réseau TCP haut débit)

Chaque plateau de calcul comprend 4 emplacements OSFP et 2 emplacements QSFP. La disposition des ports réseau sur le panneau avant du plateau de calcul est illustrée ci-dessous :

- Les 2 emplacements QSFP, pris en charge par le DPU Bluefield-3, fournissent des ports 400G/800G pour une interconnectivité réseau TCP/stockage hautes performances, formant le réseau frontal proposé par NV.

b. Les 4 emplacements OSFP, avec ports CX7/CX8 800G/1.6 To, prennent en charge l'extension externe du GB200 à l'aide de la communication réseau RDMA, constituant le réseau back-end proposé par NV.

En raison de l'architecture de conception, des coûts de transmission et des capacités de la puce, NV fournit actuellement une solution réseau NVLink pure pour un maximum de 576 GPU, soit l'équivalent de 8 unités NVL200 GB72. Pour une extension supplémentaire des clusters de formation/inférence IA, des réseaux RDMA sont nécessaires. NVLink 5.0 atteint une bande passante de 100 Go/s par GPU, avec 18 connexions par GPU, pour un total de 1.8 To/s de bande passante. Le débit de port unique le plus rapide actuel de RDMA est de 200 Go/s (1.6 Tbit/s), ce qui ne correspond pas à la vitesse de NVLink.

Configuration de l'alimentation

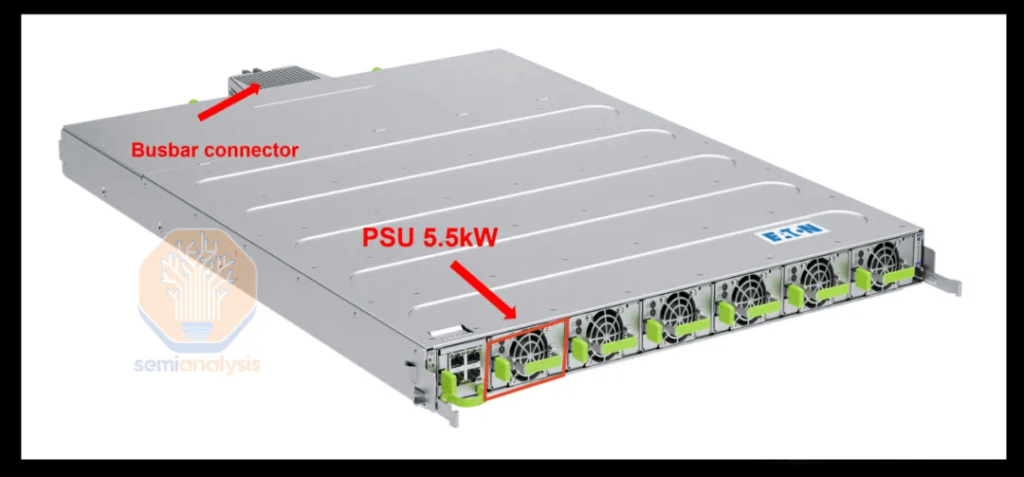

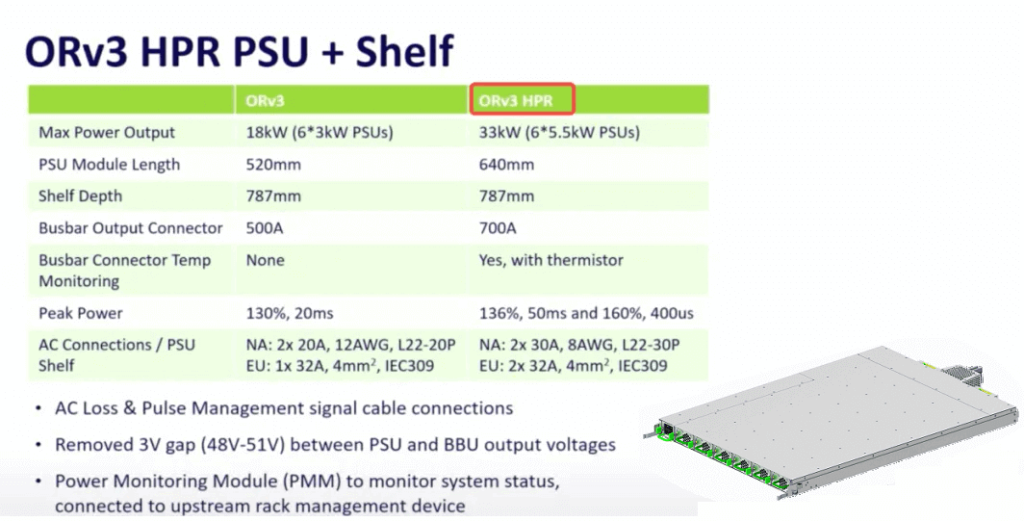

Consommation électrique nominale globale : Le système a une consommation électrique nominale globale de 120 kW. Il est configuré en 2N avec 4+4 (ou 4+2) plateaux d'alimentation, chacun prenant en charge 33 kW. Chaque plateau d'alimentation peut accueillir six unités d'alimentation de 5.5 kW, offrant une redondance 5+1.

Spécifications de l'étagère d'alimentation : Les étagères d'alimentation utilisent l'étagère d'alimentation ORv3 HPR d'OCP, offrant une efficacité énergétique de plus de 97.5 %, réduisant ainsi les pertes de puissance pendant le processus de conversion CA-CC. De plus, il utilise une sortie CC basse tension 48 V/50 V pour chaque emplacement, ce qui offre des pertes de transmission de puissance inférieures par rapport à la sortie 12 V traditionnelle.

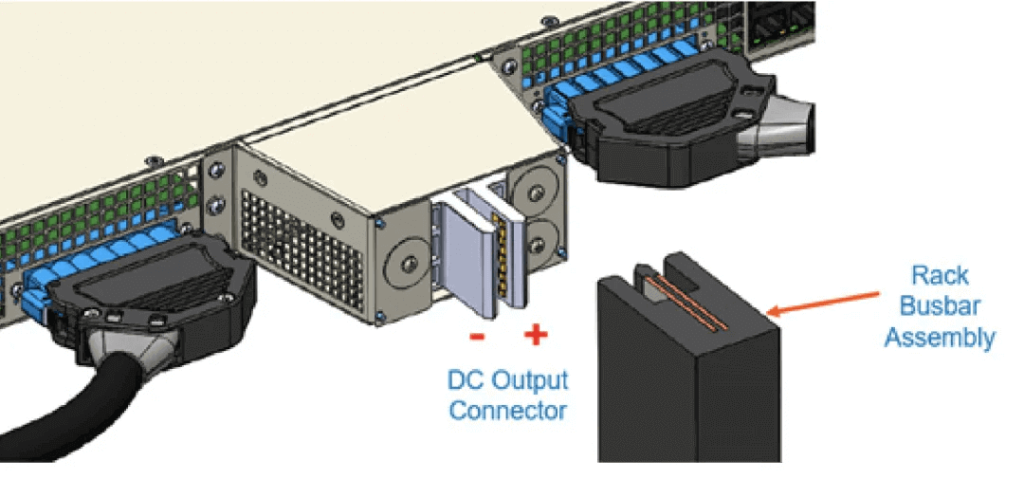

Norme d'alimentation d'entrée du rack : L'alimentation d'entrée du rack est conforme à la norme ORv3 HPR d'OCP, avec une entrée CA de 415 V. Chaque emplacement est directement connecté au jeu de barres du rack via des connexions physiques.

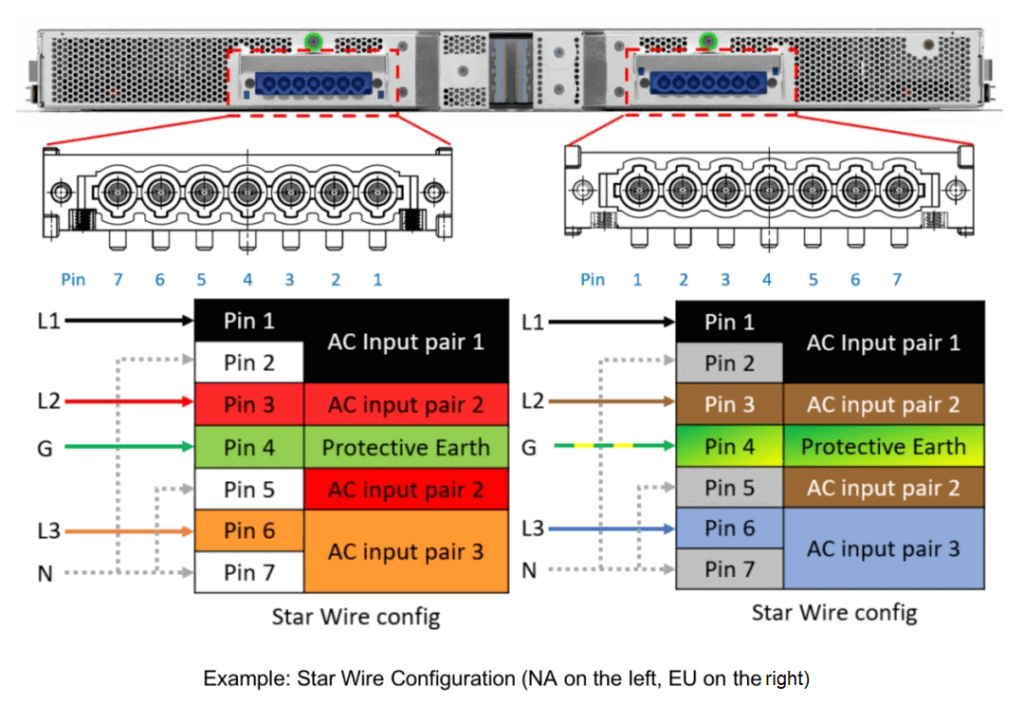

Configuration d'entrée CA : Du côté de l'entrée CA, le système utilise des connecteurs à 3 broches définis par ORv7. Le schéma ci-dessous montre deux normes de connecteur différentes (à gauche pour l'Amérique du Nord, à droite pour l'Europe). Sur la base de la prise en charge de 33 kW de l'étagère d'alimentation, chaque entrée adhère probablement à une norme de disjoncteur de 125 A.

Connexions d'entrée CA en amont : l'extrémité amont de l'entrée CA utilise des connecteurs industriels standard, conformes aux normes IEC 60309-2 et classés IP67. Ces prises industrielles mobiles prennent en charge un disjoncteur de 125 A. Selon la tension de phase, vous pouvez choisir entre des configurations 3 A à 125 broches ou 5 A à 125 broches.

Produits associés:

-

OSFP-800G-FR4 800G OSFP FR4 (200G par ligne) Module émetteur-récepteur optique PAM4 CWDM Duplex LC 2km SMF

$3500.00

OSFP-800G-FR4 800G OSFP FR4 (200G par ligne) Module émetteur-récepteur optique PAM4 CWDM Duplex LC 2km SMF

$3500.00

-

OSFP-800G-2FR2L 800G OSFP 2FR2 (200G par ligne) PAM4 1291/1311nm 2km DOM Duplex LC SMF Module émetteur-récepteur optique

$3000.00

OSFP-800G-2FR2L 800G OSFP 2FR2 (200G par ligne) PAM4 1291/1311nm 2km DOM Duplex LC SMF Module émetteur-récepteur optique

$3000.00

-

OSFP-800G-2FR2 800G OSFP 2FR2 (200G par ligne) PAM4 1291/1311nm 2km DOM double CS SMF Module émetteur-récepteur optique

$3000.00

OSFP-800G-2FR2 800G OSFP 2FR2 (200G par ligne) PAM4 1291/1311nm 2km DOM double CS SMF Module émetteur-récepteur optique

$3000.00

-

OSFP-800G-DR4 800G OSFP DR4 (200G par ligne) PAM4 1311nm MPO-12 500m SMF DDM Module émetteur-récepteur optique

$3000.00

OSFP-800G-DR4 800G OSFP DR4 (200G par ligne) PAM4 1311nm MPO-12 500m SMF DDM Module émetteur-récepteur optique

$3000.00

-

NVIDIA MMS4X00-NM-FLT Compatible 800G Twin-port OSFP 2x400G Flat Top PAM4 1310nm 500m DOM Dual MTP/MPO-12 Module émetteur-récepteur optique SMF

$1199.00

NVIDIA MMS4X00-NM-FLT Compatible 800G Twin-port OSFP 2x400G Flat Top PAM4 1310nm 500m DOM Dual MTP/MPO-12 Module émetteur-récepteur optique SMF

$1199.00

-

NVIDIA MMA4Z00-NS-FLT Compatible 800Gb/s Twin-port OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 Module émetteur-récepteur optique MMF

$650.00

NVIDIA MMA4Z00-NS-FLT Compatible 800Gb/s Twin-port OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 Module émetteur-récepteur optique MMF

$650.00

-

NVIDIA MMS4X00-NM Compatible 800Gb/s double port OSFP 2x400G PAM4 1310nm 500m DOM double MTP/MPO-12 Module émetteur-récepteur optique SMF

$900.00

NVIDIA MMS4X00-NM Compatible 800Gb/s double port OSFP 2x400G PAM4 1310nm 500m DOM double MTP/MPO-12 Module émetteur-récepteur optique SMF

$900.00

-

NVIDIA MMA4Z00-NS Compatible 800Gb/s Twin-port OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 Module émetteur-récepteur optique MMF

$650.00

NVIDIA MMA4Z00-NS Compatible 800Gb/s Twin-port OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 Module émetteur-récepteur optique MMF

$650.00

-

NVIDIA MMS1Z00-NS400 Compatible 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12 avec Module émetteur-récepteur optique FEC

$700.00

NVIDIA MMS1Z00-NS400 Compatible 400G NDR QSFP112 DR4 PAM4 1310nm 500m MPO-12 avec Module émetteur-récepteur optique FEC

$700.00

-

NVIDIA MMS4X00-NS400 Compatible 400G OSFP DR4 Flat Top PAM4 1310nm MTP/MPO-12 500m SMF FEC Module Émetteur-Récepteur Optique

$700.00

NVIDIA MMS4X00-NS400 Compatible 400G OSFP DR4 Flat Top PAM4 1310nm MTP/MPO-12 500m SMF FEC Module Émetteur-Récepteur Optique

$700.00

-

Module émetteur-récepteur optique OSFP 4x50G FR2 PAM400 4nm 4km DOM double Duplex LC SMF Compatible NVIDIA MMS1310X2-NM

$1200.00

Module émetteur-récepteur optique OSFP 4x50G FR2 PAM400 4nm 4km DOM double Duplex LC SMF Compatible NVIDIA MMS1310X2-NM

$1200.00

-

Module émetteur-récepteur optique OSFP-XD-1.6T-4FR2 1.6T OSFP-XD 4xFR2 PAM4 1291/1311nm 2km SN SMF

$15000.00

Module émetteur-récepteur optique OSFP-XD-1.6T-4FR2 1.6T OSFP-XD 4xFR2 PAM4 1291/1311nm 2km SN SMF

$15000.00

-

Module émetteur-récepteur optique LC SMF double duplex OSFP-XD-1.6T-2FR4 1.6T OSFP-XD 2xFR4 PAM4 2x CWDM4 2 km

$20000.00

Module émetteur-récepteur optique LC SMF double duplex OSFP-XD-1.6T-2FR4 1.6T OSFP-XD 2xFR4 PAM4 2x CWDM4 2 km

$20000.00

-

Module émetteur-récepteur optique OSFP-XD-1.6T-DR8 1.6T OSFP-XD DR8 PAM4 1311nm 2km MPO-16 SMF

$12000.00

Module émetteur-récepteur optique OSFP-XD-1.6T-DR8 1.6T OSFP-XD DR8 PAM4 1311nm 2km MPO-16 SMF

$12000.00