Los adaptadores de red de la familia NVIDIA ConnectX-7 son compatibles con los protocolos InfiniBand y Ethernet, lo que proporciona una solución versátil para una amplia gama de necesidades de red. Estos adaptadores están diseñados para brindar capacidades de red inteligentes, escalables y ricas en funciones, que satisfacen los requisitos de las aplicaciones empresariales tradicionales, así como las cargas de trabajo de alto rendimiento en IA, computación científica y centros de datos en la nube a hiperescala.

Los adaptadores de red ConnectX-7 están disponibles en dos factores de forma diferentes: tarjetas PCIe verticales y tarjetas Open Compute Project (OCP) Spec 3.0. Esta flexibilidad permite a los usuarios elegir el adaptador que mejor se adapte a sus requisitos de implementación específicos.

Las redes de 400 Gbps son una nueva capacidad que pueden manejar las ranuras PCIe Gen5 x16. Echemos un vistazo a la configuración para usar NDR 400Gbps InfiniBand/400GbE.

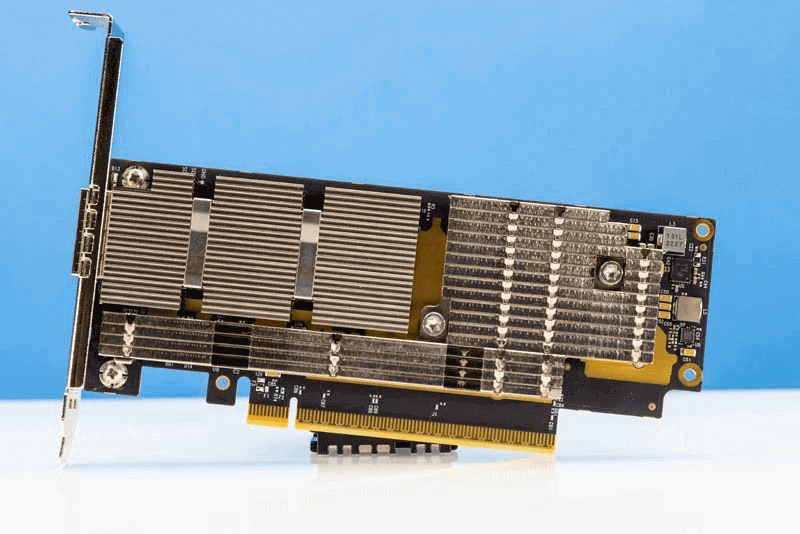

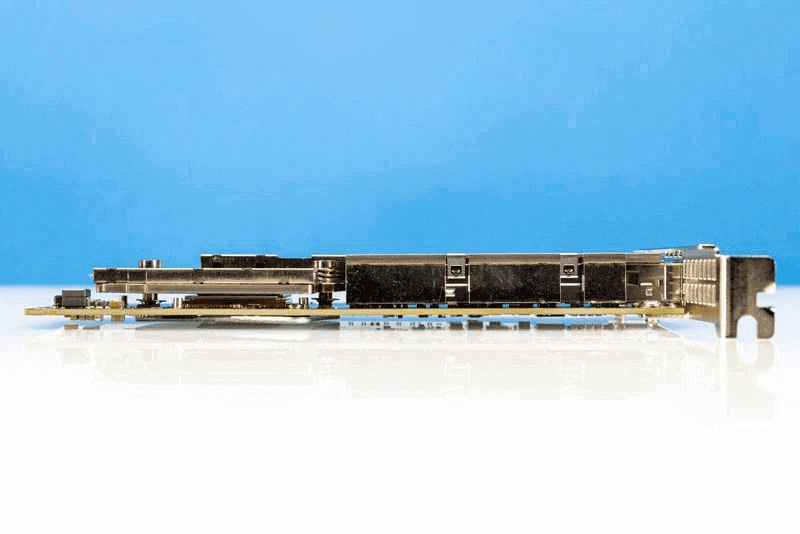

Ángulo 1 tiro de NVIDIA ConnectX 7 400G OSFP

Descripción general del hardware del adaptador MCX75310AAS-NEAT

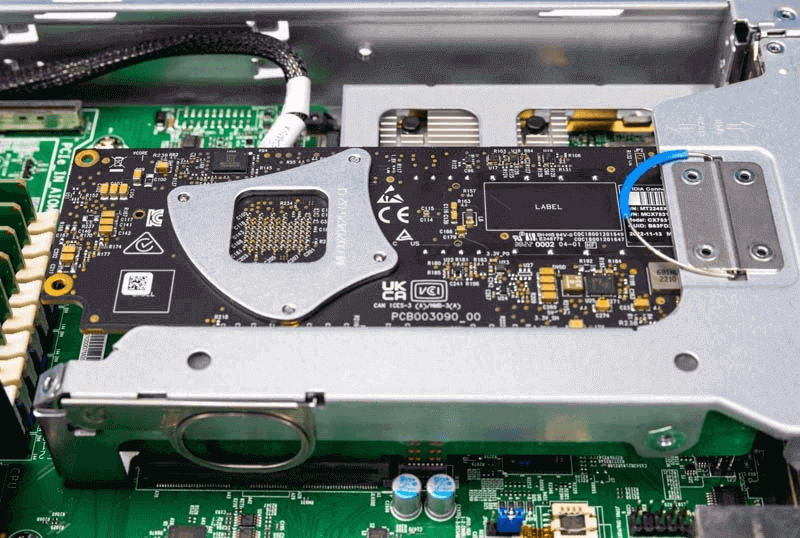

ConnectX-7 (MCX75310AAS-NEAT) es una tarjeta de bajo perfil diseñada para ranuras PCIe Gen5 x16. La siguiente imagen muestra el soporte de altura completa, pero también incluye un soporte de perfil bajo en la caja.

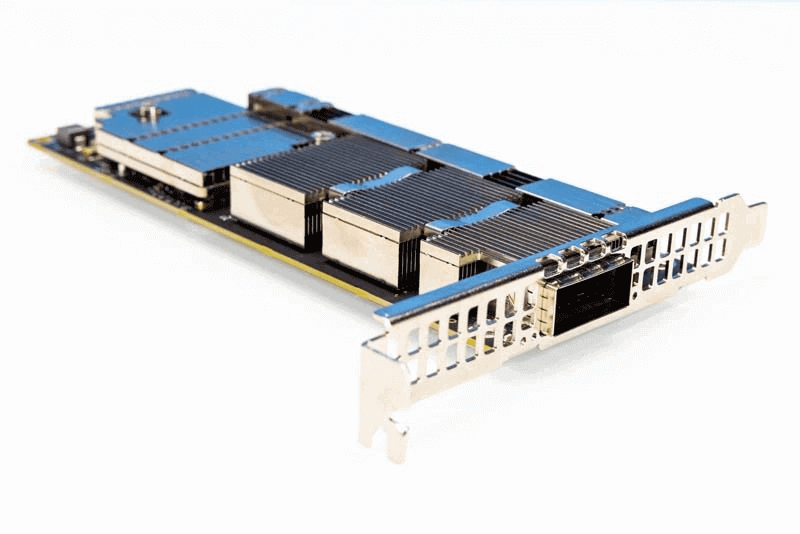

Frente de NVIDIA ConnectX 7 400G OSFP

Vale la pena señalar las dimensiones de la solución de enfriamiento. Sin embargo, NVIDIA no revela las especificaciones de energía de estos adaptadores de red.

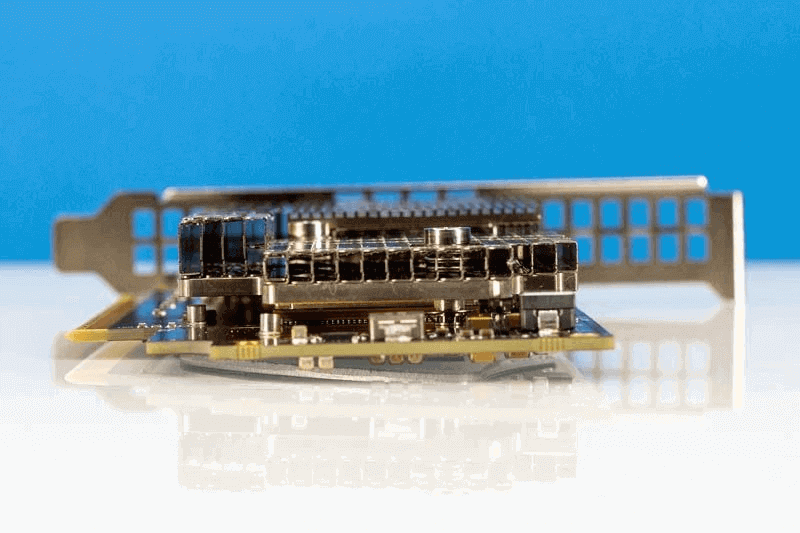

Ángulo 2 shot de NVIDIA ConnectX 7 400G OSFP

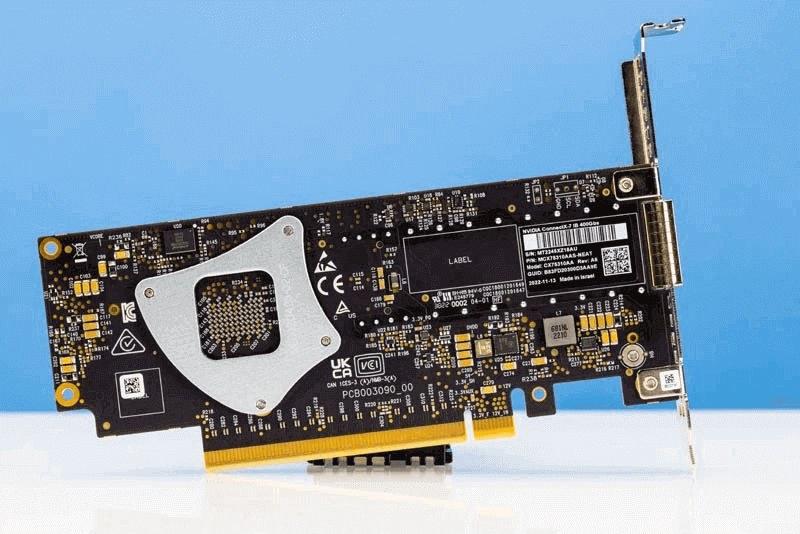

Aquí está la parte posterior de la tarjeta con una placa posterior del disipador de calor.

La parte posterior de la tarjeta NVIDIA ConnectX 7 400G OSFP

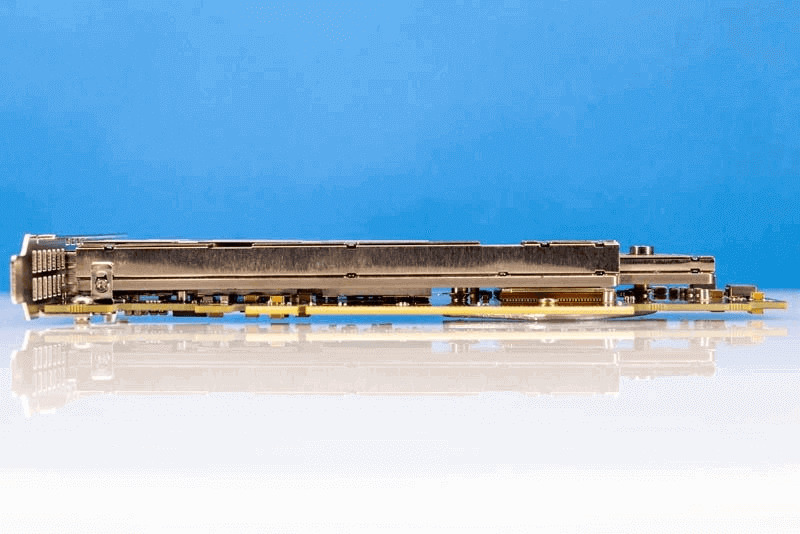

Esta es una vista lateral de la tarjeta desde el conector PCIe Gen5 x16.

Ángulo del conector NVIDIA ConnectX 7 400G OSFP

Esta es otra vista de la tarjeta desde la parte superior de la tarjeta.

Ángulo superior NVIDIA ConnectX 7 400G OSFP

Esta es una vista desde la dirección del flujo de aire en la mayoría de los servidores.

Esta es una tarjeta plana de un solo puerto que funciona a una velocidad de 400 Gbps. Proporciona una enorme cantidad de ancho de banda.

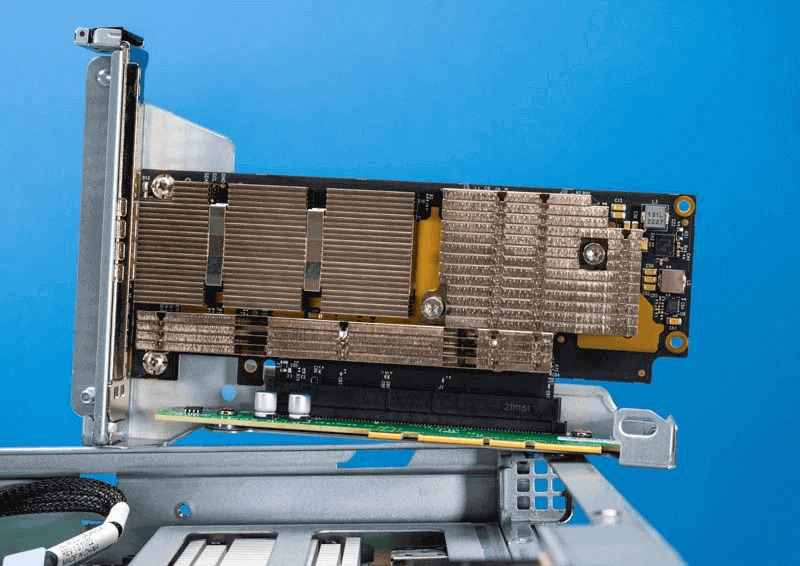

Instalación del adaptador NVIDIA ConnectX-7 400G

Uno de los aspectos más importantes de una tarjeta de este tipo es instalarla en un sistema que pueda aprovechar su velocidad.

El procedimiento de instalación de las tarjetas adaptadoras ConnectX-7 implica los siguientes pasos:

- Compruebe los requisitos de hardware y software del sistema.

- Preste atención a la consideración del flujo de aire dentro del sistema host.

- Siga las precauciones de seguridad.

- Desembale el paquete.

- Siga la lista de comprobación previa a la instalación.

- (Opcional) Reemplace el soporte de montaje de altura completa con el soporte corto suministrado.

- Instale la tarjeta adaptadora ConnectX-7 PCle x16/la tarjeta adaptadora ConnectX-7 2x PCle x16 Socket Direct en el sistema.

- Conectar cables o módulos a la tarjeta.

- Identifique ConnectX-7 en el sistema.

Supermicro SYS 111C NR con adaptador NVIDIA ConnectX 7 de 400 Gbps 1

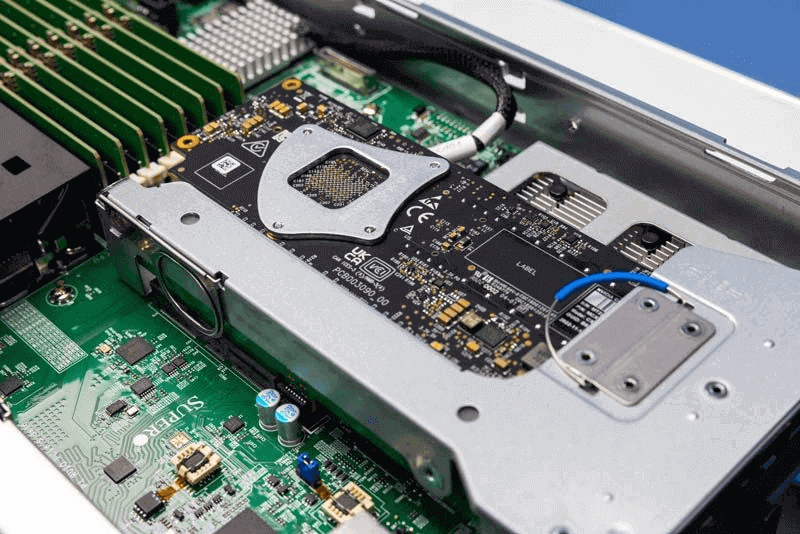

Afortunadamente, hemos instalado con éxito estos dispositivos en los servidores Supermicro SYS-111C-NR 1U y Supermicro SYS-221H-TNR 2U y funcionan bien.

Supermicro SYS 111C NR con adaptador NVIDIA ConnectX 7 de 400 Gbps 2

El SYS-111C-NR es un servidor de nodo de una sola ranura que nos brinda más flexibilidad porque no necesitamos preocuparnos por las conexiones entre las ranuras al configurar el sistema. A velocidades de 10/40 Gbps o incluso de 25/50 Gbps, ha habido discusiones sobre los desafíos de rendimiento a través de las conexiones entre las ranuras de la CPU. Con la llegada de 100 GbE, el problema de tener un adaptador de red para cada CPU para evitar conexiones entre ranuras se hizo más prominente y frecuente. El impacto es aún más pronunciado y grave cuando se utilizan redes con velocidades de 400 GbE. Para los servidores de dos ranuras que usan una única NIC de 400 GbE, puede ser una opción que valga la pena considerar buscar varios adaptadores de host que se conecten directamente a cada CPU.

OSFP frente a QSFP-DD

Una vez instaladas las tarjetas, teníamos nuestro siguiente desafío. Estas tarjetas utilizan jaulas OSFP, pero nuestro conmutador de 400 GbE utiliza QSFP-DD.

Supermicro SYS 111C NR con adaptador NVIDIA ConnectX 7 de 400 Gbps 4

Estos dos estándares tienen algunas diferencias en los niveles de potencia y el diseño físico. Es posible convertir QSFP-DD a OSFP, pero lo contrario no es posible. Si nunca ha visto la óptica OSFP o los DAC, tienen sus propias soluciones de gestión térmica únicas. QSFP-DD generalmente usa un disipador de calor en la parte superior del zócalo, mientras que OSFP generalmente incluye una solución de enfriamiento en los DAC OSFP y la óptica en el laboratorio.

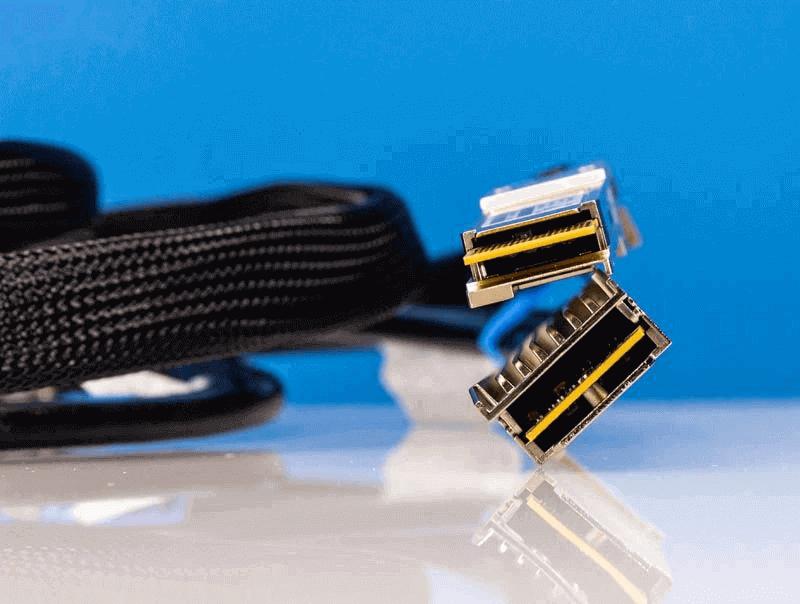

Conectores OSFP y QSFP-DD 1

Este es complicado. Tanto el OSFP DAC como el OSFP a QSFP-DD DAC utilizan una solución de refrigeración por disipador térmico. Y debido al enfriamiento directo en el DAC, el enchufe OSFP no se insertará en el puerto OSFP del Tarjeta de red ConnectX-7.

Es probable que NVIDIA use OSFP porque tiene un nivel de potencia más alto. OSFP permite ópticas de 15W, mientras que QSFP-DD solo admite 12W. Tener un techo de potencia más alto puede facilitar la adopción temprana durante la fase de adopción temprana, que es una de las razones por las que están disponibles productos como el módulo CFP24 de 8 W.

Siempre que sea posible, tenga en cuenta el tamaño del disipador de calor en el lado OSFP del inserto ConnectX-7. Si está acostumbrado a QSFP/QSFP-DD, entonces todos los dispositivos se conectarán y funcionarán bien, pero encontrar un problema menor como el tamaño del conector puede presentar un desafío mayor. Sin embargo, si usted es un proveedor de soluciones, esta también es una oportunidad para brindar soporte de servicio profesional. Distribuidores como NVIDIA y PNY también venden cables LinkX, lo que habría sido una opción más conveniente. Esta es una lección valiosa.

A continuación, configuremos todo esto y pongámonos a trabajar.

Configuración del software NDR InfiniBand frente a 400 GbE

Además de hacer la instalación física, también trabajamos en el software en el servidor. Afortunadamente, esta fue la parte más fácil. Utilizamos el adaptador ConnectX-2910 de la serie MT7 de Supermicro.

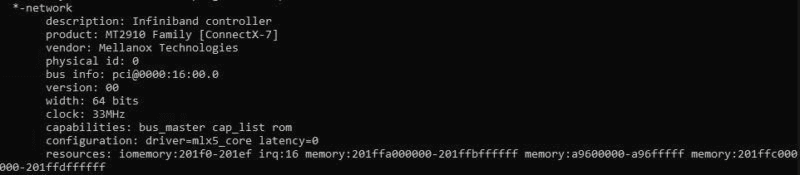

NVIDIA MT2910 Lshw

Al realizar una instalación y un reinicio rápidos de OFED (OpenFabrics Enterprise Distribution), el

tenemos el sistema listo.

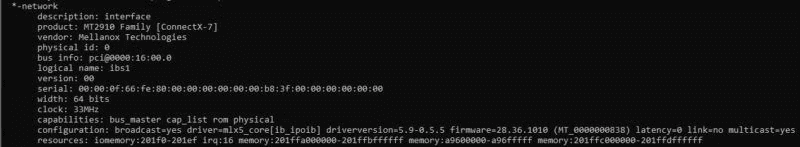

NVIDIA MT2910 Lshw después de la instalación de OFED

Dado que estamos utilizando un conmutador Broadcom Tomahawk 4 en Ethernet y funcionando directamente en modo InfiniBand, también debemos cambiar el tipo de enlace.

El proceso es simple y similar a cambiar el puerto Mellanox ConnectX VPI a Ethernet o InfiniBand en Linux.

El siguiente es el proceso básico:

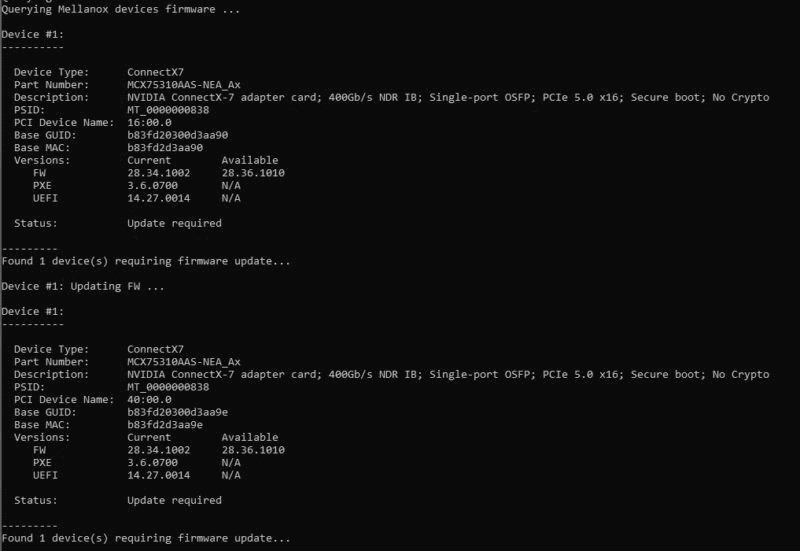

0. Instalar OFED y actualizar el firmware

Este es un paso necesario para garantizar que la tarjeta funcione correctamente.

Durante la instalación de MLNX_OFED_LINUX, NVIDIA ConnectX 7 Mellanox Technologies MT2910 MT2910 Series

El proceso es bastante simple. Primero, descargue la versión requerida para su sistema operativo y use el script provisto en la descarga para instalar el controlador. El instalador estándar también actualizará el firmware de la tarjeta.

NVIDIA ConnectX 7 MT2910 MT2910 MLNX_OFED_LINUX Instalación de la actualización de firmware

Una vez que hemos instalado OFED después de reiniciar el servidor, podemos ver que NVIDIA ConnectX-7 MCX75310AAS-NEAT es compatible con 400GbE y NDR IB (InfiniBand). NDR IB está configurado en el modo predeterminado.

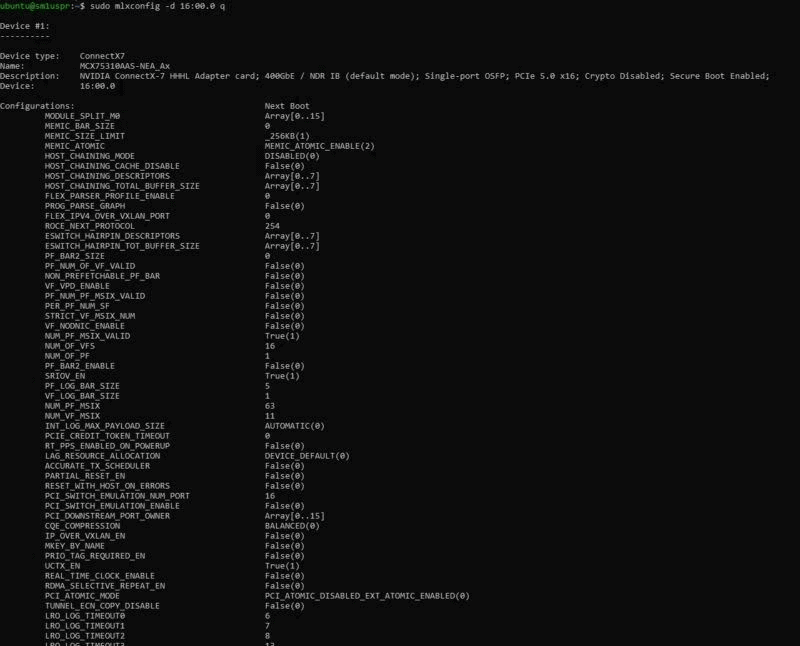

NVIDIA ConnectX 7 MCX75310AAS NEAT Mlxconfig

Si queremos convertirlo en Ethernet, solo hay tres sencillos pasos:

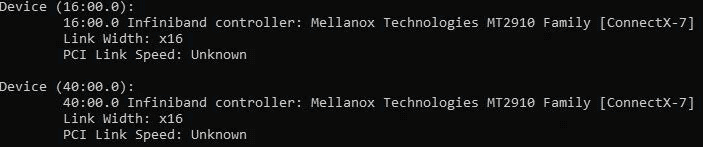

1. Encuentre el dispositivo ConnectX-7

Especialmente si tiene otros dispositivos en su sistema, necesitará encontrar el dispositivo correcto para cambiar. Si solo tiene una tarjeta, eso es fácil de hacer.

lspci | grep mellanox

16:00.0 Controlador Infiniband: Familia Mellanox Technologies MT2910 [ConnectX-7]

Aquí, ahora sabemos que nuestro dispositivo está a las 16:00.0 (como puede ver en la captura de pantalla anterior).

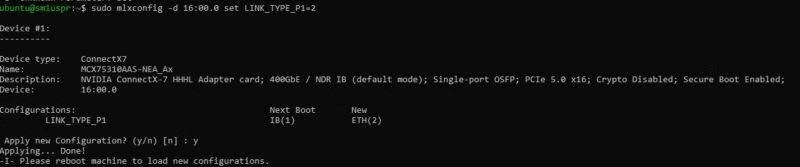

2. Utilice mlxconfig para cambiar el dispositivo ConnectX-7 de NDR Infiniband a Ethernet.

A continuación, utilizaremos el ID del dispositivo para cambiar el tipo de enlace de Infiniband.

sudo mlxconfig -d 16:00.0 establece LINK_TYPE_P1=2

NVIDIA ConnectX 7 MCX75310AAS NEAT Mlxconfig establece el tipo de enlace a Ethernet

Aquí LINK_TYPE_P1=2 establece P1 (puerto 1) en 2 (Ethernet). El LINK_TYPE_P1=1 predeterminado significa que P1 (puerto 1) está configurado en 1 (NDR InfiniBand). Si necesita volver a cambiarlo, simplemente puede revertir el proceso.

3. Reinicie el sistema

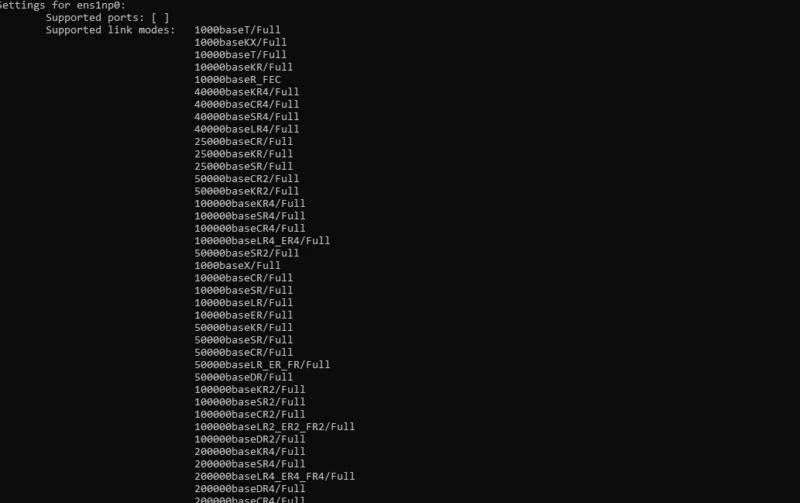

Después de un reinicio rápido, ahora tenemos un adaptador Ethernet ConnectX-7.

Numerosas opciones de velocidad Ethernet para NVIDIA ConnectX 7 MT2910

Este adaptador de 400 Gbps aún admite velocidades de 1 GbE.

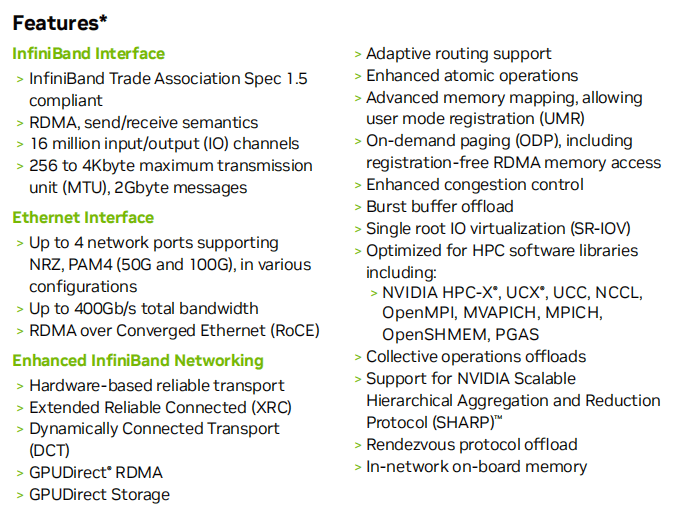

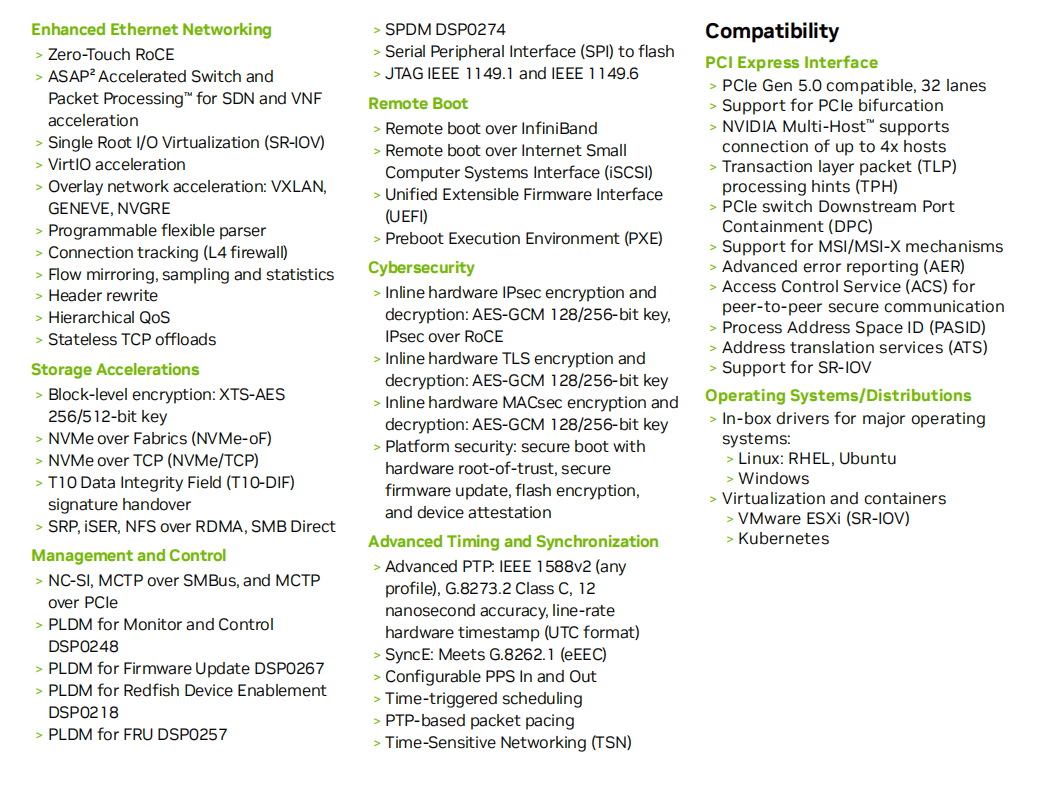

FCaracterísticas y compatibilidad de NVIDIA ConnectX-7

Rendimiento

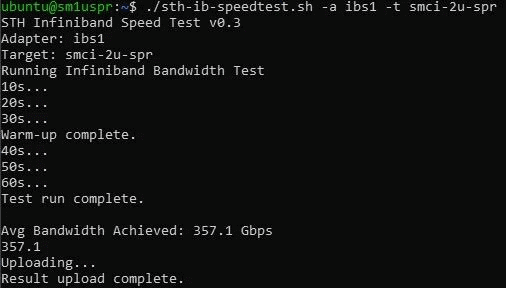

NVIDIA ConnectX 7 400Gbps NDR Infiniband

Por supuesto, hay muchas otras opciones de rendimiento disponibles. Podemos alcanzar velocidades entre 300Gbps y 400Gbps en InfiniBand y Ethernet. Para Ethernet, se necesita algo de ayuda para llegar a velocidades de 400 GbE, ya que la conexión inicial es de solo 200 GbE, pero no hacemos mucho en términos de ajuste del rendimiento.

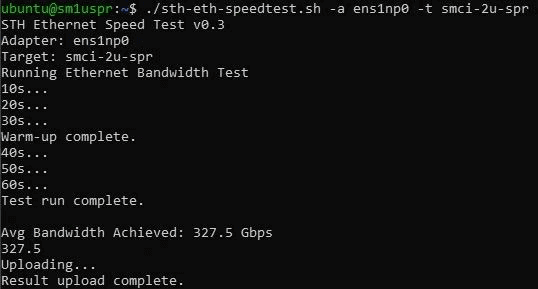

Rendimiento de NVIDIA ConnectX 7 400GbE

Estas velocidades están en el rango de 400 Gbps que se pueden alcanzar, más del triple de la velocidad a la que estamos acostumbrados. adaptadores de 100 Gbps, y en un tiempo muy corto. Sin embargo, es importante enfatizar que la descarga a velocidades de 400 GbE es muy importante. A velocidades de 25 GbE y 100 GbE, hemos visto dispositivos como DPU utilizados para descargar las CPU para tareas de red comunes. En los últimos tres años, los núcleos de CPU modernos han aumentado su velocidad entre un 20 y un 40 por ciento, mientras que el ancho de banda de la red ha aumentado de 100 GbE a 400 GbE. Como resultado, tecnologías como RDMA Las descargas de datos y las descargas de OVS/check se han vuelto fundamentales para minimizar el uso de las CPU. Por eso, la antigua división Nvidia Mellanox es una de las pocas empresas que ofrece adaptadores de 400 Gbps en la actualidad.

Productos relacionados:

-

OSFP-400G-SR4-FLT 400G OSFP SR4 Flat Top PAM4 850nm 30m en OM3/50m en OM4 MTP/MPO-12 Módulo transceptor óptico FEC multimodo

$550.00

OSFP-400G-SR4-FLT 400G OSFP SR4 Flat Top PAM4 850nm 30m en OM3/50m en OM4 MTP/MPO-12 Módulo transceptor óptico FEC multimodo

$550.00

-

OSFP-400G-DR4 400G OSFP DR4 PAM4 1310nm MTP/MPO-12 500m SMF FEC Módulo transceptor óptico

$800.00

OSFP-400G-DR4 400G OSFP DR4 PAM4 1310nm MTP/MPO-12 500m SMF FEC Módulo transceptor óptico

$800.00

-

OSFP-400G-SR8 400G SR8 OSFP PAM4 850nm MTP/MPO-16 100m OM3 MMF Módulo transceptor óptico FEC

$225.00

OSFP-400G-SR8 400G SR8 OSFP PAM4 850nm MTP/MPO-16 100m OM3 MMF Módulo transceptor óptico FEC

$225.00

-

Tarjeta adaptadora NVIDIA Mellanox MCX653105A-ECAT-SP ConnectX-6 InfiniBand/VPI, HDR100/EDR/100G, puerto único QSFP56, PCIe3.0/4.0 x16, soporte alto

$965.00

Tarjeta adaptadora NVIDIA Mellanox MCX653105A-ECAT-SP ConnectX-6 InfiniBand/VPI, HDR100/EDR/100G, puerto único QSFP56, PCIe3.0/4.0 x16, soporte alto

$965.00

-

Tarjeta de interfaz de red NVIDIA MCX623106AN-CDAT SmartNIC ConnectX®-6 Dx EN, puerto doble QSFP100 de 56 GbE, PCIe4.0 x 16, soporte alto y corto

$1200.00

Tarjeta de interfaz de red NVIDIA MCX623106AN-CDAT SmartNIC ConnectX®-6 Dx EN, puerto doble QSFP100 de 56 GbE, PCIe4.0 x 16, soporte alto y corto

$1200.00

-

Tarjeta adaptadora NVIDIA Mellanox MCX75510AAS-NEAT ConnectX-7 InfiniBand/VPI, NDR/400G, OSFP de puerto único, PCIe 5.0x 16, soporte alto

$1650.00

Tarjeta adaptadora NVIDIA Mellanox MCX75510AAS-NEAT ConnectX-7 InfiniBand/VPI, NDR/400G, OSFP de puerto único, PCIe 5.0x 16, soporte alto

$1650.00

-

Módulo transceptor óptico MTP/MPO-1 OM00 FEC compatible con NVIDIA MMA400Z400-NS112, 4 G, QSFP4, VR850, PAM50, 12 nm, 4 m

$550.00

Módulo transceptor óptico MTP/MPO-1 OM00 FEC compatible con NVIDIA MMA400Z400-NS112, 4 G, QSFP4, VR850, PAM50, 12 nm, 4 m

$550.00

-

NVIDIA MMA4Z00-NS400 Compatible 400G OSFP SR4 Flat Top PAM4 850nm 30m en OM3/50m en OM4 MTP/MPO-12 Módulo transceptor óptico FEC multimodo

$550.00

NVIDIA MMA4Z00-NS400 Compatible 400G OSFP SR4 Flat Top PAM4 850nm 30m en OM3/50m en OM4 MTP/MPO-12 Módulo transceptor óptico FEC multimodo

$550.00

-

NVIDIA MMS4X00-NS400 Compatible 400G OSFP DR4 Flat Top PAM4 1310nm MTP/MPO-12 500m SMF FEC Módulo transceptor óptico

$700.00

NVIDIA MMS4X00-NS400 Compatible 400G OSFP DR4 Flat Top PAM4 1310nm MTP/MPO-12 500m SMF FEC Módulo transceptor óptico

$700.00

-

QDD-OSFP-FLT-AEC2M Cable de cobre eléctrico activo PAM2 de parte superior plana 7G QSFP-DD de 400 m (4 pies) a OSFP

$1500.00

QDD-OSFP-FLT-AEC2M Cable de cobre eléctrico activo PAM2 de parte superior plana 7G QSFP-DD de 400 m (4 pies) a OSFP

$1500.00

-

OSFP-FLT-400G-PC2M Cable pasivo de conexión directa de 2 m (7 pies) 400G NDR OSFP a OSFP PAM4, parte superior plana en un extremo y parte superior plana en el otro

$125.00

OSFP-FLT-400G-PC2M Cable pasivo de conexión directa de 2 m (7 pies) 400G NDR OSFP a OSFP PAM4, parte superior plana en un extremo y parte superior plana en el otro

$125.00

-

OSFP-FLT-400G-PC3M Cable pasivo de conexión directa de 3 m (10 pies) 400G NDR OSFP a OSFP PAM4, parte superior plana en un extremo y parte superior plana en el otro

$135.00

OSFP-FLT-400G-PC3M Cable pasivo de conexión directa de 3 m (10 pies) 400G NDR OSFP a OSFP PAM4, parte superior plana en un extremo y parte superior plana en el otro

$135.00

-

NVIDIA MCA7J60-N004 Compatible 4m (13ft) 800G Twin-port OSFP a 2x400G OSFP InfiniBand NDR Breakout Cable de cobre activo

$800.00

NVIDIA MCA7J60-N004 Compatible 4m (13ft) 800G Twin-port OSFP a 2x400G OSFP InfiniBand NDR Breakout Cable de cobre activo

$800.00

-

NVIDIA MCP7Y00-N003-FLT Compatible 3 m (10 pies) 800G OSFP de doble puerto a 2x400G OSFP de parte superior plana InfiniBand NDR Breakout DAC

$260.00

NVIDIA MCP7Y00-N003-FLT Compatible 3 m (10 pies) 800G OSFP de doble puerto a 2x400G OSFP de parte superior plana InfiniBand NDR Breakout DAC

$260.00

-

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC Módulo transceptor óptico

$450.00

QSFP-DD-400G-SR4 QSFP-DD 400G SR4 PAM4 850nm 100m MTP/MPO-12 OM4 FEC Módulo transceptor óptico

$450.00

-

Compatible con NVIDIA MFP7E10-N010 10 m (33 pies) 8 fibras Baja pérdida de inserción Hembra a hembra Cable troncal MPO Polaridad B APC a APC LSZH multimodo OM3 50/125

$47.00

Compatible con NVIDIA MFP7E10-N010 10 m (33 pies) 8 fibras Baja pérdida de inserción Hembra a hembra Cable troncal MPO Polaridad B APC a APC LSZH multimodo OM3 50/125

$47.00