Obwohl OpenAI o1 das bestärkende Lernen (RL) vorschlug, konnte es den Kreis aus verschiedenen Gründen nicht durchbrechen. DeepSeek R1 löste das RL-Rätsel und führte die gesamte Branche in ein neues Paradigma, das wirklich in die zweite Hälfte der Intelligenz eintrat. Auf dem Markt wurde viel über die Definition von DeepSeek diskutiert. Die nächste wichtige Diskussion ist, wie man im KI-Rennen mitspielt.

Hat DeepSeek OpenAI überholt?

Es besteht kein Zweifel, dass DeepSeek Meta Llama überholt hat, aber es liegt immer noch weit hinter den Top-Playern wie OpenAI, Anthropic und Google. Beispielsweise kostet Gemini 2.0 Flash, leistungsstark und voll modal, weniger als DeepSeek. Die Außenwelt unterschätzt die Fähigkeiten der Top-Player, die durch Gemini 2.0 repräsentiert werden, das nicht Open Source ist, um einen sensationellen Effekt zu erzielen.

DeepSeek ist spannend, kann aber nicht als Innovation auf Paradigmenebene bezeichnet werden. Eine genauere Beschreibung ist, dass es das zuvor halb verborgene Paradigma von OpenAI o1 als Open Source freigegeben hat und das gesamte Ökosystem zu einer sehr hohen Durchdringungsrate geführt hat.

Aus der Perspektive der Grundprinzipien ist es schwierig, die Hersteller von Modellen der ersten Ebene unter der Architektur der Transformer-Generation zu übertreffen. Es ist auch schwierig, auf demselben Weg zu überholen. Heute freuen wir uns darauf, dass jemand die nächste Generation intelligenter Architektur und Paradigmen erforscht.

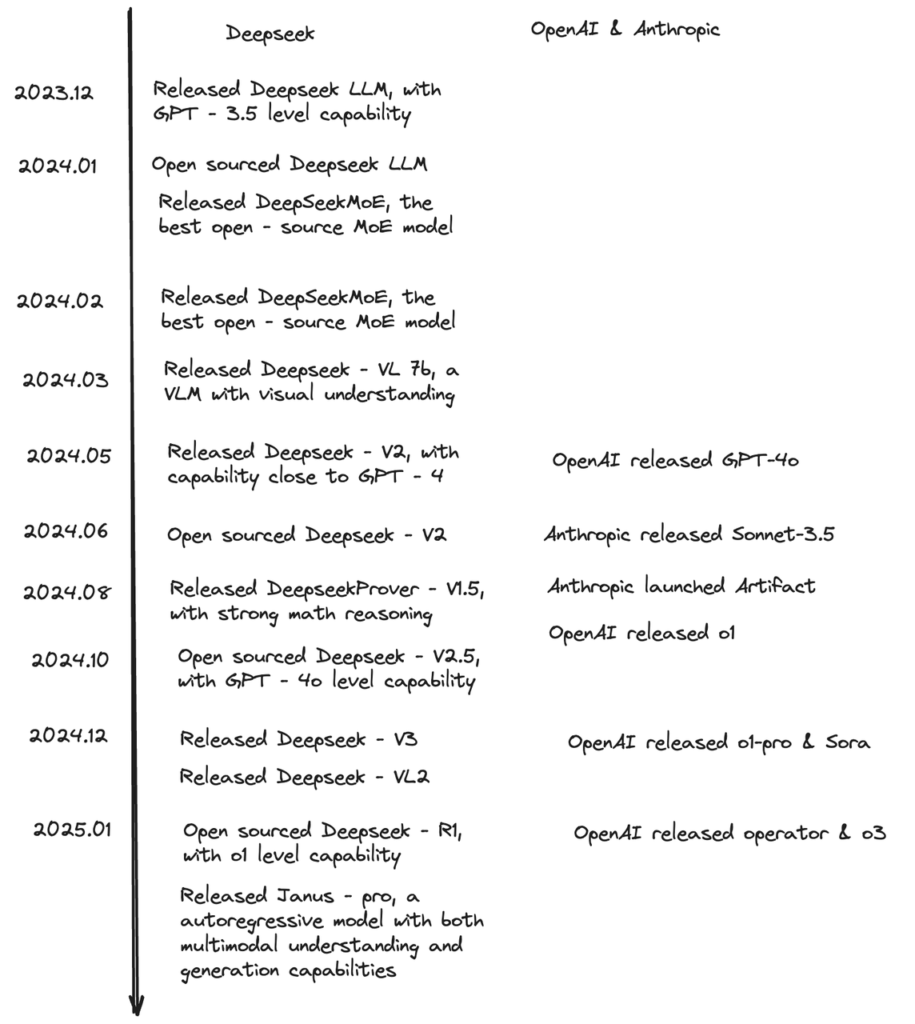

DeepSeek hat innerhalb eines Jahres OpenAI und Anthropic eingeholt

Öffnet DeepSeek ein neues Paradigma?

Wie bereits erwähnt hat DeepSeek streng genommen kein neues Paradigma erfunden.

Die Bedeutung von DeepSeek liegt jedoch darin, dem neuen Paradigma von RL und Testzeitberechnungen zu mehr Popularität zu verhelfen. Wenn OpenAIs erste Veröffentlichung von o1 der Branche ein Rätsel aufgab, war DeepSeek das erste, das es öffentlich löste.

Bevor DeepSeek R1 und R1-Zero herausbrachte, beschäftigten sich nur wenige Leute in der Branche mit RL und Schlussfolgerungsmodellen. DeepSeek lieferte jedoch einen Leitfaden für alle und weckte in der Branche die Überzeugung, dass dies die Intelligenz wirklich verbessern kann. Dies hat das Vertrauen enorm gestärkt und mehr KI-Forscher dazu bewegt, sich neuen Forschungsparadigmen zuzuwenden.

Nur durch den Einstieg talentierter Leute kann es zu Algorithmeninnovationen kommen, und nur durch die enge Verfolgung von Open Source können mehr Rechenressourcen investiert werden. Nach DeepSeek hat OpenAI, das ursprünglich keine neuen Modelle veröffentlichen wollte, nacheinander o3mini veröffentlicht und plant, weiterhin o3 zu veröffentlichen. Auch Open-Source-Modelle werden in Betracht gezogen. Anthropic und Google werden die RL-Forschung ebenfalls beschleunigen. Die Weiterentwicklung des neuen Paradigmas in der Branche wurde durch DeepSeek beschleunigt, und kleine und mittelgroße Teams können RL auch in verschiedenen Bereichen ausprobieren.

Darüber hinaus wird die Verbesserung des Argumentationsmodells die Implementierung des Agenten weiter erleichtern. KI-Forscher sind jetzt zuversichtlicher bei der Erforschung und Erforschung von Agenten. Daher kann man auch sagen, dass das Open-Source-Argumentationsmodell von DeepSeek die weitere Erforschung von Agenten durch die Branche gefördert hat.

Auch wenn DeepSeek also kein neues Paradigma erfunden hat, führte es doch die gesamte Branche in einen neuen Paradigmenwechsel.

Wie unterscheidet sich der Technologieansatz von Anthropic von dem von R1?

Aus Darios Interview können wir ersehen, dass Anthropics Verständnis des R-1/Argumentationsmodells etwas anders ist als das der O-Reihe. Dario ist der Ansicht, dass das Basismodell und das Argumentationsmodell ein kontinuierliches Spektrum sein sollten und nicht eine unabhängige Modellreihe wie OpenAI. Wenn Sie nur die O-Reihe machen, werden Sie bald an die Decke stoßen.

Ich habe mich immer gefragt, warum sich die Codierungs-, Argumentations- und Agentenfähigkeiten von Sonnet 3.5 plötzlich so stark verbessert haben, 4 aber nie aufholen konnte?

Sie haben in der Vortrainingsphase des Basismodells viel RL-Arbeit geleistet. Der Kern besteht darin, das Basismodell zu verbessern. Andernfalls kann es leicht alle Vorteile zunichte machen, wenn man sich ausschließlich auf RL verlässt, um das Argumentationsmodell zu verbessern.

Die Sensation, die DeepSeek auslöste, war unvermeidlich, aber auch zufällig

Aus technischer Sicht weist DeepSeek folgende Highlights auf:

- Open Source: Open Source ist sehr wichtig. Nachdem OpenAI mit GPT-3 zu einem Closed-Source-Unternehmen wurde, gaben die drei größten Unternehmen keine technischen Details mehr preis, sodass eine leere Open-Source-Nische entstand. Meta und Mistral konnten diese Position jedoch nicht einnehmen. Der Überraschungsangriff von DeepSeek sorgte diesmal für eine reibungslose Fahrt im Open-Source-Bereich.

Wenn wir 100 Punkte für Sensationsgier vergeben, gehen 30 Punkte an die Verbesserung der Intelligenz und 70 Punkte an Open Source. LLaMA war zuvor auch Open Source, hatte aber keinen so sensationellen Effekt, was zeigt, dass das Intelligenzniveau von LLaMa nicht ausreicht.

- Günstig: „Ihre Marge ist meine Chance“ wird immer wertvoller.

- Vernetzung + Öffentliches CoT : Diese beiden Punkte können den Benutzern eine gute Benutzererfahrung bieten. DeepSeek spielt beide Karten gleichzeitig aus, was man als Königsbombe bezeichnen kann. Die Erfahrung, die es C-End-Benutzern bietet, unterscheidet sich völlig von anderen Chatbots. Insbesondere die Transparenz von CoT macht den Modell-Denkprozess öffentlich. Transparenz kann das Vertrauen der Benutzer in die KI stärken und das Durchbrechen des Kreises fördern. Das Aufkommen von DeepSeek hätte jedoch enorme Auswirkungen auf Perplexity haben sollen, aber der DeepSeek-Server war instabil, und das Perplexity-Team reagierte schnell und startete R-1, was wiederum eine große Anzahl von DeepSeek R-1-Überlaufbenutzern übernahm.

- RL-Verallgemeinerung: Obwohl RL erstmals von OpenAI o1 vorgeschlagen wurde, ist seine Verbreitungsrate aufgrund verschiedener Operationen, die halb verborgen gehalten wurden, nicht hoch. DeepSeek R-1 hat den Fortschritt des Paradigmas des Schlussfolgerungsmodells erheblich gefördert und seine ökologische Akzeptanz erheblich verbessert.

Die Investitionen von DeepSeek in die technologische Erforschung sind ein entscheidender Faktor, der diese intelligente Errungenschaft mehr Aufmerksamkeit und Diskussion wert macht, aber der Zeitpunkt der Markteinführung von DeepSeek R1 lässt diese Sensation zufällig erscheinen:

In der Vergangenheit haben die USA immer behauptet, sie seien in der Grundlagenforschung weit vorne, aber DeepSeek ist in China beheimatet, was an sich schon ein Highlight ist. In diesem Prozess begannen viele amerikanische Technologiegiganten, das Argument vorzubringen, dass DeepSeek die Position der USA als technologischer Gigant in Frage stellt. DeepSeek beteiligte sich passiv am Meinungskrieg;

Vor der Veröffentlichung von DeepSeek R1 hatte das OpenAI Stargate-Ereignis gerade erst begonnen zu gären. Der Kontrast zwischen dieser riesigen Investition und der intelligenten Leistungsfähigkeit des DeepSeek-Teams war zu stark und es war schwer, keine Aufmerksamkeit und Diskussion zu erregen.

DeepSeek ließ den Aktienkurs von Nvidia abstürzen und provozierte die öffentliche Meinung weiter. Sie hatten sicherlich nicht damit gerechnet, dass sie 2025 der erste schwarze Schwan an der US-Börse werden würden.

Das Frühlingsfest ist ein Trainingsgelände für Produkte. Im Zeitalter des mobilen Internets sind während des Frühlingsfests viele Super-Apps wie Pilze aus dem Boden geschossen, und das KI-Zeitalter bildet da keine Ausnahme. DeepSeek R1 wurde kurz vor dem Frühlingsfest veröffentlicht. Was die Öffentlichkeit überraschte, war die Fähigkeit, Texte zu erstellen, und nicht die Programmier- und Mathematikkenntnisse, die während des Trainings betont wurden. Kulturelle Kreationen, die nachvollziehbarer sind, werden eher viral.

Wer wird geschädigt? Wer profitiert?

Die Akteure in diesem Bereich können in drei Kategorien unterteilt werden: ToC, To Developer und To Enterprise (to Government):

- Inhaltsverzeichnis: Chatbots sind definitiv am stärksten betroffen, da DeepSeek der Marke Aufmerksamkeit und Aufmerksamkeit entzieht, und ChatGPT bildet hier keine Ausnahme.

- Die Auswirkungen auf Entwickler sind sehr begrenzt. Wir haben gehört, dass einige Benutzer nach der Verwendung von R1 nicht so gut wie Sonnet sind. Cursor-Mitarbeiter sagten auch, dass Sonnet immer noch besser abschneidet. Daher entscheidet sich ein hoher Anteil der Benutzer für Sonnet und es gibt keine groß angelegte Migration.

- Das Geschäft von Unternehmen und Behörden basiert auf Vertrauen und Verständnis für die Bedürfnisse. Die Interessen großer Organisationen bei der Entscheidungsfindung sind sehr komplex und lassen sich nicht so einfach migrieren wie C-Endbenutzer.

Lassen Sie uns dies aus einer anderen Perspektive betrachten: Closed Source, Open Source und Rechenleistung:

Kurzfristig wird man denken, dass die Closed-Source-Systeme OpenAI/Anthropic/Google stärker betroffen sein werden:

- Das Geheimnis der Technologie wurde Open Source gegeben und der wichtigste Teil des Mysteriums im KI-Hype wurde gelüftet.

- Realistischer betrachtet geht der Markt davon aus, dass diesen Closed-Source-Unternehmen ein Teil ihrer potenziellen Kunden und Marktanteile weggenommen wurden und sich die Amortisationszeit von GPU-Investitionen verlängert hat.

- Als Marktführer leidet OpenAI am meisten. Sein bisheriger Traum, seine Technologie geheim zu halten und nicht der Öffentlichkeit zugänglich zu machen, in der Hoffnung, mehr Technologieprämien zu verdienen, wird sich wahrscheinlich nicht erfüllen.

Aber mittel- und langfristig werden Unternehmen mit reichlich GPU-Ressourcen trotzdem profitieren. Einerseits kann Meta, ein Unternehmen der zweiten Reihe, schnell neue Methoden entwickeln und so die Investitionskosten effizienter gestalten, sodass Meta ein großer Nutznießer sein könnte. Andererseits sind mehr Erkundungen erforderlich, um die Intelligenz zu verbessern. Die Open Source von DeepSeek hat alle auf das gleiche Niveau gebracht, und neue Erkundungen erfordern das Zehnfache oder sogar noch mehr GPU-Investitionen.

Von Grund auf bedeutet dies, dass die KI-Intelligenzbranche, egal ob sie Intelligenz entwickelt oder anwendet, aufgrund ihrer physikalischen Natur zwangsläufig enorme Rechenleistung verbraucht. Dies wird durch Grundgesetze bestimmt und lässt sich durch technische Optimierung nicht vollständig vermeiden.

Ob es sich also nun um die Erforschung oder Anwendung von Intelligenz handelt, selbst wenn kurzfristig Zweifel bestehen, wird die Nachfrage nach Rechenleistung mittel- und langfristig explodieren. Dies erklärt auch, warum Musk von den Grundprinzipien ausgeht und xAI darauf besteht, den Cluster zu erweitern. Die tiefe Logik hinter xAI und Stargate könnte dieselbe sein. Amazon und andere Cloud-Anbieter haben Pläne angekündigt, die Investitionsprognose zu erhöhen.

Nehmen wir an, dass das Talentniveau und das Bewusstsein für die KI-Forschung weltweit gleich sind. Werden uns dann mehr GPUs mehr experimentelle Untersuchungen ermöglichen? Am Ende könnte es wieder auf den Wettbewerb im Bereich der Computertechnik hinauslaufen.

DeepSeek hat keine kommerziellen Ansprüche und konzentriert sich auf die Erforschung intelligenter AGI-Technologie. Die Open-Source-Aktion ist von großer Bedeutung, um den Fortschritt von AGI zu fördern, den Wettbewerb zu intensivieren und Offenheit zu fördern, was in gewissem Maße einen Catfishing-Effekt hat.

Kann die Destillation SOTA übertreffen?

Es gibt ein Detail, das ungewiss ist. Wenn DeepSeek eine große Menge destillierter CoT-Daten aus der Vortrainingsphase verwendet hätte, wären die heutigen Ergebnisse nicht so erstaunlich, da es immer noch auf den grundlegenden Informationen basiert, die von den Giganten der ersten Reihe erhalten und dann als Open Source bereitgestellt wurden. Wenn die Vortrainingsphase jedoch keine große Menge destillierter Daten verwendet, wäre es erstaunlich, wenn DeepSeek die heutigen Ergebnisse durch Vortraining von Grund auf erzielen würde.

Darüber hinaus ist es unwahrscheinlich, dass die Destillation SOTA im Basismodell übertreffen kann. Aber DeepSeek R-1 ist sehr stark. Ich vermute, das liegt daran, dass das Belohnungsmodell sehr gute Arbeit leistet. Wenn der R-1 Zero-Pfad zuverlässig ist, hat er eine Chance, SOTA zu übertreffen.

Kein Burggraben!

Googles vorheriger Kommentar zu OpenAI: „No Moat!“ Auch dieser Satz ist hier angebracht.

Die große Migration von Chatbot-Benutzern hat dem Markt eine wichtige Inspiration gegeben: Der Fortschritt der intelligenten Technologie übersteigt die Vorstellungskraft der Menschen und es ist schwierig, dass stufenweise Produkte eine absolute Barriere bilden.

Ob ChatGPT/Sonnet/Perplexity, die gerade erst Aufmerksamkeit und Ansehen erlangt haben, oder Entwicklertools wie Cursor und Windsurf – sobald intelligentere Produkte verfügbar sind, sind die Benutzer der „vorherigen Generation“ intelligenter Produkte nicht mehr treu. Heute ist es schwierig, sowohl auf der Modellebene als auch auf der Anwendungsebene einen Schutzgraben zu errichten.

DeepSeek hat dieses Mal auch eines bestätigt: Das Modell ist die Anwendung. DeepSeek hat keine Innovation in Produktform. Der Kern ist Intelligenz + Open Source. Ich kann nicht anders als zu denken: Ist im KI-Zeitalter irgendeine Innovation bei Produkten und Geschäftsmodellen der Innovation der Intelligenz unterlegen?

Soll DeepSeek den Chatbot-Verkehr übernehmen und ausbauen?

Aus der Antwort des DeepSeek-Teams geht klar hervor, dass DeepSeek noch nicht herausgefunden hat, wie diese Verkehrswelle genutzt werden kann.

Der Kern der Frage, ob dieser Verkehr akzeptiert und aktiv gesteuert werden soll oder nicht, lautet: Können ein großes Handelsunternehmen und ein großes Forschungslabor in derselben Organisation koexistieren?

Diese Angelegenheit ist ein großartiger Test für Energie- und Ressourcenverteilung, organisatorische Fähigkeiten und strategische Entscheidungen. Wenn es sich um ein großes Unternehmen wie ByteDance oder Meta handeln würde, wäre ihre erste Reaktion, es zu übernehmen, und sie hätten eine gewisse organisatorische Grundlage dafür. Als Forschungslabor muss DeepSeek jedoch unter großem Druck stehen, dieses enorme Datenaufkommen zu bewältigen.

Gleichzeitig sollten wir aber auch darüber nachdenken, ob diese Chatbot-Welle nur vorübergehender Natur sein wird. Ist Chatbot Teil der Hauptlinie zukünftiger intelligenter Erforschung? Es scheint, dass jede Stufe der Intelligenz eine entsprechende Produktform hat und Chatbot nur eine der ersten freigeschalteten Formen ist.

Wäre es für DeepSeek aus der Perspektive der nächsten 3-5 Jahre ein Fehlschlag, wenn es heute nicht den Chatbot-Verkehr übernimmt? Was ist, wenn es eines Tages einen Skaleneffekt gibt? Wenn AGI schließlich realisiert wird, welcher Träger wird dafür verwendet?

Woher wird der nächste Aha-Moment eines KI-Durchbruchs kommen?

Einerseits ist das Modell der nächsten Generation der ersten Staffel kritisch, aber heute sind wir an der Grenze von Transformer angelangt, und es ist ungewiss, ob die erste Staffel ein Modell hervorbringen kann, das eine Generationsverbesserung erreichen kann. OpenAI, Anthropic und Google reagierten darauf, indem sie Modelle herausbrachten, die 30-50 % besser sind, aber das reicht möglicherweise nicht aus, um die Situation zu retten, da der Gegner über 10-30 Mal mehr Ressourcen verfügt.

Andererseits ist die Implementierung von Agent kritisch, da Agent weitreichende mehrstufige Schlussfolgerungen vornehmen muss. Wenn das Modell 5-10 % besser ist, wird der führende Effekt um ein Vielfaches verstärkt. Daher müssen OpenAI, Anthropic und Google einerseits Agent-Produkte vor Ort implementieren, also ein vollständig integriertes Modell + Agent-Produkte, genau wie Windows + Office. Andererseits müssen sie auch leistungsfähigere Modelle zeigen, wie die Modelle der nächsten Generation, die durch die Vollversion von O3 und Sonnet 4/3.5 opus repräsentiert werden.

Inmitten technologischer Unsicherheit sind talentierte KI-Forscher am wertvollsten. Jede Organisation, die AGI erforschen möchte, muss Ressourcen in eine radikalere Wette auf das nächste Paradigma investieren, insbesondere im heutigen Kontext, in dem Modelle im Vortrainingsstadium den Gleichgewichtszustand erreicht haben. Es sind gute Talente und ausreichende Ressourcen erforderlich, um den nächsten Aha-Moment der aufkommenden Intelligenz zu erforschen.

Abschließend hoffe ich, dass die Technologie keine Grenzen kennt.