تركز معظم الاهتمام في Computex على DGX GH200 و MGX الجديدتين من NVIDIA - وكلاهما من منتجات NVIDIA AI على مستوى النظام ، بغض النظر عما إذا كانت تصميمات مرجعية أو خوادم كاملة. لطالما كانت تلك الرقائق واللوحات والأنظمة المتعلقة بوحدات المعالجة المركزية ووحدات معالجة الرسومات موضوعات ساخنة لـ NVIDIA ، حيث أن AI و HPC تحظى بشعبية كبيرة.

ولكن في الواقع ، في سياق AI HPC ، وخاصة الذكاء الاصطناعي التوليدي ، أو ما يسميه كثير من الناس الآن الحوسبة "النموذج الكبير" ، والشبكات مهمة جدًا أيضًا. بمعنى آخر ، يتطلب الأمر عددًا كبيرًا من الخوادم للعمل معًا لحل المشكلات ، وهناك حاجة إلى مجموعة كبيرة الحجم لتوسيع قوة الحوسبة عبر الأنظمة والعقد. لذلك ، لا تتعلق مشكلات الأداء فقط بقوة الحوسبة لوحدات المعالجة المركزية ووحدات معالجة الرسومات وشرائح الذكاء الاصطناعي داخل العقدة.

في السابق ، ذكرت Google أنه في البنية التحتية الشاملة للذكاء الاصطناعي ، فإن أهمية البنية على مستوى النظام أعلى حتى من أهمية البنية الدقيقة لشريحة TPU. بالطبع ، قد لا يغطي "مستوى النظام" هذا بالضرورة الشبكات عبر العقد ، ولكن من الواضح أنه عندما تعمل مجموعة من الشرائح معًا لإجراء العمليات الحسابية ، يصبح النظام والشبكة معوقات في الأداء.

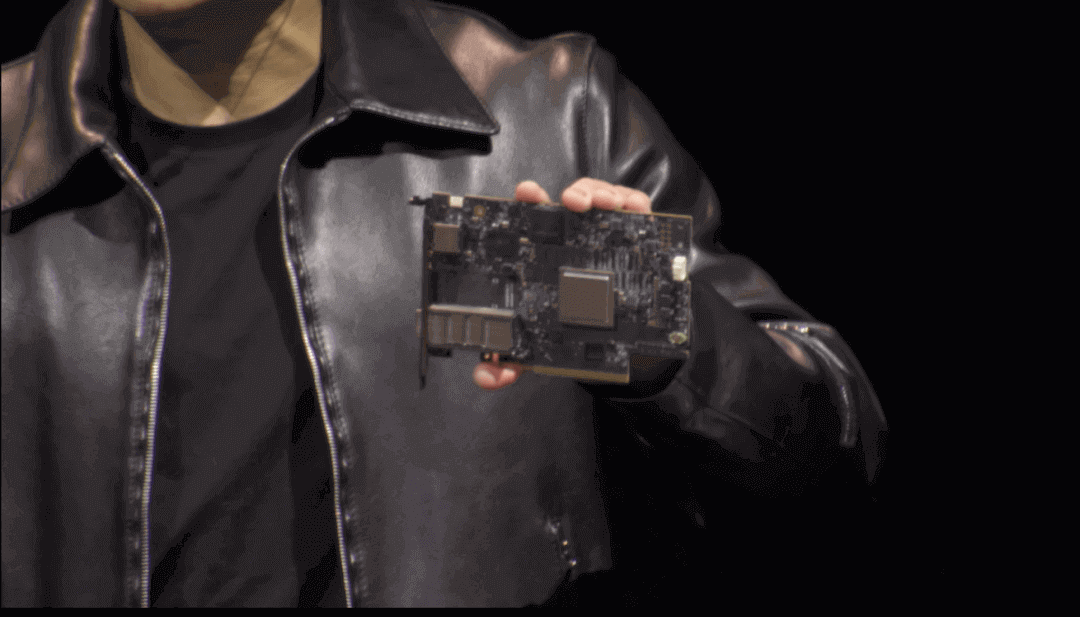

هذا هو سبب أهمية DPU - بدلاً من كونها طريقة ذاتية للبيع أو التنافس مع المنتجات الموجودة في السوق. إن NVIDIA's DPU ومنتجات الشبكات الأخرى تشبه إلى حد كبير المكملات القصيرة لمنتجاتها الخاصة ، ولا تحب بشكل شخصي التنافس مع الآخرين أو التنافس مع المنتجات الموجودة في السوق. من هذا المنظور ، تشكل منتجات أجهزة NVIDIA نظامًا بيئيًا كاملًا أفقيًا: على سبيل المثال ، لا يُقصد بوحدة DPU بشكل شخصي التنافس مع أي شخص ولكنها جزء واحد من منتجاتها الحالية.

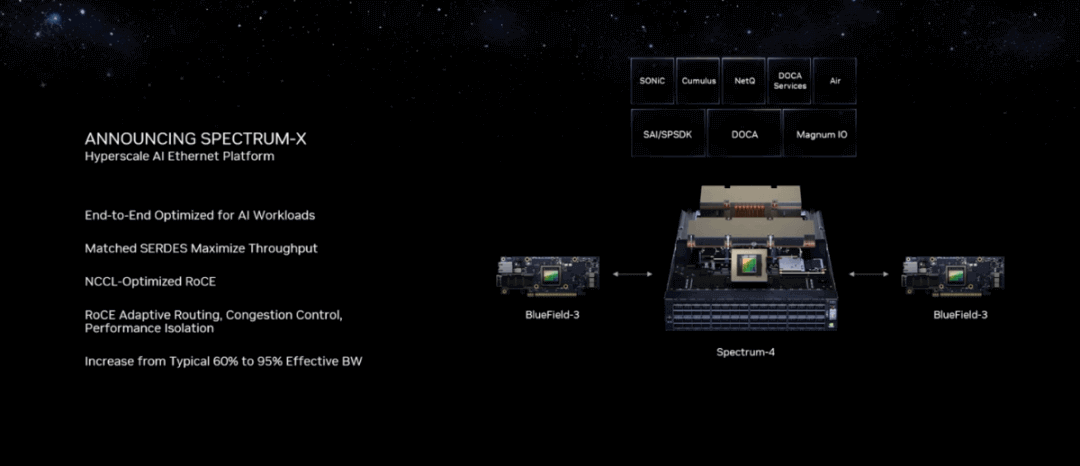

في Computex ، أعلنت NVIDIA عن منتجات الشبكات التي تتمحور حول منصة Spectrum-X Ethernet الخاصة بها. تدعي NVIDIA أن هذا هو أول منتج Ethernet عالي الأداء في العالم مصمم خصيصًا للذكاء الاصطناعي ، خاصةً "لأعباء عمل الذكاء الاصطناعي التي تتطلب نوعًا جديدًا من الإيثرنت." لم نتحدث كثيرًا عن منتجات شبكات NVIDIA في الماضي ، بما في ذلك وحدة معالجة البيانات (DPU). مع تقديم Spectrum-X ، تحاول هذه المقالة مناقشة منتج Ethernet هذا بالإضافة إلى المنطق الكامن وراء منتجات شبكات NVIDIA.

لماذا تريد NVIDIA إنشاء "سويتش"؟

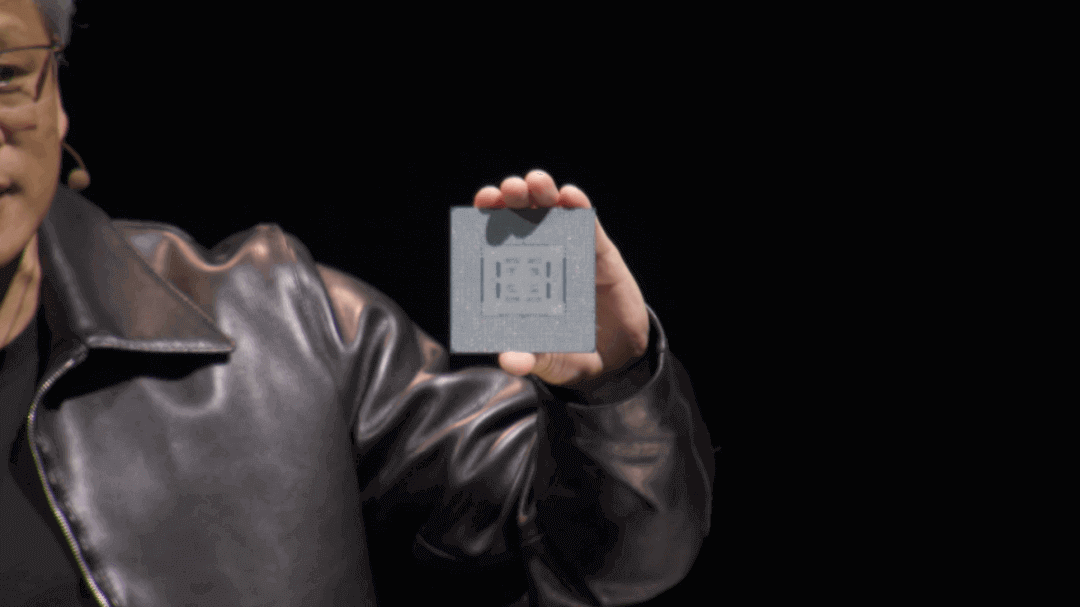

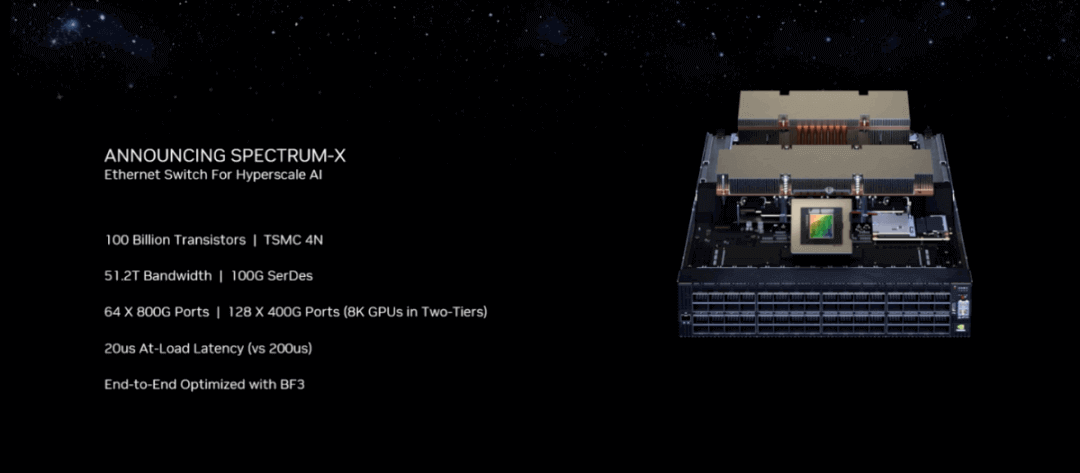

المكونان الأساسيان داخل منصة Spectrum-X هما Spectrum-4 Ethernet Switch و BlueField-3 DPU. لم يتم شرح الجزء المتعلق بوحدة DPU كثيرًا ؛ الجزء الآخر من التبديل المرتبط بالطيف ، أصدرت NVIDIA العام الماضي مفتاح Spectrum-4 بسرعة 400 جيجابت في الثانية. يعتمد مستوى الرقاقة على Spectrum ASIC - أظهر Huang Renxun الشريحة في Computex Keynote ، وهو رجل كبير يضم 100 مليار ترانزستور ، و 90 × 90 مم ، و 800 كرة لحام في الجزء السفلي من حزمة الرقاقة ، واستهلاك طاقة 500 واط.

الإعلان عن "أول بنية إيثرنت عالية الأداء" تم تصميمها خصيصًا للذكاء الاصطناعي ، نظام Spectrum-4 Ethernet Switch ، متاح الآن لمزودي خدمات CSP.

كما هو موضح في الشكل ، يضم النظام إجمالي 128 منفذًا بسعة عرض نطاق تبلغ 51.2 تيرابايت / ثانية ، وهو ضعف ما تتمتع به محولات إيثرنت التقليدية. وفقًا للشركة ، ستمكّن هذه التقنية الجديدة مهندسي الشبكات وعلماء بيانات الذكاء الاصطناعي ومقدمي الخدمات السحابية من تحقيق النتائج واتخاذ القرارات بمعدل أسرع ، مع تمكين السحب التوليدية للذكاء الاصطناعي. يعد النطاق الترددي العالي وزمن الاستجابة المنخفض ضروريين للتخفيف من اختناقات الأداء أثناء توسيع وحدة معالجة الرسومات عبر العقد. يستهلك المفتاح بالكامل 2800 واط من الطاقة.

في GTC العام الماضي ، أوضحت NVIDIA أن المحول لم يكن يهدف إلى التنافس مع مفاتيح الشبكة التقليدية في التعامل مع حركة مرور "تدفق الماوس" الروتينية ، ولكنه يركز بدلاً من ذلك على معالجة حركة مرور "تدفق الفيل" ، والاستفادة من منتجات الأجهزة للذكاء الاصطناعي على نطاق واسع ، والرقمي. التوائم وتطبيقات المحاكاة.

"المفاتيح التقليدية بطيئة جدًا في التعامل مع أعباء العمل التوليدية الحالية للذكاء الاصطناعي. علاوة على ذلك ، ما زلنا في بداية ثورة الذكاء الاصطناعي. قال جلعاد شاينر ، نائب الرئيس الأول للشبكات في NVIDIA خلال كلمته الرئيسية ، إن المفاتيح التقليدية قد تكفي لسحب السلع ، لكنها لا تستطيع توفير الأداء المطلوب لأحمال السحابة من الذكاء الاصطناعي التي تتضمن الذكاء الاصطناعي التوليدي.

خلال الإحاطة المسبقة ، سأل أحد المراسلين على وجه التحديد ما إذا كانت NVIDIA Spectrum تتنافس مباشرة مع المفاتيح من Arista وغيرها من الشركات. كان رد شاينر أنه لا توجد منافسة: "تُستخدم محولات إيثرنت الأخرى في السوق لبناء سحابات عادية للسلع ، أو حركة مرور بين الشمال والجنوب تتضمن وصول المستخدم والتحكم في السحابة. ومع ذلك ، لا يوجد حاليًا حل في السوق يمكنه تلبية متطلبات الذكاء الاصطناعي التوليدي لشبكة إيثرنت. كأول شبكة إيثرنت في العالم لحركة المرور بين الشرق والغرب في مجال الذكاء الاصطناعي التوليدي ، ابتكرت Spectrum-4 حل Ethernet جديدًا يستهدف هذا الهدف على وجه التحديد ". كما ذكر شاينر خلال الإحاطة أن منتجات التحويل الحالية من Broadcom لا تنافس Spectrum-4. تؤكد NVIDIA على أن Spectrum-X تنشئ شبكة إيثرنت غير ضائعة ، والتي قد تكون مهمة بشكل خاص في شرح منصة Spectrum-X.

InfiniBand مقابل إيثرنت

لقد تطورت شبكة إيثرنت بمرور الوقت. يعتبر "بدون فقدان" أمرًا محددًا نظرًا لأن Ethernet تم تصميمه في الأصل لبيئات الشبكة التي بها ضياع. بمعنى آخر ، يُسمح بفقدان الحزم على هذه الشبكة. لضمان الموثوقية ، تتطلب الطبقة العليا من شبكة IP بروتوكول TCP. بمعنى ، إذا حدث فقدان الحزمة أثناء إرسال الحزمة ، فإن بروتوكول TCP يمكّن المرسل من إعادة إرسال الحزم المفقودة. ومع ذلك ، نظرًا لآليات تصحيح الأخطاء هذه ، يزداد زمن الوصول ، مما قد يتسبب في حدوث مشكلات لأنواع معينة من التطبيقات. بالإضافة إلى ذلك ، من أجل التعامل مع ارتفاعات حركة المرور المفاجئة في الشبكة ، تحتاج المحولات إلى تخصيص موارد ذاكرة تخزين مؤقت إضافية لتخزين المعلومات مؤقتًا ، وهذا هو السبب في أن رقائق تبديل Ethernet أكبر وأكثر تكلفة من رقائق InfiniBand ذات المواصفات المماثلة.

ومع ذلك ، "الشبكات المفقودة غير مقبولة لمراكز بيانات الحوسبة عالية الأداء (HPC)." صرح Huang Renxun ، "التكلفة الكاملة لتشغيل عبء عمل HPC عالية جدًا ، وأي خسارة في الشبكة يصعب تحملها." علاوة على ذلك ، نظرًا لمتطلبات مثل عزل الأداء ، يصعب بالفعل تحمل الشبكات المفقودة. تستخدم NVIDIA معيار اتصال شبكة يسمى InfiniBand. يتم استخدام InfiniBand بشكل شائع في تطبيقات HPC التي تتطلب إنتاجية عالية وزمن انتقال منخفض. على عكس Ethernet ، وهو أكثر عالمية ، يعد InfiniBand أكثر ملاءمة للتطبيقات كثيفة البيانات.

InfiniBand ليست حصرية لـ NVIDIA. تم تطويره في الأصل من قبل عدد من الشركات ، بما في ذلك Intel و IBM و Microsoft ، من بين آخرين ، وكان هناك تحالف متخصص يسمى IBTA. بدأ Mellanox في الترويج لمنتجات InfiniBand في حوالي عام 2000. وفقًا لمقدمة Wikipedia ، كان الهدف الأولي لـ InfiniBand هو استبدال PCI في I / O و Ethernet في غرف أجهزة ومجموعات مترابطة.

لسوء الحظ ، تم تطوير InfiniBand خلال فترة انفجار فقاعة dot-com ، وتم قمع تطورها. كان لدى المشاركين مثل Intel و Microsoft خيارات جديدة. ومع ذلك ، وفقًا لقائمة أفضل 500 من أجهزة الكمبيوتر العملاقة في عام 2009 ، كان هناك بالفعل 181 اتصالًا داخليًا يعتمد على بتقنية InfiniBand (كان الباقي إيثرنت) ، وبحلول عام 2014 ، كان أكثر من نصفهم يستخدمون InfiniBand ، على الرغم من أن 10 جيجابت إيثرنت سرعان ما اشتعلت في العامين التاليين. عندما استحوذت NVIDIA على Mellanox في عام 2019 ، أصبحت Mellanox بالفعل المورد الرئيسي لمنتجات اتصالات InfiniBand في السوق.

من منظور التصميم ، كان Ethernet ، الذي ولد في الثمانينيات ، مهتمًا فقط بتحقيق إمكانية التشغيل البيني للمعلومات بين الأنظمة المتعددة. في المقابل ، تم إنشاء InfiniBand للتخلص من عنق الزجاجة في نقل البيانات العنقودية في سيناريوهات HPC ، على سبيل المثال من حيث زمن الوصول ، وتصميم معالجة التحويل من الطبقة الثانية مباشر تمامًا ، والذي يمكن أن يقلل بشكل كبير من زمن انتقال إعادة التوجيه. لذلك ، فهي مناسبة بشكل طبيعي لـ HPC ، ومراكز البيانات ، ومجموعات الحواسيب العملاقة: الإنتاجية العالية ، والكمون المنخفض ، والموثوقية العالية.

من وجهة نظر الموثوقية ، فإن InfiniBand نفسها لديها تعريف بروتوكول كامل لطبقات الشبكة 1-4: فهي تمنع فقدان الحزمة من خلال آليات التحكم في التدفق من طرف إلى طرف ، والتي في حد ذاتها تحقق خاصية بلا خسارة. يتمثل الاختلاف الرئيسي الآخر بين الاثنين في أن InfiniBand يعتمد على تصميم شبكة نسيجية مبدلة ، بينما يعتمد Ethernet على قناة مشتركة متوسطة مشتركة. من الناحية النظرية ، يكون الأول أكثر قدرة على تجنب مشاكل تعارض الشبكة.

نظرًا لأن InfiniBand جيد جدًا ، فلماذا تريد Nvidia تطوير Ethernet؟ بالتفكير من الحدس ، يجب أن تكون قاعدة سوق Ethernet وتعدد الاستخدامات والمرونة عوامل مهمة. في كلمته الرئيسية ، تحدث هوانغ عن كيف "نريد أن نجلب الذكاء الاصطناعي التوليدي إلى كل مركز بيانات" ، الأمر الذي يتطلب التوافق مع المستقبل. "تقوم العديد من الشركات بنشر Ethernet ،" و "الحصول على إمكانية InfiniBand أمر صعب بالنسبة لهم ، لذلك نحن نقدم هذه الإمكانية إلى سوق Ethernet. هذا هو منطق العمل وراء طرح Spectrum-4. لكننا نعتقد أن هذه بالتأكيد ليست القصة الكاملة.

تعمل NVIDIA على كل من منتجات Ethernet وInfiniBand، حيث تُعرف الأولى باسم منصة Spectrum Ethernet وتُسمى الثانية Quantum InfiniBand. إذا نظرت إلى الصفحة الرسمية، فستجد أن حلول InfiniBand "تقدم أداءً لا مثيل له بتكلفة أقل وتعقيد أعلى من البنية التحتية للحوسبة عالية الأداء والذكاء الاصطناعي والسحابة الفائقة"؛ بينما تعمل Spectrum على تسريع تحويل Ethernet للذكاء الاصطناعي والسحابة. من الواضح أن الاثنين يتنافسان إلى حد ما.

لماذا إيثرنت؟

في كلمته الرئيسية ، شرح Huang علميًا الأنواع المختلفة من مراكز البيانات - في الواقع ، في GTC العام الماضي ، قسمت NVIDIA بشكل واضح مراكز البيانات إلى ست فئات. وفي سيناريو الذكاء الاصطناعي الذي نناقشه اليوم ، يمكن تقسيم مراكز البيانات إلى فئتين رئيسيتين. فئة واحدة هي التي يجب أن تكون مسؤولة عن مجموعة كاملة من أحمال التطبيقات المختلفة ، حيث قد يكون هناك العديد من المستأجرين والاعتمادات الضعيفة بين الأحمال.

ولكن هناك فئة أخرى عادةً مثل الحوسبة الفائقة أو الحوسبة الفائقة التي تحظى بشعبية الآن ، والتي تحتوي على عدد قليل جدًا من المستأجرين (عدد قليل جدًا يصل إلى معدن واحد) وأحمال مقترنة بإحكام - تتطلب إنتاجية عالية لمشاكل حسابية كبيرة. الاختلاف في البنية التحتية المطلوبة من قبل هذين النوعين من مراكز البيانات كبير. انطلاقًا من الحدس ، لن تكون البيئة الأكثر بدائية للضياع في Ethernet مناسبة للمتطلبات الأخيرة. تم تناول أسباب ذلك بالفعل في المقالة السابقة.

كتب SemiAnalysis مؤخرًا مقالًا تحدث بشكل خاص عن المشكلات العديدة مع InfiniBand - تقنية بشكل أساسي ، والتي يمكن استخدامها كمرجع لـ NVIDIA لتطوير Ethernet في نفس الوقت. يتم استخراج بعضها هنا كمرجع. في الواقع ، تتطور كل من InfiniBand و Ethernet نفسها باستمرار.

يستخدم التحكم في التدفق في InfiniBand آلية تحكم في التدفق قائمة على الائتمان. يتم تخصيص كل ارتباط مسبقًا ببعض الاعتمادات المحددة - مما يعكس سمات مثل النطاق الترددي للارتباط. عند استلام الحزمة ومعالجتها ، يقوم الطرف المستلم بإرجاع رصيد إلى الطرف المرسل. من الناحية المثالية ، سيضمن مثل هذا النظام عدم تحميل الشبكة بشكل زائد ، حيث سيحتاج المرسل إلى انتظار عودة الاعتمادات قبل إرسال المزيد من الحزم.

لكن هناك مشاكل مع مثل هذه الآلية. على سبيل المثال ، إذا كانت عقدة الإرسال ترسل البيانات إلى عقدة استقبال بمعدل أسرع من قدرة العقدة المستقبلة على معالجة البيانات ، فقد يمتلئ المخزن المؤقت للعقدة المستقبلة. لا تستطيع العقدة المستقبلة إعادة الاعتمادات إلى عقدة الإرسال ، ونتيجة لذلك ، لا يمكن لعقدة الإرسال إرسال المزيد من حزم البيانات بسبب نفاد الاعتمادات. إذا لم تتمكن العقدة المستقبلة من إرجاع الاعتمادات وكانت عقدة الإرسال أيضًا عقدة استقبال للعقد الأخرى ، فإن عدم القدرة على إرجاع الاعتمادات في حالة الحمل الزائد للنطاق الترددي يمكن أن يؤدي إلى انتشار الضغط إلى منطقة أكبر. وتشمل المشاكل الأخرى المآزق ومعدلات الخطأ التي تسببها المكونات المختلفة.

تصبح بعض المشكلات المتأصلة في InfiniBand أكثر خطورة مع زيادة حجم النظام وتعقيده. حاليًا ، من المحتمل أن يكون أكبر حل InfiniBand يتم تنفيذه تجاريًا من Meta ، حيث نشرت مجموعة بحثية ما مجموعه 16,000 بطاقة NIC و 16,000 وحدة معالجة رسومات A100.

هذا المقياس ضخم بلا شك ، لكن SemiAnalysis ينص على أن تدريب GPT-4 سيتطلب نطاقًا أكبر ، ومن المحتمل أن تتطلب تطورات "النموذج الكبير" في المستقبل توسيع الكتلة. من الناحية النظرية ، يمكن أن تستمر InfiniBand في توسيع قدرتها الإجمالية ، لكنها ستعاني بشكل متزايد من تأثيرات المشكلات الكامنة. من منظور الاستدلال ، لا يزال بإمكان وقت الاستجابة والأداء الاستفادة من InfiniBand ، ولكن بالنسبة لأحمال الاستدلال ، سيتم إرسال الطلبات المختلفة بسرعات مختلفة بشكل مستمر. علاوة على ذلك ، ستتطلب البنى المستقبلية عدة نماذج كبيرة يتم تضمينها في أحجام دفعات مختلفة داخل نفس المجموعة الكبيرة الحجم ، الأمر الذي يتطلب تغييرات مستمرة للتحكم في التدفق على أساس الائتمان.

من الصعب الاستجابة بسرعة لآلية التحكم في تدفق الائتمان لتغيرات بيئة الشبكة. إذا كان هناك قدر كبير من حركة المرور المتنوعة داخل الشبكة ، يمكن أن تتغير حالة المخزن المؤقت للعقدة المستقبلة بسرعة. إذا أصبحت الشبكة مزدحمة ، فإن عقدة الإرسال لا تزال تعالج معلومات الائتمان السابقة ، مما يجعل المشكلة أكثر تعقيدًا. علاوة على ذلك ، إذا كانت عقدة الإرسال تنتظر باستمرار الائتمانات والتبديل بين حالتين من نقل البيانات ، فيمكن أن تتسبب بسهولة في تقلبات في الأداء.

من الناحية العملية ، يحقق Quantum-2 الحالي من NVIDIA عرض نطاق ترددي يبلغ 25.6 تيرابايت / ثانية ، وهو على الأقل من الناحية العددية ، أقل من 4 تيرابايت / ثانية في Spectrum-51.2. لن تكون رقائق الكم والبنية التحتية الأسرع متاحة حتى العام المقبل ، مما يخلق وتيرة مختلفة. بالإضافة إلى ذلك ، من منظور التكلفة ، يتطلب تحقيق نفس المقياس (8000+ وحدة معالجة رسومات) للنشر التقليدي لوحدة معالجة الرسومات طبقة إضافية من التبديل والكابلات أكثر بكثير (الكابلات الضوئية عالية التكلفة). لذلك ، فإن تكلفة نشر شبكة InfiniBand على نطاق نموذجي أعلى بكثير من Ethernet. (DPU و NIC لا يتم اعتبار التكاليف هنا.)

من وجهة نظر العميل ، فإن سوق Ethernet أكبر بكثير من InfiniBand ، مما يساعد أيضًا في تقليل تكاليف النشر. هناك عوامل أخرى محددة قابلة للمقارنة ، مثل أنظمة الواجهة الأمامية للخدمة التقليدية القائمة على Ethernet ومشكلة ربط المورد مع InfiniBand للعملاء. من الواضح أن Ethernet توفر المزيد من الخيارات ، وقد تكون مرونة نشرها وقابليتها للتوسع أفضل أيضًا. على المستوى التقني ، يبدو أن هناك قيمة محتملة في عمليات النشر المستقبلية للبنية التحتية للإرسال البصري لشبكة إيثرنت.

قد تكون هذه هي الأساس النظري لتركيز NVIDIA على Ethernet أو جزءًا من سبب اختيار NVIDIA لشبكة Ethernet لسحب AI التوليدية. ومع ذلك ، فإن أحد الأسباب التي يجب أخذها كمرجع فقط هو أن InfiniBand قد تطورت بشكل كبير بواسطة NVIDIA ، والعديد من المشكلات المتأصلة لها حلول.

أخيرًا ، لنتحدث عن السؤال المذكور في البداية ، وهو أن Ethernet كانت في الأصل شبكة ضائعة. ولكن في الواقع ، مع تطوير تقنيات مثل RoCE (RDMA عبر الإيثرنت المتقاربة) ، تم أيضًا جلب بعض مزايا InfiniBand إلى Ethernet. في الواقع ، فإن التوسع التكنولوجي هو إلى حد ما تكامل مزايا التقنيات المختلفة ، بما في ذلك الأداء العالي لـ InfiniBand وعدم فقدانه ، وعالمية Ethernet ، وفعالية التكلفة ، والمرونة ، إلخ.

تحقق RoCE المذكورة في ميزات النظام الأساسي Spectrum-X ضياع على شبكات Ethernet من خلال الاعتماد على التحكم في التدفق المستند إلى الأولوية (PFC) في NIC من جانب نقطة النهاية ، بدلاً من تبديل الأجهزة. بالإضافة إلى ذلك ، تحتوي RoCE ++ على بعض الامتدادات المحسّنة الجديدة ، مثل ASCK ، التي تتعامل مع مشكلات فقدان الحزم وأمر الوصول ، مما يسمح للطرف المستلم بإخطار الطرف المرسل لإعادة إرسال الحزم المفقودة أو التالفة فقط ، وتحقيق استخدام أعلى للنطاق الترددي ؛ هناك أيضًا ECN وآلية التحكم في التدفق وتحسين الأخطاء ، وكلها تساهم في تحسين الكفاءة والموثوقية. بالإضافة إلى ذلك ، للتخفيف من مشاكل قابلية التوسع في بطاقات NIC الخاصة بنقطة النهاية على Ethernet القياسية مع شبكات RoCE ، يمكن استخدام وضع Bluefield NIC ، ولا يزال من الممكن تخفيف التكلفة الإجمالية لـ DPU بواسطة Ethernet وبعض التقنيات الجديدة.

في خطابه الرئيسي ، ذكر Huang Renxun تحديدًا Spectrum-X ، والذي يجلب بشكل أساسي خاصيتين مهمتين إلى Ethernet: التوجيه التكيفي والتحكم في الازدحام. بالإضافة إلى ذلك ، تعاونت NVIDIA سابقًا مع IDC لإصدار تقرير مستند تقني حول القيمة التجارية لحلول تبديل Ethernet.

في تطبيقات الذكاء الاصطناعي واسعة النطاق ، ربما يكون الإيثرنت خيارًا لا مفر منه في المستقبل. لذلك ، في الترويج لـ Spectrum-X ، تم إعداد موقع NVIDIA خصيصًا لسحب الذكاء الاصطناعي التوليدية ، وهو الحل "الأول" لحركة المرور بين الشرق والغرب للذكاء الاصطناعي التوليدي. ومع ذلك ، قد تكون هناك أسباب أكثر من عالمية Ethernet القوية. تحت أحمال AI HPC ، هناك احتمال معين لإمكانية التحول الشامل إلى إيثرنت.

إن تطوير معايير مختلفة هو في حد ذاته عملية فحص واستكمال أوجه القصور لدى كل طرف ، واستيعاب الجوهر. تمامًا مثل InfiniBand ، هناك العديد من حلول التخفيف لحل العيوب المتأصلة ، كما أن بعض السمات الموسعة لـ InfiniBand مفيدة جدًا لتطبيقه في الذكاء الاصطناعي. هذه مشكلة مقارنة بين الاختيار وتطوير التكنولوجيا. يمكننا الانتظار ومعرفة ما إذا كانت NVIDIA ستميل نحو تطوير InfiniBand أو Ethernet في المستقبل ، حتى لو كان لهذين سيناريوهات التطبيق الخاصة بهما.

المنتجات ذات الصلة:

-

وحدة الإرسال والاستقبال Mellanox MMA1B00-E100 100G InfiniBand EDR QSFP28 SR4 850nm 100m MTP / MPO MMF DDM

$40.00

وحدة الإرسال والاستقبال Mellanox MMA1B00-E100 100G InfiniBand EDR QSFP28 SR4 850nm 100m MTP / MPO MMF DDM

$40.00

-

Mellanox MMA1T00-HS متوافق 200G Infiniband HDR QSFP56 SR4 850nm 100m MPO-12 APC OM3/OM4 FEC PAM4 وحدة الإرسال والاستقبال الضوئية

$139.00

Mellanox MMA1T00-HS متوافق 200G Infiniband HDR QSFP56 SR4 850nm 100m MPO-12 APC OM3/OM4 FEC PAM4 وحدة الإرسال والاستقبال الضوئية

$139.00

-

NVIDIA MMA4Z00-NS400 متوافق مع 400G OSFP SR4 مسطح علوي PAM4 850 نانومتر 30 متر على OM3 / 50m على وحدة الإرسال والاستقبال البصرية OM4 MTP / MPO-12 Multimode FEC

$550.00

NVIDIA MMA4Z00-NS400 متوافق مع 400G OSFP SR4 مسطح علوي PAM4 850 نانومتر 30 متر على OM3 / 50m على وحدة الإرسال والاستقبال البصرية OM4 MTP / MPO-12 Multimode FEC

$550.00

-

NVIDIA MMA4Z00-NS-FLT متوافق مع 800Gb / s ثنائي المنفذ OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 MMF وحدة الإرسال والاستقبال البصرية

$650.00

NVIDIA MMA4Z00-NS-FLT متوافق مع 800Gb / s ثنائي المنفذ OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 MMF وحدة الإرسال والاستقبال البصرية

$650.00

-

NVIDIA MMA4Z00-NS متوافق مع 800Gb / s ثنائي المنافذ OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 MMF وحدة الإرسال والاستقبال الضوئية

$650.00

NVIDIA MMA4Z00-NS متوافق مع 800Gb / s ثنائي المنافذ OSFP 2x400G SR8 PAM4 850nm 100m DOM Dual MPO-12 MMF وحدة الإرسال والاستقبال الضوئية

$650.00

-

NVIDIA MMS4X00-NM متوافق مع 800Gb / s ثنائي المنفذ OSFP 2x400G PAM4 1310nm 500m DOM Dual MTP / MPO-12 SMF وحدة الإرسال والاستقبال البصرية

$900.00

NVIDIA MMS4X00-NM متوافق مع 800Gb / s ثنائي المنفذ OSFP 2x400G PAM4 1310nm 500m DOM Dual MTP / MPO-12 SMF وحدة الإرسال والاستقبال البصرية

$900.00

-

كابل بصري نشط Mellanox MFS1S00-H010E بطول 10 متر (33 قدمًا) 200 جرام HDR QSFP56 إلى QSFP56 كابل بصري نشط

$365.00

كابل بصري نشط Mellanox MFS1S00-H010E بطول 10 متر (33 قدمًا) 200 جرام HDR QSFP56 إلى QSFP56 كابل بصري نشط

$365.00

-

كابل بصري نشط Mellanox MFS1S00-H005E بطول 5 متر (16 قدمًا) 200 جرام HDR QSFP56 إلى QSFP56 كابل بصري نشط

$355.00

كابل بصري نشط Mellanox MFS1S00-H005E بطول 5 متر (16 قدمًا) 200 جرام HDR QSFP56 إلى QSFP56 كابل بصري نشط

$355.00

-

Mellanox MCP1650-H003E26 متوافق 3m (10 قدم) Infiniband HDR 200G QSFP56 إلى QSFP56 PAM4 كبل Twinax نحاسي سلبي مباشر

$80.00

Mellanox MCP1650-H003E26 متوافق 3m (10 قدم) Infiniband HDR 200G QSFP56 إلى QSFP56 PAM4 كبل Twinax نحاسي سلبي مباشر

$80.00

-

Mellanox MCP1600-E01AE30 متوافق 1.5 متر InfiniBand EDR 100G QSFP28 إلى QSFP28 كابل نحاسي مباشر

$35.00

Mellanox MCP1600-E01AE30 متوافق 1.5 متر InfiniBand EDR 100G QSFP28 إلى QSFP28 كابل نحاسي مباشر

$35.00

-

Mellanox MCP1600-E002E30 متوافق 2m InfiniBand EDR 100G QSFP28 إلى QSFP28 كابل نحاسي مباشر

$35.00

Mellanox MCP1600-E002E30 متوافق 2m InfiniBand EDR 100G QSFP28 إلى QSFP28 كابل نحاسي مباشر

$35.00

-

HPE (Mellanox) P06248-B22 متوافق مع 1.5 متر (5 أقدام) Infiniband HDR 200G QSFP56 إلى 2x100G QSFP56 PAM4

$80.00

HPE (Mellanox) P06248-B22 متوافق مع 1.5 متر (5 أقدام) Infiniband HDR 200G QSFP56 إلى 2x100G QSFP56 PAM4

$80.00

-

Mellanox MC220731V-025 متوافق مع 25 مترًا (82 قدمًا) 56 جيجا FDR QSFP + إلى QSFP + كابل بصري نشط

$99.00

Mellanox MC220731V-025 متوافق مع 25 مترًا (82 قدمًا) 56 جيجا FDR QSFP + إلى QSFP + كابل بصري نشط

$99.00

-

Mellanox MC2207130-004 متوافق مع 4 أمتار (13 قدمًا) 56 جرام FDR QSFP + إلى QSFP + كابل توصيل مباشر نحاسي

$45.00

Mellanox MC2207130-004 متوافق مع 4 أمتار (13 قدمًا) 56 جرام FDR QSFP + إلى QSFP + كابل توصيل مباشر نحاسي

$45.00

-

بطاقة مهايئ NVIDIA Mellanox MCX653105A-HDAT-SP ConnectX-6 InfiniBand / VPI ، HDR / 200GbE ، منفذ واحد QSFP56 ، PCIe3.0 / 4.0 x16 ، حامل طويل القامة

$1400.00

بطاقة مهايئ NVIDIA Mellanox MCX653105A-HDAT-SP ConnectX-6 InfiniBand / VPI ، HDR / 200GbE ، منفذ واحد QSFP56 ، PCIe3.0 / 4.0 x16 ، حامل طويل القامة

$1400.00

-

بطاقة مهايئ NVIDIA Mellanox MCX653105A-ECAT-SP ConnectX-6 InfiniBand / VPI ، HDR100 / EDR / 100G ، منفذ واحد QSFP56 ، PCIe3.0 / 4.0 x16 ، حامل طويل

$965.00

بطاقة مهايئ NVIDIA Mellanox MCX653105A-ECAT-SP ConnectX-6 InfiniBand / VPI ، HDR100 / EDR / 100G ، منفذ واحد QSFP56 ، PCIe3.0 / 4.0 x16 ، حامل طويل

$965.00

-

بطاقة مهايئ NVIDIA Mellanox MCX653106A-ECAT-SP ConnectX-6 InfiniBand / VPI ، HDR100 / EDR / 100G ، ثنائي المنافذ QSFP56 ، PCIe3.0 / 4.0 x16 ، حامل طويل

$828.00

بطاقة مهايئ NVIDIA Mellanox MCX653106A-ECAT-SP ConnectX-6 InfiniBand / VPI ، HDR100 / EDR / 100G ، ثنائي المنافذ QSFP56 ، PCIe3.0 / 4.0 x16 ، حامل طويل

$828.00

-

NVIDIA Mellanox MCX621102AN-ADAT SmartNIC ConnectX®-6 Dx Ethernet بطاقة واجهة الشبكة ، 1/10 / 25GbE Dual-Port SFP28 ، Gen 4.0 x8 ، طويل وقصر قصير

$315.00

NVIDIA Mellanox MCX621102AN-ADAT SmartNIC ConnectX®-6 Dx Ethernet بطاقة واجهة الشبكة ، 1/10 / 25GbE Dual-Port SFP28 ، Gen 4.0 x8 ، طويل وقصر قصير

$315.00

-

NVIDIA Mellanox MCX631102AN-ADAT SmartNIC ConnectX®-6 Lx Ethernet Network Interface Card، 1/10 / 25GbE Dual-Port SFP28، Gen 4.0 x8، طويل وقصر قصير

$385.00

NVIDIA Mellanox MCX631102AN-ADAT SmartNIC ConnectX®-6 Lx Ethernet Network Interface Card، 1/10 / 25GbE Dual-Port SFP28، Gen 4.0 x8، طويل وقصر قصير

$385.00

-

NVIDIA Mellanox MCX4121A-ACAT متوافق مع ConnectX-4 Lx EN Network Adapter ، 25GbE Dual-Port SFP28 ، PCIe3.0 x 8 ، طويل وقصر قصير

$249.00

NVIDIA Mellanox MCX4121A-ACAT متوافق مع ConnectX-4 Lx EN Network Adapter ، 25GbE Dual-Port SFP28 ، PCIe3.0 x 8 ، طويل وقصر قصير

$249.00